Según la firma analista Business Research Company, el tamaño del mercado de Apache Hadoop ha experimentado un crecimiento exponencial en los últimos años. Hablamos de un salto de 196.530 millones de dólares en 2025 a más de 740.790 millones para 2029. ¿Qué razones están detrás de este crecimiento?

Las respuestas, como casi siempre ocurre, se deben a múltiples factores que van desde la explosión de los datos, la creciente adopción del código abierto, la disponibilidad de plataformas más asequibles en la nube y las mayores capacidades de procesamiento de equipos y software. Estos elementos también reflejan las tendencias del Big Data, marcadas por la evolución de tecnologías como Hadoop y su rol en ecosistemas empresariales.

Para entender un poco más sobre el impacto, beneficios y funcionamiento de esta tecnología, hemos realizado esta guía.

Índice de temas

¿Qué es Apache Hadoop y cómo funciona su arquitectura distribuida?

La biblioteca de software Apache Hadoop es definida como “un marco que permite el procesamiento distribuido de grandes conjuntos de datos en clústeres de computadoras utilizando modelos de programación sencillos. Está diseñada para escalar desde servidores individuales hasta miles de máquinas, cada una de las cuales ofrece computación y almacenamiento locales”.

En lugar de depender del hardware para ofrecer alta disponibilidad, la biblioteca en sí está diseñada para detectar y gestionar fallos en la capa de aplicación, lo que permite ofrecer un servicio de alta disponibilidad sobre un clúster de ordenadores, cada uno de los cuales puede ser propenso a fallos.

La arquitectura distribuida de Hadoop se basa en la división de grandes problemas computacionales y el almacenamiento de datos en tareas y bloques de datos más pequeños y manejables. Estos se distribuyen y ejecutan en un clúster de máquinas interconectadas, lo que permite el procesamiento paralelo y mejora significativamente la eficiencia.

Un principio clave es la localidad de los datos, donde las tareas computacionales se ejecutan preferentemente en los nodos donde residen los datos relevantes, minimizando el movimiento de datos a través de la red y mejorando el rendimiento general.

La tolerancia a fallos es una característica crítica de Hadoop, lograda a nivel de aplicación en lugar de depender de hardware especializado costoso. La propia biblioteca de Hadoop está diseñada para detectar y manejar fallos de máquinas individuales dentro del clúster , asegurando la continuidad del servicio y la integridad de los datos incluso con hardware básico.

¿Cuáles son los componentes principales del ecosistema Hadoop y qué funciones cumplen?

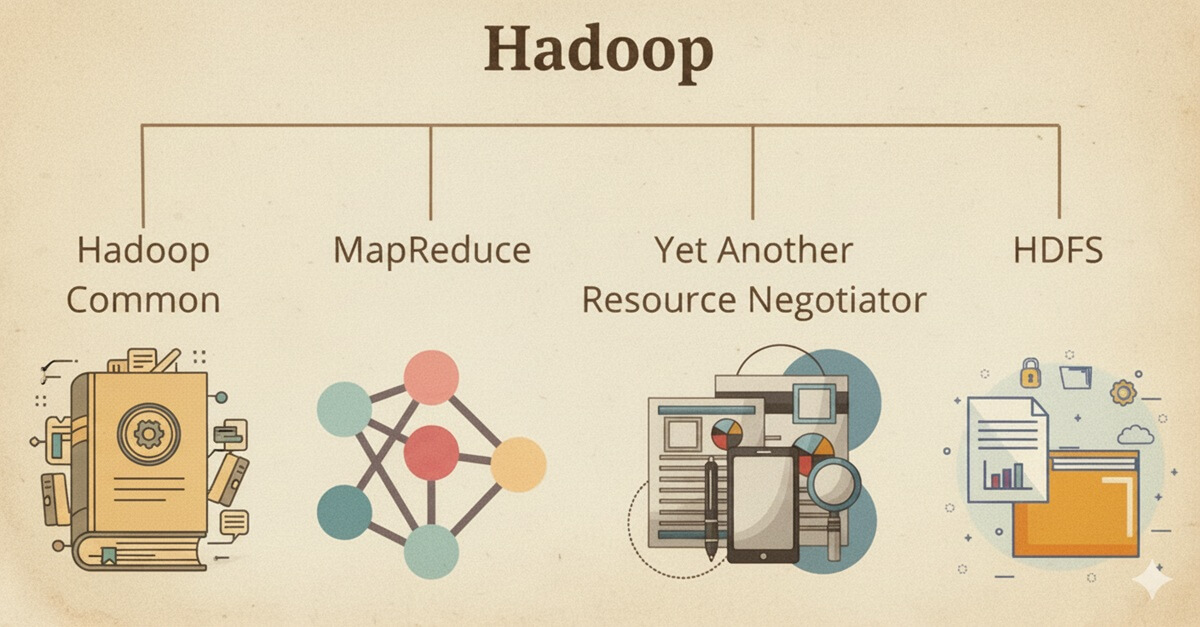

El núcleo del framework Hadoop está compuesto por cuatro módulos principales: Hadoop Distributed File System (HDFS), Hadoop MapReduce, Hadoop YARN y Hadoop Common (o Hadoop Core). Más allá de estos, Hadoop cuenta con un vasto ecosistema de herramientas complementarias que amplían significativamente sus capacidadess.

HDFS es la unidad de almacenamiento de Hadoop, un sistema de archivos distribuido, escalable y portátil que facilita el acceso de alto rendimiento a los datos de las aplicaciones mediante el procesamiento paralelo de fragmentos de datos. Su fiabilidad se basa en la redundancia de datos y la tolerancia a fallos, logradas mediante la replicación automática de bloques de datos en varios nodos.

MapReduce es un modelo de programación y framework para procesar y generar grandes conjuntos de datos en un entorno distribuido. Simplifica la programación distribuida en dos pasos: Map (divide los datos de entrada en bloques, los asigna a mappers, realiza filtrado y ordenación, y produce pares clave-valor intermedios) y Reduce (agrega o resume los valores asociados a una clave específica para producir la salida final ). Entre Map y Reduce, se realizan fases cruciales como Shuffle (redistribuye datos a los reducers), Combine (opcionalmente pre-agrega datos localmente en el mapper ) y Partition (asigna pares clave-valor a reducers específicos).

YARN (Yet Another Resource Negotiator), introducido en Hadoop 2.0, es un framework robusto para la programación de trabajos y la gestión de recursos del clúster. Desacopla la gestión de recursos de la programación de trabajos, mejorando drásticamente la escalabilidad y flexibilidad. Esto permite que múltiples motores de procesamiento como Apache Spark y Apache Tez operan concurrentemente en el mismo clúster Hadoop, optimizando la utilización de recursos y gestionando diversas cargas de trabajo en una infraestructura unificada.

Hadoop Common (o Hadoop Core) es otro pilar esencial del framework. Consiste en un conjunto de bibliotecas y utilidades compartidas que sustentan otros módulos clave como HDFS, YARN y MapReduce, proporcionando funcionalidades y herramientas fundamentales para el funcionamiento del sistema.

Otros elementos de Apache se pueden ver en la siguiente tabla:

| Componente | Categoría | Función Principal |

| Apache Pig | Procesamiento de Datos | Plataforma de alto nivel para crear programas MapReduce usando scripts Pig Latin. |

| Apache Hive | Almacenamiento de Datos | Proporciona un lenguaje de consulta tipo SQL (HiveQL) para resumen de datos y análisis ad hoc en HDFS. |

| Apache HBase | Base de Datos NoSQL | Base de datos no relacional escalable y distribuida para acceso en tiempo real a grandes tablas en HDFS. |

| Apache Spark | Motor de Procesamiento | Motor de computación en clúster rápido y de propósito general para procesamiento en memoria, análisis, ML y streaming. |

| Apache Flume | Ingesta de Datos | Recopila, agrega y mueve grandes cantidades de datos de streaming a Hadoop. |

| Apache Sqoop | Integración de Datos | Transfiere datos masivos entre Hadoop y bases de datos relacionales/almacenes de datos. |

| Apache Oozie | Gestión de Flujos de Trabajo | Programa y gestiona trabajos de Hadoop como flujos de trabajo (DAGs). |

| Apache Mahout | Machine Learning | Biblioteca escalable de algoritmos de machine learning y minería de datos. |

| Apache Ozone | Almacenamiento | Almacén de objetos escalable, redundante y distribuido para Hadoop. |

| Apache Tez | Framework de Procesamiento | Framework de programación de flujo de datos generalizado para ejecutar DAGs en YARN. |

| Apache ZooKeeper | Servicio de Coordinación | Servicio centralizado para sincronización distribuida y gestión de configuración. |

¿Qué ventajas ofrece Hadoop en el procesamiento de grandes volúmenes de datos?

Apache Hadoop ha sido ampliamente adoptado por su capacidad para gestionar grandes volúmenes de datos de forma eficiente y rentable, lo que le ha permitido acaparar un 11,79 % del mercado de análisis de big data. Un nicho donde es un actor importante y compite con plataformas como Databricks, Azure Databricks y Talend. Este crecimiento también se explica por el auge del Big Data en entornos empresariales, la adopción de nuevas herramientas de análisis de datos para decisiones clave, la incorporación de Business Analytics e inteligencia de negocios, y el avance en el almacenamiento de datos sin pérdidas ni sobrecostos, todos habilitados por ecosistemas como Hadoop.

- Escalabilidad horizontal: Permite manejar desde gigabytes hasta petabytes de datos añadiendo nodos con hardware básico, sin necesidad de rediseñar la arquitectura.

- Procesamiento paralelo: Utiliza MapReduce y HDFS para dividir tareas en subtareas que se ejecutan simultáneamente, acelerando el análisis.

- Alta tolerancia a fallos: HDFS replica automáticamente los datos (por defecto en tres nodos), asegurando disponibilidad continua incluso ante fallos de hardware o software.

- Flexibilidad en el almacenamiento: Admite datos estructurados, semiestructurados y no estructurados (texto, imágenes, videos), permitiendo la creación de data lakes adaptables.

- Costo reducido: Al ser de código abierto y funcionar con hardware económico, elimina costos de licencias, haciendo accesible el big data para organizaciones de todos los tamaños.

Esta flexibilidad permite a las empresas adaptarse al crecimiento del volumen de datos sin un rediseño significativo en su infraestructura además de ofrecer una alta resiliencia y tolerancia a fallos. Esta resiliencia se debe esencialmente a que los datos almacenados en cualquier nodo se replican automáticamente en otros nodos (normalmente tres copias por defecto) lo que garantiza la alta disponibilidad y la tolerancia a fallos.

¿Cuáles son las limitaciones o desafíos asociados al uso de Hadoop?

A pesar de sus considerables ventajas, Apache Hadoop, en particular su framework fundamental MapReduce, presenta varias limitaciones y desafíos que las organizaciones deben tener en cuenta.

Un problema significativo es su ineficiencia con archivos pequeños. HDFS está optimizado para manejar un número pequeño de archivos muy grandes, no un gran número de archivos pequeños.Cada archivo, directorio y bloque en HDFS ocupa un elemento de memoria en el NameNode, lo que significa que el almacenamiento de millones de archivos pequeños puede agotar la memoria, limitando la escalabilidad

Otra limitación es la lentitud en la velocidad de procesamiento y la alta latencia de MapReduce. Esto se debe en gran parte a su naturaleza intensiva en disco: en cada etapa del procesamiento, MapReduce lee datos del disco y escribe los resultados intermedios de nuevo en el disco.

Además, el framework MapReduce de Hadoop está diseñado inherentemente para el procesamiento por lotes. No está construido para manejar datos en streaming o en tiempo real de manera eficiente. Esto implica que la información se genera con un retraso significativo, lo que lo hace inadecuado para aplicaciones que requieren análisis de datos inmediatos, como el análisis de sentimientos en tiempo real de las redes sociales.

Otro punto a considerar es la curva de aprendizaje pronunciada de un ecosistema tan diverso. La gestión y optimización de un clúster Hadoop distribuido exige habilidades y experiencia especializadas, lo que contribuye a la sobrecarga administrativa.

¿En qué escenarios empresariales es más recomendable implementarlo?

Uno de los usos más extendidos de Hadoop en el entorno corporativo es el análisis de registros y flujos de clics, especialmente en plataformas de comercio electrónico. Estas generan enormes volúmenes de datos sobre el comportamiento de los usuarios, desde visitas hasta patrones de navegación.

Gracias a herramientas como Apache Flume, estos datos pueden integrarse en HDFS y ser analizados con frameworks como Spark o MapReduce, permitiendo optimizar la experiencia del cliente, mejorar la conversión y personalizar la oferta comercial.

El marketing orientado por datos también ha encontrado en Hadoop un recurso esencial. Las compañías utilizan la plataforma para procesar grandes cantidades de información sobre sus clientes, incluyendo historiales de compra, características demográficas e interacciones digitales. A partir de este análisis, es posible segmentar audiencias, afinar campañas y comprender el sentimiento del cliente, incluso en redes sociales, favoreciendo una toma de decisiones más precisa y basada en evidencia.

Hadoop también sirve como base para el desarrollo de proyectos de Machine Learning y minería de datos a gran escala. Los científicos de datos emplean su capacidad de almacenamiento distribuido para preparar conjuntos masivos de datos que alimentan modelos predictivos, utilizando herramientas clave en el ámbito del data science empresarial. Esta infraestructura también es útil para ejecutar proyectos complejos de analítica de datos en las empresas y gestionar flujos con plataformas visuales como MySQL Workbench, lo cual simplifica la administración de bases de datos distribuidas sobre Hadoop.

En el sector financiero, Hadoop ha demostrado ser particularmente eficaz en la detección de fraude. Instituciones bancarias y compañías aseguradoras utilizan la plataforma para almacenar logs de transacciones y perfiles de usuarios, sobre los cuales se aplican modelos de IA que identifican comportamientos sospechosos en tiempo real. Esta capacidad de respuesta inmediata es crucial en un entorno donde la rapidez en la detección puede marcar la diferencia entre una amenaza contenida y una pérdida millonaria.

Más allá del comercio y las finanzas, Hadoop también respalda procesos en sectores como salud, ciberseguridad, industria y transporte. Desde el análisis de datos clínicos hasta la gestión predictiva de mantenimiento industrial, la plataforma sigue demostrando su valor como infraestructura flexible, escalable y preparada para afrontar los desafíos del big data en el entorno empresarial.

¿Cómo se compara Hadoop con Apache Spark en términos de rendimiento y casos de uso?

Apache Hadoop y Apache Spark son tecnologías fundamentales en el panorama del big data, pero cumplen propósitos primarios distintos y muestran diferencias clave en su arquitectura, características de rendimiento y casos de uso ideales. Frecuentemente, Spark se implementa como una tecnología complementaria dentro del ecosistema Hadoop, aprovechando las capacidades de almacenamiento de Hadoop.

La diferencia más relevante entre Hadoop MapReduce y Apache Spark radica en su enfoque de procesamiento y desempeño. Hadoop MapReduce fue concebido como un motor de procesamiento por lotes. Su modelo implica leer los datos desde el almacenamiento, ejecutar las operaciones necesarias y volver a escribir los resultados intermedios en disco tras cada etapa. Esta constante interacción con el sistema de archivos incrementa la latencia, lo que lo hace más adecuado para tareas donde el tiempo de respuesta no es crítico, como el análisis mensual de registros o informes históricos.

Por su parte, Apache Spark ha sido diseñado para ofrecer un alto rendimiento, especialmente en escenarios que requieren rapidez y procesamiento en tiempo real. Gracias a su capacidad para almacenar los datos en memoria (RAM), Spark reduce significativamente los tiempos de lectura y escritura, ya que solo recurre al almacenamiento externo al finalizar una tarea. Este enfoque, sumado a su motor de ejecución le permite ejecutar procesos hasta 100 veces más rápido que Hadoop MapReduce en ciertas condiciones, especialmente cuando se trata de operaciones iterativas.

Dadas sus características, sus casos de uso ideales divergen. Hadoop MapReduce sobresale en escenarios que requieren análisis avanzados de conjuntos de datos masivos y almacenados, donde el procesamiento por lotes con retrasos de tiempo tolerables es aceptable. Esto incluye operaciones ETL a gran escala, análisis de logs y archivo de datos históricos. Por su parte, Spark, con su procesamiento en memoria y capacidades en tiempo real, es preferido para casos de uso que exigen respuestas de baja latencia. Esto incluye análisis en tiempo real, exploración interactiva de datos, procesamiento de eventos complejos, procesamiento de streaming y cargas de trabajo de machine learning donde las computaciones iterativas son comunes.

¿Qué consideraciones se deben tener al migrar a una solución basada en Hadoop?

La adopción de una solución basada en Hadoop o en cualquier plataforma de big data distribuida requiere una planificación estratégica rigurosa y una comprensión clara de las capacidades y necesidades específicas de datos de la organización. Como primer paso, es fundamental definir con precisión los objetivos estratégicos del negocio. Esto implica identificar con claridad los problemas que se busca resolver mediante el uso de Big Data, como mejorar la experiencia del cliente, optimizar las operaciones o impulsar capacidades analíticas avanzadas.

La estrategia de migración debe estar plenamente alineada con estos objetivos empresariales, y debe iniciar con una evaluación integral del entorno de datos actual, considerando formatos, volúmenes y patrones de acceso. Esta etapa es clave para garantizar una transición efectiva, especialmente si se contempla la implementación de SGBD robustos, sistemas NoSQL para datos no estructurados, data lakes empresariales, modelos de bases de datos relacionales (RDBMS) y estrategias de almacenamiento escalable dentro de un entorno distribuido como Hadoop.

En segundo lugar, es crucial contar con una visión completa del panorama de los datos. Esto abarca la identificación de los tipos de datos (estructurados, semiestructurados y no estructurados), sus volúmenes (de gigabytes a petabytes), la velocidad requerida (procesamiento por lotes o en tiempo real) y la variedad de fuentes. La flexibilidad de Hadoop para manejar múltiples formatos de datos lo hace ideal para soluciones como data lakes, pero las características específicas de los datos influyen directamente en la selección de los componentes adecuados del ecosistema.

La planificación de la infraestructura tecnológica y su integración con la nube son elementos estratégicos. Aunque Hadoop fue diseñado originalmente para funcionar sobre hardware económico, hoy muchas organizaciones optan por plataformas en la nube como AWS, Azure o Google Cloud debido a su escalabilidad, eficiencia en costos y servicios gestionados. Esta decisión requiere analizar factores como la asignación de recursos, la topología de red y la elección entre implementaciones locales, en la nube o híbridas.

Por todas estas ventajas, expertos como Mike Gualtieri, antiguo vicepresidente y analista principal de Forrester Research, explica en su “Hadoop Is The Aorta Of Your Modern Data Platform“: como Hadoop es una tecnología fundamental para las plataformas de datos empresariales, una con futuro para tapas las empresas.