¿Qué tanto conocemos la Inteligencia Artificial y cómo funciona? A medida que los modelos generativos se integran en procesos empresariales, crece también nuestra confianza en sus respuestas.

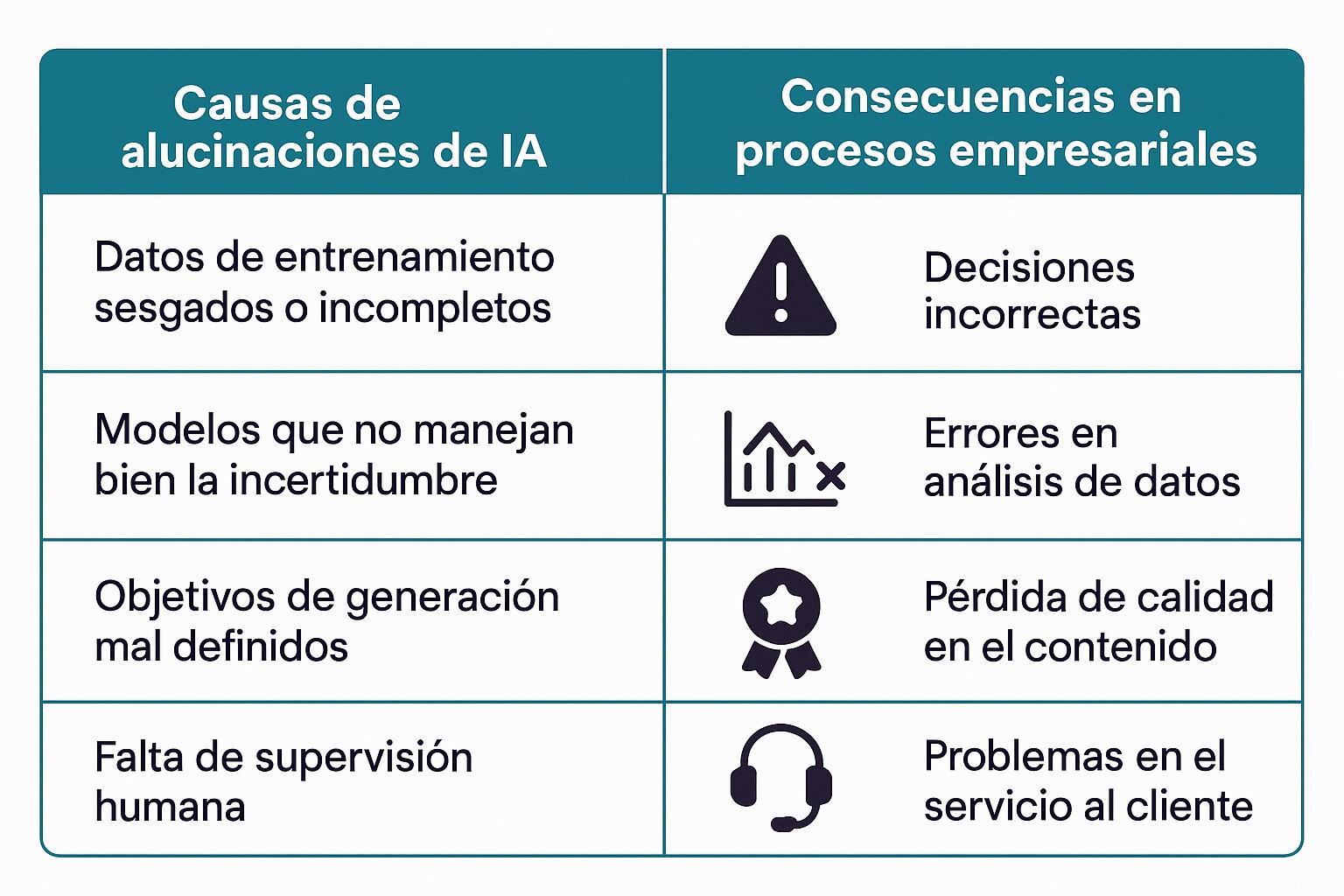

Pero, al igual que ocurre en nuestras interacciones cotidianas, también deberíamos desarrollar la capacidad de discernir la información que, incluso una IA, puede llegar a generar. Las alucinaciones en IA pueden hacerse presentes en las empresas y esto puede significar un gran problema para los procesos de trabajo.

Así es como uno de los mayores desafíos actuales en el uso corporativo de la IA es el fenómeno de las alucinaciones: respuestas que suenan correctas, pero que son falsas. Tal como sucede en algunas aplicaciones de IA que están transformando los negocios, estas inexactitudes, lejos de ser un error técnico menor, pueden distorsionar decisiones críticas y comprometer la integridad de procesos empresariales.

Comprender qué las causa y cómo evitarlas es el primer paso hacia una adopción responsable y consciente de la IA, como también ocurre en el uso de GANs en inteligencia artificial generativa para crear contenidos y simulaciones.

Índice de temas

¿Qué son las alucinaciones en modelos de IA y por qué representan un riesgo empresarial?

Las alucinaciones en IA son errores donde modelos generativos fabrican información plausible pero incorrecta, presentándola con alta confianza. Estas inexactitudes pueden comprometer decisiones, reputación y cumplimiento normativo. Gartner advierte que estas alucinaciones de la Inteligencia Artificial pueden comprometer no solo la toma de decisiones, sino también la reputación de la marca.

Un reporte del Instituto Nacional de Estándares y Tecnología de EE. UU. (NIST, por sus siglas en inglés) identifica a las alucinaciones como uno de los riesgos emergentes en soluciones de IA generativa, que pueden comprometer la integridad del ciclo de decisiones automatizadas en sectores como finanzas, salud o recursos humanos, donde los errores pueden tener consecuencias regulatorias y operativas relevantes.

A ello se suman los riesgos legales y reputacionales. De acuerdo con la Facultad de Derecho Global de Purdue, la primera facultad de derecho completamente en línea de los Estados Unidos, expertos en riesgo corporativo, vinculados a universidades y estudios de abogados, advierten que la difusión de información errónea generada por IA puede exponer a las empresas a demandas por fraude, difamación o incumplimiento de normas de protección al consumidor.

Reconocer que las alucinaciones en IA no solo son posibles, sino frecuentes, es clave para construir confianza informada. No se trata de desechar el uso de la IA, sino de asumirlo con responsabilidad, tal como recomienda el enfoque de AGI para el futuro de la inteligencia artificial en negocios.

¿En qué áreas de negocio son más críticas las alucinaciones generadas por IA?

El riesgo de alucinación en los modelos de IA no es uniforme: depende en gran medida del tipo de tarea que se le asigna al sistema. Generar texto, resumir, transcribir audio, automatizar interacciones con chatbots AI, responder preguntas legales o interpretar datos conllevan distintos niveles y formas de error. Por eso, en contextos empresariales, es fundamental entender qué tipo de fallo puede surgir según la aplicación concreta de la IA.

La siguiente tabla presenta una comparación entre sectores, el tipo de errores más frecuentes y sus posibles impactos:

| Sector | Tipo de error (alucinación) | Impacto potencial |

| Legal | Referencias falsas o precedentes jurídicos inexistentes (17–33 % de error con RAG) | Decisiones legales erradas, incumplimientos normativos, riesgo de demandas por fraude o negligencia |

| Servicio al cliente | Respuestas incorrectas o confusas en chatbots | Erosión de la confianza, pérdida de clientes, daño reputacional |

| Salud / Transcripción | Datos fabricados o distorsionados en transcripciones médicas (1.4 % de error en Whisper) | Diagnósticos imprecisos, riesgo clínico, problemas éticos y legales |

| Análisis ejecutivo | Generación de datos inexactos o engañosos en reportes o dashboards | Toma de decisiones basada en datos erróneos, fallas estratégicas, afectación financiera |

| Recursos humanos | Automatización sesgada o generación de perfiles falsos por confianza excesiva en IA | Contrataciones inadecuadas, discriminación inadvertida, riesgos legales por sesgos algorítmicos. |

| Educación | Producción de información falsa en resúmenes, explicaciones o contenido académico generado por IA | Formación deficiente, pérdida de credibilidad de herramientas educativas y perpetuación de errores. |

No todas las tareas implican el mismo nivel de complejidad cognitiva ni el mismo margen de tolerancia al error; por ello, es clave evaluar qué tipo de procesos se le están delegando al sistema, como se plantea en IA en Colombia con casos de éxito recientes.

Esta distinción no solo ayuda a mitigar impactos negativos, sino que también orienta sobre qué técnicas —como la recuperación aumentada de información (RAG), el control humano o el ajuste fino— pueden ser más efectivas para lograr que la IA produzca respuestas verdaderas, relevantes y seguras según el contexto, alineadas con enfoques de NLP para mejorar procesos empresariales.

¿Qué tecnologías o estrategias ayudan a mitigar las alucinaciones en modelos generativos?

Las alucinaciones no son simples errores anecdóticos en la producción de contenido por parte de la IA generativa; son el resultado de cómo estos modelos aprenden, generalizan y completan información basada en patrones estadísticos, no en hechos contrastados

Esto ha impulsado el desarrollo de diversas estrategias y tecnologías que buscan reforzar la veracidad y fiabilidad del contenido generado, como el uso de deep learning para optimizar procesos empresariales. Algunas de ellas son:

- Retrieval‑Augmented Generation (RAG): Esta arquitectura combina un modelo generativo con acceso en tiempo real a bases de conocimiento autorizadas, lo que permite anclar las respuestas en datos verificados. Aunque reduce significativamente la tasa de errores, su efectividad depende de la calidad del índice, la base de datos y la curación continua del repositorio de conocimiento.

- Modelos de detección en tiempo real (reference‑free): Un estudio compartido por el repositorio digital de acceso abierto arxiv presenta evaluadores automáticos (p. ej. LLM-as‑a‑Judge, HHEM, TLM) que pueden identificar respuestas incorrectas con alta precisión y sin necesidad de etiquetas humanas predefinidas.

- Curación y selección rigurosa de datasets: Khmaïess Al Jannadi, científico de datos, recomienda emplear conjuntos de datos especializados, equilibrados y de alta calidad, además de filtrar contenido sensible o deficiente antes de entrenar o ajustar el modelo.

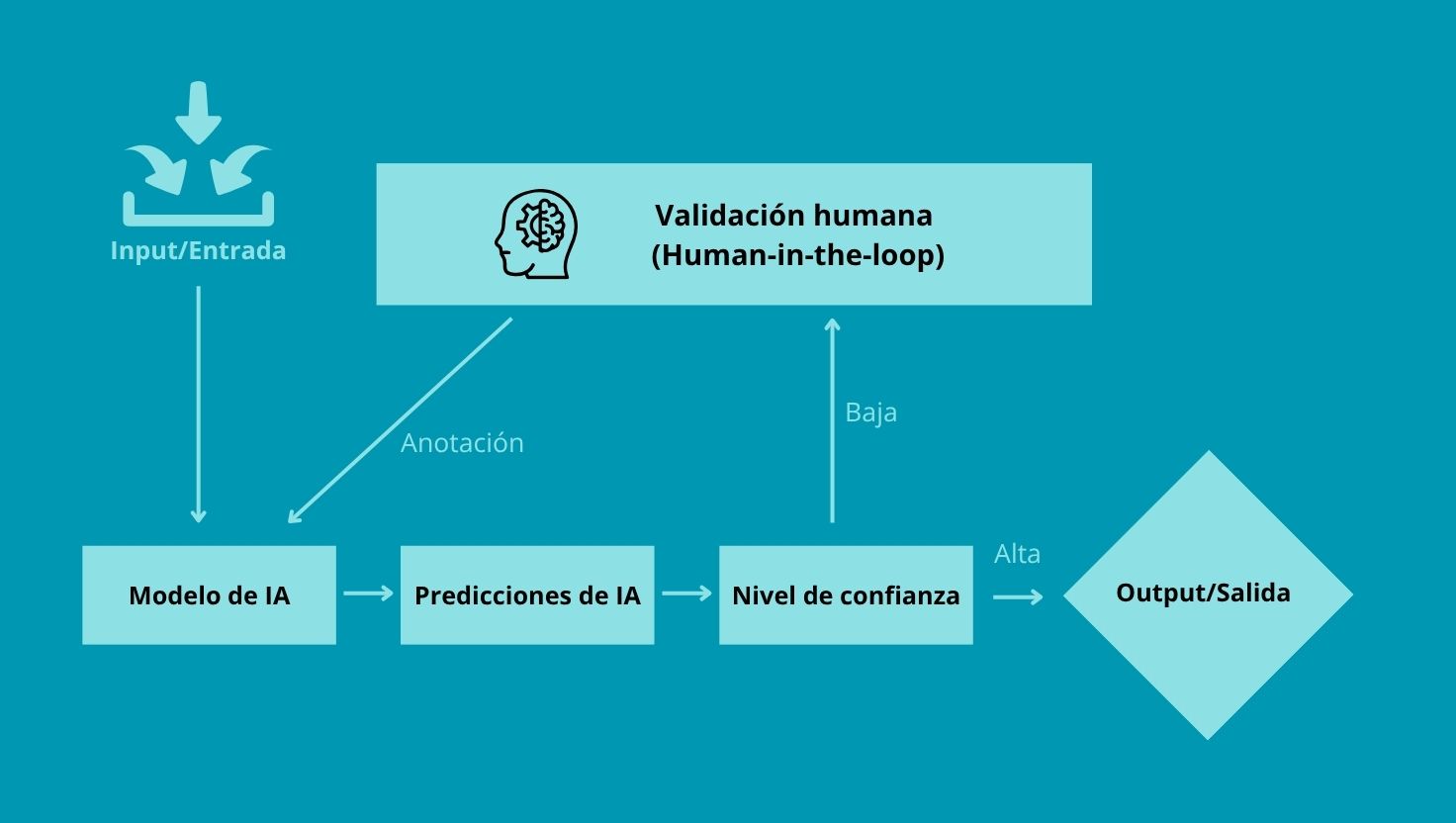

- Validación humana (Human-in-the-loop, HITL): Supervisores expertos revisan salidas críticas generadas por la IA, asegurando su relevancia, veracidad y adecuación al contexto.

- Sistemas híbridos y multi-modelo: Combinar múltiples fuentes de IA o integrar modelos simbológicos y estadísticos permite contrastar respuestas y reducir la dependencia de una única arquitectura, lo que endurece la fiabilidad general del sistema.

- Ingeniería de prompts y restricciones de salida: Estrategias como prompts encadenados (chain-of-thought), plantillas de respuesta o límites probabilísticos ayudan a enfocar la IA hacia salidas más estructuradas y vía pasos intermedios más verificables.

En entornos empresariales reales, la combinación entre RAG y validación humana ha demostrado reducir la tasa de alucinaciones hasta en un 54–68%, dependiendo del dominio, de acuerdo con estimaciones compartidas por Satyadhar Joshi, investigador independiente en análisis cuantitativo, especializado en riesgo financiero, ciencia de datos, aprendizaje automático e inteligencia artificial, y en línea con las estrategias de GenAI para revolucionar la automatización empresarial.

De esto se puede concluir que una gestión efectiva del problema requiere tanto mejoras técnicas como una adaptación en la cultura organizacional. Se trata, en última instancia, de implementar estrategias múltiples y complementarias.

Este checklist permite evaluar el avance de la empresa en buenas prácticas para mitigar alucinaciones:

| Buena práctica | Implementada (✔ / ✘) |

| Emplear RAG con base de conocimiento actualizada y bien curada | |

| Integrar detección automática de errores (modelos real‑time de RAG) | |

| Usar datasets especializados, balanceados y de alta calidad | |

| Aplicar validación humana en salidas críticas (HITL) | |

| Diseñar prompts con estructura clara (chain-of-thought, plantillas) | |

| Implementar límites o filtros en las respuestas generadas | |

| Usar arquitecturas híbridas o multi-modelo para redundancia |

¿Cómo afecta la presencia de alucinaciones en IA a la toma de decisiones basada en datos?

En modelos generativos utilizados para dashboards ejecutivos, análisis predictivos o sistemas automatizados, errores sutiles —como datos inventados o conclusiones no verificables— pueden alterar indicadores clave de desempeño (KPIs), llevar a interpretaciones erróneas y, en el peor de los casos, a decisiones desacertadas.

De acuerdo con un artículo publicado por el Centro Nacional de Información Biotecnológica (NCBI, por sus siglas en inglés), en su archivo digital gratuito PMC (PubMed Central) de artículos de revistas biomédicas y de ciencias de la vida de los Institutos Nacionales de Salud (NIH) de EE. UU., la confianza ciega en outputs—resultados— generados por IA puede amplificar el riesgo de falsos positivos o negativos en modelos de clasificación y recomendación, especialmente en sectores como marketing, finanzas y operaciones logísticas.

Este tipo de errores puede presentar una apariencia convincente y coherente, pero carecer completamente de veracidad, generando un efecto de ‘bola de nieve’ que refuerza falsas conclusiones con outputs igualmente errados.

Como advierte Chris Callison-Burch, profesor en la Universidad de Pensilvania y especialista en procesamiento del lenguaje natural, “el desafío es producir resultados útiles y precisos sin socavar la capacidad de estos modelos para apoyar la ideación creativa”.

Los efectos son más evidentes en entornos donde se confía en dashboards automáticos o sistemas de recomendación: errores invisibles pueden propagarse, llevando a decisiones equivocadas, asignación de recursos mal dirigida o pérdida de valor competitivo, algo que puede prevenirse con estrategias de machine learning para optimizar procesos con lo último en IA.

También se genera una erosión de la confianza interna: cuando los usuarios detectan inconsistencias, disminuye la adopción de herramientas de IA y aumenta la demanda de auditoría manual.

Por eso, en la NCBI coinciden en que la validación cruzada, la auditoría de outputs y el diseño de circuitos de supervisión humana son pasos clave para mantener la fiabilidad de los procesos automatizados.

¿Qué preguntas deben hacerse los CIOs antes de implementar IA generativa en procesos críticos?

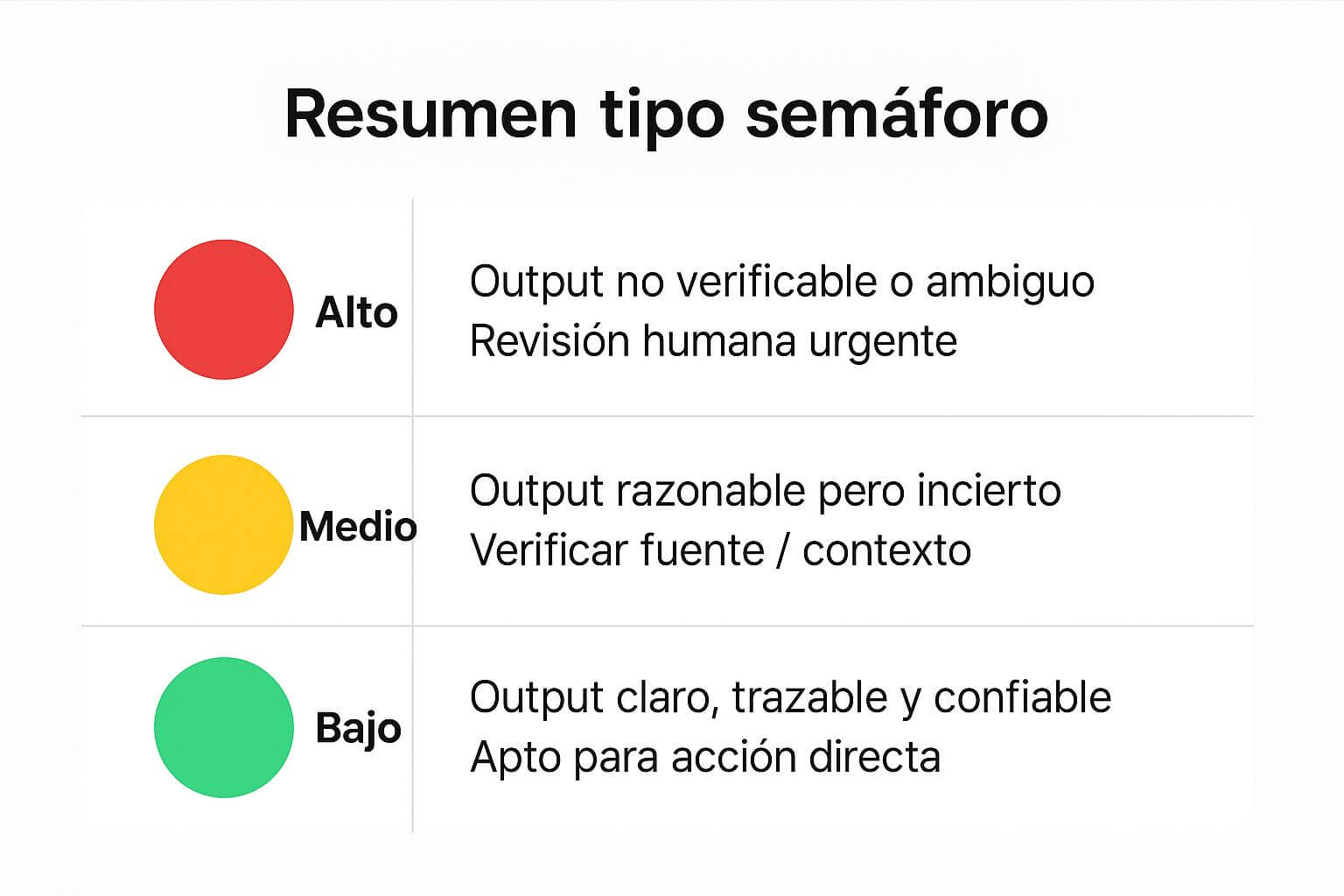

Antes de desplegar IA generativa en funciones sensibles o con impacto directo en operaciones clave, los CIOs deben plantearse un conjunto de preguntas estructuradas en torno a cuatro ejes fundamentales: riesgos, gobernanza, validación de salidas y trazabilidad.

Estas preguntas derivan del marco voluntario del AI Risk Management Framework (AI RMF) de NIST y recomendaciones emergentes del sector público y consultoras líderes.

El siguiente marco de evaluación permite a los CIOs anticipar los riesgos y asegurar una implementación responsable de IA generativa en procesos críticos:

| Dominio de evaluación | Preguntas clave para los CIOs |

| Riesgos y perfil de uso | ¿Cuál es el nivel de criticidad y exposición del proceso al sesgo, datos privados, seguridad o alucinaciones? ¿Cómo se recalibrarán los controles si cambian los usos o responsabilidades? |

| Gobernanza y roles | ¿Quién supervisará el cumplimiento y validez del sistema? ¿Tenemos un equipo multidisciplinario (TI, legal, riesgo, negocio) con autoridad definida? |

| Validación de salidas (outputs) | ¿Qué umbrales mínimos de precisión o error toleramos? ¿Cómo implementaremos revisiones humanas (HITL) o evaluadores automáticos antes de despliegues? |

| Trazabilidad y auditing | ¿Podemos rastrear el origen de cada salida generada (fuentes, versiones del modelo, prompt)? ¿Existe un registro de incidentes, errores reportados y acciones correctivas? |

Responder estas preguntas permite construir un marco robusto de evaluación previa a la implementación, clave para reducir riesgos y fortalecer la gobernanza de la IA generativa, apoyándose en prácticas de MLOps para la gestión eficiente de modelos de IA, como se describe en nuestro artículo inteligencia artificial en empresas: impacto y futuro.

Como lo señala el AI Index Report 2025 de Stanford HAI, “una mayor proporción de los incidentes relacionados con IA está ahora asociada a grandes empresas, lo que subraya la creciente responsabilidad de los actores corporativos en anticipar y gestionar consecuencias no deseadas”, tal como se refleja en la clasificación de tipos de inteligencia artificial y su impacto actual.

¿Qué diferencia a un modelo fiable de uno propenso a alucinaciones?

La propensión de un modelo de IA generativa a alucinar no es aleatoria. Está directamente relacionada con su arquitectura, el tipo de entrenamiento, la calidad de los datos y los mecanismos de control en la generación de respuestas.

Los modelos más básicos —como los LLMs desplegados sin recuperación aumentada (RAG)— tienden a generar contenido plausible pero incorrecto cuando no encuentran información suficiente en sus pesos entrenados—valores numéricos internos que el modelo ajusta durante su entrenamiento—, algo que puede mitigarse aplicando principios de ética de la IA para decisiones responsables.

El estudio “Alucinación por IA: hacia una clasificación exhaustiva de la información distorsionada en el contenido generado por inteligencia artificial” distingue entre arquitecturas propensas a alucinar y otras más robustas, destacando que el uso de datos de entrenamiento curados, combinados con técnicas como el fine-tuning orientado a tareas específicas, reducen drásticamente la aparición de errores.

Entre las más susceptibles se encuentran los modelos autoregresivos basados en transformadores (como GPT, LLaMA, Falcon o BLOOM), mientras que las arquitecturas híbridas con capacidades de verificación externa o acceso a fuentes dinámicas tienden a ser más confiables.

Por último, el informe del NIST enfatiza que la gestión de los datos de entrada (inputs) juega un rol central en la fiabilidad de las respuestas: prompts mal definidos, ambiguos o fuera del dominio de entrenamiento aumentan significativamente el riesgo de alucinaciones, como también ocurre en ámbitos de IA aplicada a ciberseguridad.

Lo cierto es que las plataformas más robustas hoy en día combinan múltiples capas de defensa: no solo arquitecturas híbridas, sino también controles humanos, restricciones de dominio y trazabilidad de fuente, en línea con la visión de la IA y la industria 5.0.

¿Cómo comunicar a los equipos no técnicos los límites de la IA para evitar una falsa confianza?

Como se mencionó antes, una gestión efectiva de los riesgos asociados a la IA también requiere de una adaptación en la cultura organizacional. Esto implica cambios en cómo se comunican y entienden las capacidades de la IA al interior de la empresa, como parte de iniciativas de XAI para inteligencia artificial explicable en negocios.

Estas son algunas prácticas recomendadas para stablecer estrategias de comunicación y formación claras:

- Capacitación en IA literacy adaptada al rol: Formar a los equipos en los límites, sesgos y alucinaciones comunes de la IA ayuda a reducir la sobreconfianza. Según el World Economic Forum, la alfabetización en IA ya es considerada una competencia esencial en todos los sectores, no solo en ingeniería.

- Mostrar niveles de confianza y calibración: Incluir indicadores visuales como “confianza estimada” o advertencias de incertidumbre en dashboards ayuda a interpretar mejor los outputs.

- Supervisión humana y auditoría de outputs: Los sistemas deben contar con circuitos de revisión periódica por parte de perfiles multidisciplinarios. La Asociación Internacional de Profesionales en Privacidad (IAPP, por sus siglas en inglés) señala que mantener al humano en el bucle no es opcional: es un estándar emergente para garantizar la calidad y la responsabilidad.

- Usar ejemplos claros y casos reales: Comunicar riesgos con ejemplos cercanos —como una predicción errada en un sistema de recomendación— es más efectivo que explicaciones técnicas.

Preguntas frecuentes sobre alucinaciones y fiabilidad en IA generativa

¿Qué controles regulatorios emergentes deben considerar las empresas al implementar IA generativa?

Las empresas deben atender marcos regulatorios como la AI Act de la Unión Europea, las directrices del NIST en EE. UU. y estándares sectoriales sobre transparencia, explicabilidad y gobernanza algorítmica, ya que la legislación evoluciona rápidamente para cubrir los riesgos de alucinaciones y toma de decisiones automatizada.

¿Cómo se mide el nivel de alucinaciones en un modelo de IA antes del despliegue?

El nivel de alucinaciones se mide mediante evaluaciones automatizadas, validación humana de outputs críticos, pruebas con datasets “fuera de dominio” y métricas como la precisión factual o la frecuencia de respuestas incorrectas en escenarios reales de uso.

¿Qué impacto pueden tener las alucinaciones de IA en auditorías o cumplimiento normativo?

Las alucinaciones pueden provocar inconsistencias en reportes, documentación y trazabilidad, dificultando auditorías y generando incumplimientos regulatorios que pueden derivar en sanciones, investigaciones o pérdida de certificaciones clave.

¿Se pueden mitigar las alucinaciones en IA solo con tecnología o es imprescindible cambiar procesos y cultura?

Mitigar alucinaciones requiere una combinación de soluciones tecnológicas (RAG, detección automática, validación humana) y cambios organizacionales: cultura de revisión, alfabetización en IA y políticas claras de gobernanza y escalado de incidentes.

¿Qué deben documentar los CIOs para garantizar la trazabilidad ante errores por IA?

Deben registrar versiones de modelos, fuentes de datos, prompts utilizados, incidencias reportadas y acciones correctivas, asegurando así la trazabilidad completa para revisiones internas o regulatorias.