En un entorno empresarial impulsado por la Inteligencia Artificial y por modelos IA con MLOps, , gestionar eficazmente los modelos de machine learning se ha convertido en una prioridad.

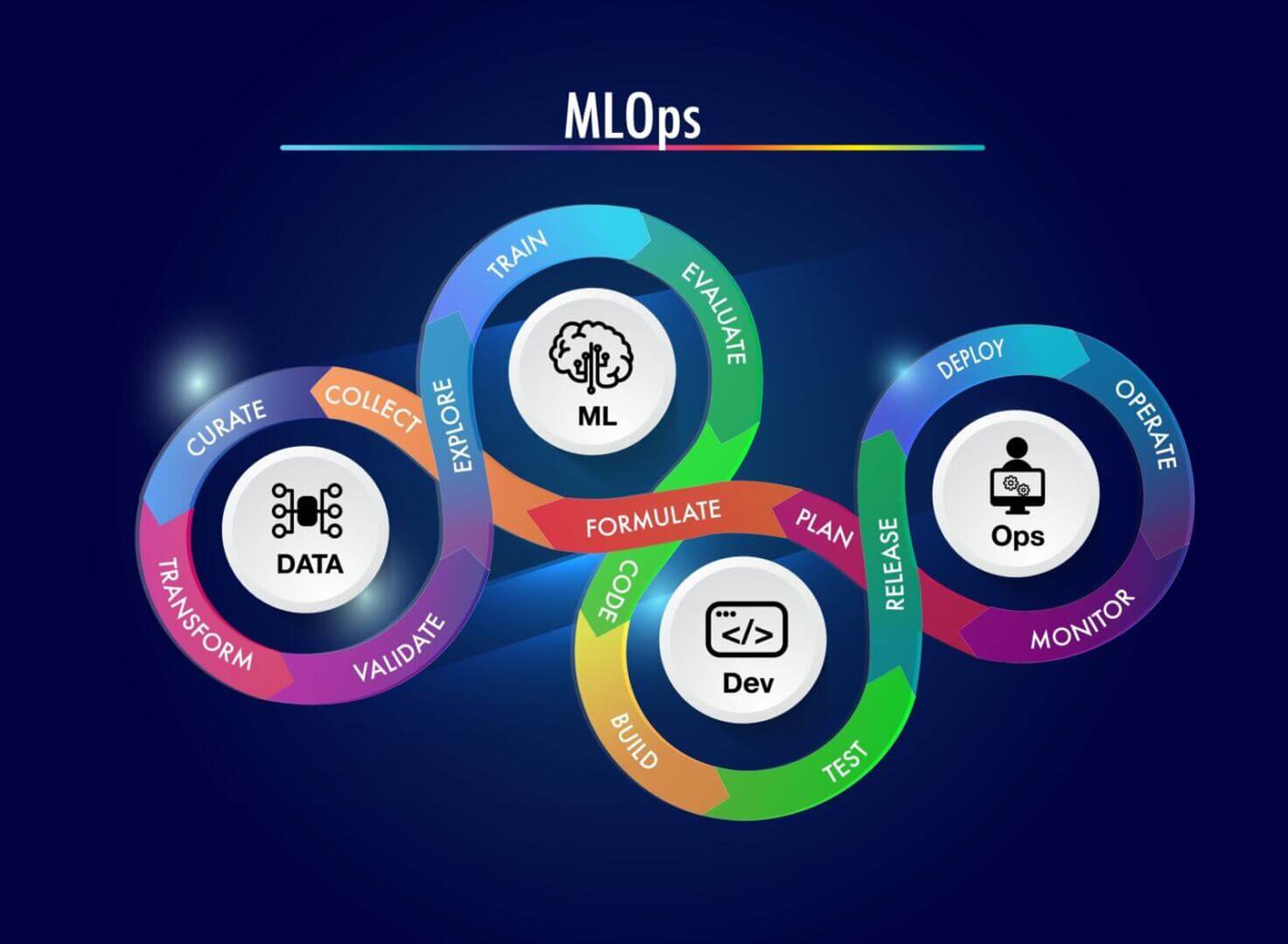

MLOps (Machine Learning Operations) es una disciplina que surge para responder a esta necesidad: combina el desarrollo de modelos de lenguaje (LLM) que impulsan negocios con las prácticas operativas, permitiendo su integración, monitoreo y escalamiento en producción.

Al implementar MLOps, las organizaciones logran automatizar flujos de trabajo, aumentar la precisión de sus modelos y optimizar recursos. Tecnologías como los modelos de lenguaje a gran escala (LLM) que impulsan negocios, la inteligencia artificial generativa con GANs en acción, la integración de chatbots AI para mejorar la experiencia del cliente y el impacto de la revolución GenAI en la automatización empresarial están transformando la forma en que las empresas automatizan y elevan sus procesos.

Índice de temas

¿Qué es MLOps y cómo integra Machine Learning con operaciones empresariales?

MLOps, o Operaciones de Aprendizaje Automático, es un conjunto de prácticas de Machine Learning (ML), DevOps e Ingeniería de Datos que busca automatizar y estandarizar el ciclo de vida completo de los modelos de IA, desde su desarrollo hasta su implementación y mantenimiento en producción.

Su objetivo principal es permitir a las empresas desplegar modelos de IA de forma eficiente, escalable, confiable y reproducible, integrando enfoques como tipos de inteligencia artificial y su impacto actual y machine learning para optimizar procesos empresariales, cerrando la brecha entre la experimentación y la operacionalización robusta en entornos empresariales.

Según Gartner, MLOps supera enfoques tradicionales al gestionar todo el ciclo de vida de IA, no solo modelos ML, incluyendo sistemas basados en reglas, procesamiento de lenguaje natural (NLP) y IA explicable para negocios (XAI).

La integración del Machine Learning en los procesos empresariales puede variar en complejidad según el grado de automatización existente. Cuanto mayor sea la madurez operativa de una organización, más fluida será la incorporación de modelos de ML en sus sistemas de producción.

Los siguientes son los tres niveles de integración posibles y sus características:

- Nivel 0. Procesos manuales y aislados: Este nivel corresponde a organizaciones que apenas inician en el uso de machine learning. El desarrollo es liderado por científicos de datos y cada paso —desde la preparación de datos hasta la implementación— se realiza de forma manual.

- Nivel 1. Automatización parcial con entrenamiento continuo: Ideal para empresas que desean actualizar modelos con datos nuevos de forma frecuente. En este nivel, se implementa una canalización automatizada de entrenamiento, permitiendo una entrega continua del modelo.

- Nivel 2. Automatización completa y escalable: Diseñado para organizaciones tecnológicas avanzadas que requieren entrenar y desplegar múltiples modelos de forma constante. Este nivel combina orquestación completa, versionamiento y monitoreo en tiempo real.

El siguiente diagrama resume algunas características del flujo de trabajo exploratorio y automatizado:

¿Cuáles son los beneficios de implementar MLOps en entornos empresariales?

La adopción de MLOps ofrece ventajas significativas para las empresas que buscan capitalizar el valor de la IA:

- Mayor velocidad y eficiencia: Automatiza tareas repetitivas, acelerando el tiempo de desarrollo y despliegue de modelos de días o meses a horas.

- Escalabilidad robusta: Facilita la gestión y operación de un gran número de modelos en producción de manera eficiente.

- Confiabilidad y reproducibilidad: Asegura la consistencia y calidad de los modelos mediante el versionado de datos, código y modelos, así como pipelines de entrenamiento y despliegue estandarizados.

- Mejora de la colaboración: Establece un lenguaje y procesos comunes entre equipos de datos, desarrollo y operaciones.

- Reducción de riesgos: Permite un monitoreo continuo del rendimiento del modelo y la detección temprana de problemas, como la deriva del modelo o sesgos, minimizando el impacto negativo.

- Gobernanza y cumplimiento: Facilita la auditoría, el seguimiento del linaje de los modelos y el cumplimiento de regulaciones mediante la documentación y el versionado automáticos, siguiendo lineamientos como el Marco de Gestión de Riesgos de IA del NIST (AI RMF).

En un artículo publicado por el Software Engineering Institute de Carnegie Mellon, Dan DeCapria, científico de datos sénior en la División de Inteligencia Artificial del instituto, destaca la importancia de MLOps como una disciplina clave para superar los desafíos inherentes al ciclo de vida de los modelos de aprendizaje automático (ML), incluyendo la prevención de alucinaciones en IA y sus riesgos para las empresas y el fortalecimiento de la IA en ciberseguridad.

Sumada a las características anteriores, según DeCapria, MLOps también aborda el monitoreo continuo del rendimiento de los modelos en producción y su reentrenamiento frente a desviaciones, promueve la colaboración interdisciplinaria entre científicos de datos, ingenieros y equipos de operaciones mediante un lenguaje común, y asegura el cumplimiento normativo, con prácticas robustas de gobernanza, auditoría y protección de datos.

¿Qué componentes esenciales conforman una estrategia efectiva de MLOps?

Implementar una estrategia efectiva de MLOps no responde a una única fórmula: los componentes clave pueden variar según el enfoque adoptado, el nivel de madurez tecnológica y los recursos ya disponibles en la organización.

Algunas empresas priorizan herramientas y componentes técnicos específicos; otras, en cambio, parten desde una visión estratégica orientada a la colaboración entre equipos o a la automatización progresiva.

En todos los casos, el objetivo es el mismo: asegurar un ciclo de vida de machine learning robusto, escalable y alineado con las operaciones del negocio.

En este marco, en un artículo publicado en McKinsey & Company y realizado por los ejecutivos y Senior Partner Eric Lamarre, Kate Smaje y Rodney Zemmel, remarcan cuatro prácticas clave de MLOps que, si se aplican correctamente, pueden elevar drásticamente la efectividad y escalabilidad de los modelos de IA en entornos empresariales, potenciando casos como la aplicación de la IA en la industria 5.0.

- Garantizar la disponibilidad y calidad de los datos: Una estrategia eficaz debe incluir controles automatizados para evaluar calidad, detectar anomalías y extraer características relevantes desde datos crudos. Herramientas como los feature stores centralizan estas variables, asegurando que el “combustible” de los modelos esté siempre disponible y estandarizado.

- Proveer herramientas para optimizar el desarrollo de ML: La reproducibilidad y modularidad del código son esenciales. Frameworks como Kedro o plataformas open source como MLflow que recientemente incorporó funcionalidades avanzadas de tracing para la observabilidad de modelos. Estas ayudan a los científicos de datos a realizar experimentos organizados, rastrear configuraciones y documentar resultados, permitiendo mejorar continuamente los modelos sin perder trazabilidad ni gobernanza.

- Automatizar la entrega de modelos en producción: Para escalar soluciones de IA es fundamental contar con una plataforma de entrega continua de ML, que automatice desde la preparación de datos hasta el despliegue en producción. Esto incluye pipelines de entrenamiento, validación y monitoreo, además de integraciones con otras aplicaciones para asegurar la trazabilidad y la medición de desempeño en tiempo real.

- Monitorear el rendimiento del modelo de forma constante: A diferencia del software tradicional, los modelos de ML se degradan con el tiempo debido a cambios en los datos. Por eso es clave implementar monitoreo activo, que detecte drift, valide calidad de datos y evalúe el impacto del modelo sobre los KPIs del negocio.

De acuerdo con David Adyemi, científico de datos, “entre el 60% y el 80% de los modelos que se entrenan y desarrollan nunca llegan a la fase de producción”. Razón por la que se hacen más necesarias las prácticas antes descritas.

Una visión coincidente con el informe de adopción de IA empresarial del Foro Económico Mundial, que revela que solo el 21% de las compañías tiene modelos en producción, refuerza la necesidad de las prácticas antes descritas.

¿Cuáles son los desafíos más comunes en la adopción de MLOps y cómo superarlos?

Existen numerosos desafíos que surgen al implementar MLOps en entornos de múltiples organizaciones.

Existen dificultades técnicas, legales y organizacionales que enfrentan las empresas al escalar modelos de machine learning más allá de sus propios límites operativos.

Algunos de ellos son:

- Integración de datos compleja: Compartir y estandarizar datos entre distintas empresas implica grandes retos, sobre todo cuando se trata de datos sensibles como los de salud. Un estudio académico de la Universidad de Stuttgart sobre desafíos de pipelines MLOps subraya que las diferencias en formatos, estructuras de datos y las limitaciones legales dificultan el entrenamiento de modelos colaborativos.

- Interoperabilidad limitada de modelos: Un modelo entrenado en una organización no siempre puede ser reutilizado por otra. Las diferencias en infraestructuras, usuarios y objetivos reducen la portabilidad de los algoritmos y su valor compartido.

- Falta de gobernanza y monitoreo conjunto: Cuando cada organización opera de forma independiente, se vuelve complicado monitorear el desempeño de los modelos de manera continua y coordinada. Esto limita la capacidad de corregir errores o detectar desviaciones a tiempo.

- Restricciones normativas y barreras culturales: Las diferencias en políticas internas, niveles de madurez digital y culturas organizacionales generan fricciones que obstaculizan el desarrollo de flujos de trabajo automatizados y sostenibles.

A pesar de que estos desafíos siguen vigentes, la evolución del ecosistema MLOps ha diversificado las dificultades dependiendo del tipo y tamaño de la empresa. Los pequeños negocios y startups, por ejemplo, se enfrentan especialmente:

- Dificultad para atraer talento calificado en MLOps, debido a la alta competencia con grandes empresas y la falta de programas de mentoría internos.

- Limitaciones de recursos tecnológicos y financieros, que dificultan la implementación de infraestructuras robustas o herramientas de automatización.

- Problemas de escalabilidad, al depender inicialmente de procesos manuales poco sostenibles a largo plazo.

- Desafíos para integrar MLOps con sistemas heredados, ya que muchas startups no están diseñadas desde el inicio para el uso intensivo de inteligencia artificial.

¿Qué herramientas y plataformas son clave para desarrollar MLOps?

El ecosistema de MLOps incluye una variedad de herramientas y plataformas, tanto open-source como comerciales:

| Herramienta | Descripción | Funciones Clave |

| MLflow | Plataforma de código abierto para gestionar el ciclo de vida completo del ML. | Seguimiento de experimentos, proyectos reutilizables, empaquetado de modelos, registro centralizado de modelos. |

| Kubeflow | Plataforma MLOps de código abierto diseñada para Kubernetes, orientada a la escalabilidad y portabilidad. | Pipelines, Katib (tuning de hiperparámetros), KFServe (servicio de modelos), Fairing (implementación desde entorno local). |

| TensorFlow Extended (TFX) | Plataforma desarrollada por Google para flujos de trabajo de ML en producción, integrada con TensorFlow. | Validación de datos (TFDV), análisis de modelos (TFMA), servicio de modelos (TensorFlow Serving). |

| Amazon SageMaker | Plataforma integral de AWS para todo el flujo de trabajo de ML en la nube. | SageMaker Studio, Ground Truth (etiquetado), Autopilot (AutoML), Model Monitor (monitoreo en producción). |

| Azure Machine Learning | Plataforma de ML en la nube de Microsoft con soporte para código bajo y alto. | Azure ML Studio, AutoML, MLOps incorporado, diseñador de flujos drag-and-drop. |

| MLRun | Marco de MLOps de código abierto desarrollado por Iguazio, enfocado en automatización y escalabilidad. | Gestión de proyectos, automatización de procesos, integración con Kubernetes, modelo como microservicio. |

| DVC (Data Version Control) | Sistema de control de versiones para proyectos de ML, enfocado en el manejo reproducible de datos y modelos. | Versionado de datos y modelos, pipelines reproducibles, integración con Git. |

En definitiva, si bien el ecosistema de herramientas y plataformas para desarrollar MLOps es amplio y cada vez más sofisticado, factores como el tipo de datos, la infraestructura disponible, el grado de automatización requerido y el nivel de madurez del equipo deben guiar la selección.

Adaptar la tecnología al contexto del proyecto —y no al revés— es clave para garantizar un flujo de trabajo robusto, escalable y alineado con los objetivos de la empresa.

¿Qué empresas han transformado sus operaciones gracias a MLOps?

Varias empresas líderes están adoptando MLOps para mejorar sus operaciones de IA, siguiendo ejemplos de IA generativa aplicada con RAG y agentes AI y explorando futuros como la AGI en los negocios.. Un caso destacado es el de Netflix, que gestiona miles de modelos de machine learning encargados de personalizar las recomendaciones de contenido, optimizar la codificación de video y mejorar la experiencia del usuario. Netflix redujo 40% el tiempo de procesamiento de recomendaciones usando pipelines automatizados con Kubeflow y monitoreo en tiempo real.

Spotify también ha adoptado MLOps, este enfoque le permite a la empresa gestionar el ciclo de vida completo de modelos que alimentan sus sistemas de recomendación musical y de podcasts. Dado que estos modelos deben adaptarse rápidamente a los patrones de comportamiento de millones de usuarios, MLOps permite reentrenarlos con agilidad utilizando nuevos datos de interacción, manteniendo así la relevancia de las recomendaciones.

En el caso de Uber, la empresa ha desarrollado Michelangelo, una plataforma interna de machine learning diseñada con los principios de MLOps. Esta herramienta permite a sus equipos crear, entrenar, validar y desplegar modelos a gran escala para aplicaciones que van desde la estimación precisa de tiempos de llegada hasta la detección de fraude.

De acuerdo con Nav Kankani, Rush Tehrani, Anant Vyas de Uber “Maximizar la eficiencia de la infraestructura requiere un enfoque colaborativo de diseño de hardware y software en todas las capas del sistema”.

¿Cuáles son las tendencias futuras en el desarrollo de MLOps?

De acuerdo con el AI Senior Consultant e Ingeniero Informático, Millán Santamaría Sacristán, en su trabajo titulado Machine Learning Operations (MLOps): contexto actual y tendencias futuras, cuyo objetivo fue analizar el panorama actual de esta metodología y proyectar su evolución, es posible identificar una serie de tendencias clave que están definiendo el rumbo del MLOps en los próximos años.

Estas tendencias no solo responden a desafíos técnicos, sino también organizacionales y culturales en la implementación de sistemas de inteligencia artificial a escala. Entre las más relevantes se encuentran:

- Automatización de todo el ciclo de vida del modelo: Incluyendo integración continua (CI), entrega continua (CD), entrenamiento continuo (CT) y monitoreo continuo.

- Mayor enfoque en la reproducibilidad: Implementación de sistemas que permitan replicar modelos, datos y experimentos de manera precisa y auditable.

- Control avanzado de versiones: Versionado no solo del código, sino también de los datos, modelos y configuraciones para garantizar trazabilidad.

- Aumento del uso de infraestructura modular y reutilizable: Canalizaciones (pipelines) compuestas por bloques independientes y reutilizables para mejorar la escalabilidad.

- Adopción de plataformas cloud híbridas y multi-cloud: Para adaptarse a entornos empresariales complejos y garantizar flexibilidad operativa.

- Expansión del entrenamiento continuo: Reentrenamiento automático de modelos ante variaciones en los datos (data drift o concept drift).

- Integración de herramientas específicas para el testeo de modelos: Enfocadas en métricas de negocio, sesgos, equidad y robustez del modelo.

- Mejora en el monitoreo en producción: En tiempo real, con alertas inteligentes y mecanismos automatizados de respuesta ante desviaciones.

- Énfasis en la gestión de la deuda técnica y cultural en sistemas ML: Desarrollo de prácticas que reduzcan la complejidad, promuevan buenas abstracciones y fomenten una cultura colaborativa entre investigación e ingeniería.

- Uso de Feature Stores como estándar: Para centralizar, versionar y reutilizar variables de entrada en distintos modelos y proyectos.

- Consolidación del rol del ingeniero de MLOps: Profesional especializado que combina conocimientos de IA, software, datos y operaciones.

Preguntas frecuentes sobre MLOps

¿Qué diferencia hay entre MLOps y DevOps?

MLOps se centra en gestionar el ciclo de vida de modelos de machine learning, incluyendo datos, entrenamiento, despliegue y monitoreo, mientras que DevOps se enfoca en el desarrollo y operación de software tradicional, gestionando principalmente código y aplicaciones estáticas.

¿Cómo puede MLOps mejorar la eficiencia en el desarrollo de modelos de ML?

Automatiza tareas repetitivas, reduce el tiempo de despliegue, mejora la trazabilidad y facilita la colaboración entre equipos, permitiendo iteraciones más rápidas y modelos más robustos.

¿Cuáles son las habilidades clave que debe tener un ingeniero de MLOps?

Un ingeniero de MLOps debe dominar machine learning, ingeniería de datos, principios DevOps, automatización de pipelines, control de versiones, monitoreo de modelos y manejo de infraestructuras como Kubernetes y herramientas como MLflow o Airflow.

¿Qué consideraciones de seguridad se deben tener en cuenta al implementar MLOps?

Es fundamental proteger los datos, controlar el acceso a los pipelines, asegurar la integridad del código y los modelos, monitorear posibles vulnerabilidades y cumplir con normativas de privacidad y protección de datos en todas las etapas del ciclo de vida de los modelos.

¿Cómo se integra MLOps con las infraestructuras de TI existentes en una empresa?

MLOps se integra mediante el uso de APIs, contenedores, orquestadores como Kubernetes y herramientas de automatización, permitiendo desplegar y gestionar modelos sobre infraestructuras locales, cloud o híbridas, y facilitando la colaboración entre equipos de ciencia de datos y TI