La integración de la Inteligencia Artificial (IA) en el entorno empresarial es una realidad presente. En Colombia, esta adopción se está acelerando, aplicaciones de IA como la salud, la educación y la agricultura, y planteando una serie de oportunidades y desafíos. De acuerdo con un estudio de SAP, el 69 % de las empresas colombianas anticipa un impacto significativo de la Inteligencia Artificial (IA) en sus industrias, superando el promedio latinoamericano y ubicándose como el segundo país de la región con mayor expectativa en este ámbito. Además, el 54 % de las organizaciones en Colombia planea aumentar su inversión en soluciones de IA durante 2025, poniendo foco en precisión factual y gobernanza de los datos.

Si bien la IA generativa está irrumpiendo con mucha fuerza por su gran promesa , las formas predictiva y analítica, como el machine learning, están mucho más consolidadas y son herramientas que se usan desde hace muchísimos años. A pesar del aparente boom, Juan Carlos Villate, gerente general de IDC Colombia, comparte que enfatiza que en Colombia no ha habido una adopción temprana y muy fuerte de la IA desde el comienzo mismo.

Más allá de las inversiones o de la velocidad en la implementación de estas tecnologías, el contexto debe ir de la mano con un marco ético sólido y una comprensión clara del panorama regulatorio, que en el país se encuentra en un proceso de evolución constante.

En el contexto colombiano, la regulación de la IA está tomando forma a través de diversas iniciativas legislativas que buscan establecer un marco ético y responsable. Aunque en algunos casos esto ha generado una fragmentación legislativa, la cual es uno de los retos más urgentes, según compartió Samuel Yohai, presidente de la Cámara Colombiana de Informática y Telecomunicaciones (CCIT).

El ‘Proyecto de Ley por medio del cual se regula la Inteligencia Artificial en Colombia para garantizar su desarrollo ético y responsable y se dictan otras disposiciones’ impulsado por el Ministerio de Ciencia, Tecnología e Innovación (MinCiencias) y el Ministerio de las TIC, se presenta como una respuesta integral y proactiva para posicionar al país como un líder regional en la adopción responsable de esta tecnología. Esta propuesta legislativa, que se radicó en julio de 2025, se inspira directamente en principios y directrices de organismos internacionales de prestigio como la OCDE, la Unesco y, de manera muy particular, la Ley de IA de la Unión Europea (EU AI Act).

El debate sobre la regulación en Colombia es dinámico, con múltiples proyectos de ley en curso y otros archivados, lo que evidencia el interés del Congreso en la materia. Un ejemplo destacado es el Proyecto de Ley 043 de 2025, que propone una clasificación de riesgos para los sistemas de IA y designa a MinCiencias como la autoridad nacional competente para supervisar y regular su uso. El análisis de la evolución normativa en Colombia indica que la legislación sobre IA está orientada a armonizar con los estándares globales. Este enfoque no es solo una reacción a los riesgos tecnológicos, sino una estrategia para garantizar la competitividad internacional.

Índice de temas

¿Qué principios éticos deben guiar el desarrollo y uso de la Inteligencia Artificial en empresas?

La adopción de la IA en cualquier organización debe sustentarse en un conjunto de principios éticos que sirvan como brújula para la toma de decisiones. Estos principios no son meras declaraciones filosóficas; son pilares estratégicos que mitigan riesgos, construyen confianza con los clientes y aseguran la sostenibilidad de los proyectos a largo plazo.

Desde una perspectiva crítica, organizaciones como la Fundación Karisma han planteado posturas importantes sobre el proceso de regulación. Aunque apoyan la necesidad de un marco legal, advierten que la regulación no debe ser un freno, sino un facilitador para la innovación y el desarrollo. Su argumento central es que el desafío principal de Colombia no es solo la regulación, sino la gran brecha digital y la falta de infraestructura de internet, especialmente en las regiones.

El Departamento Nacional de planeación (DNP) ha señalado, por ejemplo, que hasta el 79 % de los niños entre 5 y 12 años no tienen acceso a Internet, lo que subraya el riesgo de que la IA amplíe aún más las desigualdades sociales si no se acompaña de una inversión pública robusta en ciencia, tecnología e innovación. Esta visión resalta una tensión fundamental: la ambición de un marco regulatorio integral se enfrenta a las realidades estructurales del país. La regulación, por sí sola, no puede garantizar una IA equitativa si no se abordan simultáneamente las limitaciones de acceso y educación. Para las empresas, esto significa que la responsabilidad va más allá del simple cumplimiento legal, exigiendo una consideración del impacto social más amplio de sus proyectos y la búsqueda activa de soluciones que contribuyan a cerrar estas brechas.

Las directrices de organismos internacionales como la Unesco y la OCDE, que a su vez han influenciado el proyecto de ley colombiano , destacan la importancia de varios de estos principios.

- Transparencia: Este principio implica la capacidad de comprender la existencia, el funcionamiento y el propósito de un sistema de IA. Para una empresa, la transparencia se manifiesta en la obligación de informar a los usuarios cuando interactúan con un sistema automatizado, como un chatbot o un asistente virtual. La Unesco señala que la transparencia es esencial para la ética de la IA, pero el nivel de revelación debe ser adecuado al contexto, ya que puede existir una tensión con otros principios como la privacidad o la seguridad. La transparencia es, en esencia, el primer paso para construir una relación de confianza con los usuarios.

- Justicia y no discriminación: Un sistema de IA ético debe evitar la perpetuación o amplificación de sesgos sociales, de género, raciales o de cualquier otra índole. Esto implica diseñar algoritmos que no generen resultados discriminatorios o resultados inexactos. y que promuevan la equidad en el acceso a los beneficios de la tecnología. El proyecto de ley colombiano hace un llamado específico a la no discriminación, garantizando que el desarrollo de la IA no amplíe las brechas digitales y sociales existentes. Para las empresas, el incumplimiento de este principio puede tener consecuencias graves, como la pérdida de talento, demandas legales y un daño reputacional irreversible.

- Privacidad: La protección de los datos personales es un derecho fundamental que debe ser resguardado a lo largo de todo el ciclo de vida de la IA, desde la recolección de los datos hasta el desmantelamiento del sistema. En Colombia, este principio ya está respaldado por la Ley 1581 de 2012, que exige el consentimiento explícito del titular para el tratamiento de sus datos. Un sistema de IA ético debe ser diseñado bajo este principio, utilizando técnicas de anonimización y minimización de datos para salvaguardar la intimidad de los individuos.

- Responsabilidad: Este principio establece la necesidad de atribuir las acciones y decisiones de un sistema de IA a una persona o entidad jurídica específica. Esto implica establecer mecanismos claros de rendición de cuentas, auditoría y supervisión a lo largo del ciclo de vida del sistema. Para las empresas, la responsabilidad se traduce en tener roles bien definidos y en la capacidad de rastrear las decisiones de un algoritmo para entender por qué se tomaron y quién es el responsable final de su impacto.

La aplicación de estos principios éticos no es solo un deber moral, sino una estrategia de negocio inteligente. Una empresa que prioriza la transparencia y la justicia en sus sistemas de IA tiene una mayor probabilidad de ganar la confianza del público y de sus propios empleados.

El cumplimiento de la normativa de privacidad protege a la empresa de costosas sanciones y daños reputacionales. En última instancia, la ética de la IA se convierte en una ventaja competitiva directa, al diferenciar a la empresa como un actor responsable y digno de confianza en el mercado.

| Principio ético | ¿Qué significa? | Impacto en la empresa | Riesgo de incumplimiento |

| Transparencia | Informar a los usuarios cuándo interactúan con un sistema de IA. | Construye confianza, aumenta la lealtad del cliente y reduce malentendidos. | Pérdida de confianza, daño reputacional, sanciones regulatorias (si aplica). |

| Justicia y no discriminación | Asegurar que la IA no genere sesgos y que los beneficios sean accesibles para todos. | Acceso a un grupo más amplio de talento, innovación con soluciones diversas, mejora de la reputación de marca. | Discriminación involuntaria, demandas legales, pérdida de talento. |

| Privacidad | Proteger los datos personales a lo largo de todo el ciclo de vida del sistema de IA. | Cumplimiento normativo (Ley 1581 de 2012), fidelidad del cliente y reducción del riesgo de fugas de datos. | Sanciones financieras (SIC), pérdida de datos sensibles, daño reputacional. |

| Responsabilidad | Atribuir las decisiones de la IA a una persona o entidad jurídica, con mecanismos de auditoría. | Mejora la gobernanza, permite la corrección de errores y fortalece la supervisión interna. | Ausencia de rendición de cuentas, resultados incontrolables, decisiones opacas. |

¿Cómo pueden los directivos identificar y gestionar los riesgos éticos en proyectos de IA?

La gestión de los riesgos éticos en proyectos de IA requiere un enfoque proactivo y metódico que vaya más allá de una simple revisión superficial. La clave no reside en evitar la tecnología, sino en adoptarla de manera segura y responsable. Esto se logra mediante la implementación de marcos de gestión de riesgos formales que permitan a las organizaciones identificar, evaluar y mitigar los posibles impactos negativos de la IA en la sociedad y en la empresa misma.

Un enfoque efectivo de gestión de riesgos debe ser un proceso continuo, integrado en todo el ciclo de vida de la IA, desde su concepción hasta su desmantelamiento. Un modelo de gestión se puede estructurar en cuatro categorías principales de riesgos para proporcionar una visión holística:

- Riesgos de datos: Estos son la causa raíz de la mayoría de los problemas éticos. Los modelos de IA son tan fiables como los datos con los que se entrenan. Si los datos son sesgados, incompletos o de baja calidad, el modelo de IA heredará y amplificará esos sesgos, lo que puede llevar a resultados discriminatorios o inexactos. La falta de integridad en los datos de entrenamiento puede generar falsos positivos y una toma de decisiones errónea.

- Riesgos del modelo: Estos se refieren a las fallas inherentes al algoritmo o al sistema. La falta de transparencia o “caja negra” de un modelo de IA puede dificultar la comprensión de cómo se llega a una decisión, lo que impide la identificación y corrección de sesgos. Los riesgos operacionales incluyen las vulnerabilidades de seguridad y los fallos del sistema, los cuales pueden tener consecuencias graves si no se gestionan adecuadamente.

- Riesgos éticos y legales: Estos se manifiestan en la pérdida de confianza del público debido a una falta de transparencia, la discriminación algorítmica y la incapacidad de la organización para manejar dilemas éticos relacionados con la privacidad y los derechos humanos. El incumplimiento de las regulaciones nacionales e internacionales puede resultar en multas significativas y daños a la reputación.

- Riesgos operacionales: En esta categoría se incluyen las fallas de seguridad y la falta de supervisión humana o despliegue en entornos no probados. Es fundamental que los sistemas de IA sean robustos y resistentes a ataques o manipulaciones.

La gestión de riesgos éticos de la IA debe ser un proceso continuo y holístico, no un evento único. Las empresas deben adoptar un marco formal que incluya la creación de una cultura de gobernanza, el mapeo de los riesgos en contextos empresariales específicos, la medición y evaluación de esos riesgos, y la gestión proactiva de los mismos.

La importancia de la documentación detallada y el monitoreo continuo es crucial, ya que el comportamiento de un sistema de IA puede cambiar con el tiempo y con nuevos datos, lo que exige una vigilancia constante para mantener la ética. Este enfoque mitiga los riesgos antes de que se materialicen y convierte la ética en un proceso operativo, no en una simple reacción.

Para facilitar este proceso, los directivos pueden utilizar una lista de verificación (checklist) de evaluación ética, que traduzca los conceptos abstractos de la ética de la IA en preguntas concretas y operativas:

| Checklist de evaluación ética para proyectos de IA | Sí / No / N/A | Observaciones y plan de acción |

| Datos | ||

| ¿Los datos de entrenamiento son diversos y representativos de la población relevante? | ||

| ¿Se han revisado los conjuntos de datos en busca de sesgos de género, raza o socioeconómicos? | ||

| ¿Hemos obtenido el consentimiento explícito y adecuado de los titulares de los datos? | ||

| ¿Se ha aplicado la anonimización o minimización de los datos personales en la medida de lo posible? | ||

| Algoritmo y Modelo | ||

| ¿Podemos explicar cómo el sistema toma sus decisiones de manera comprensible para un no-experto? | ||

| ¿Existe un mecanismo de supervisión humana efectiva para las decisiones críticas de la IA? | ||

| ¿Se han realizado pruebas rigurosas para asegurar la precisión, robustez y seguridad del modelo? | ||

| Impacto Social | ||

| ¿Podría este sistema discriminar o afectar negativamente a algún grupo de la sociedad? | ||

| ¿Se han identificado los posibles daños colaterales no intencionados que el sistema podría causar? | ||

| ¿Se han establecido canales de retroalimentación para que los usuarios puedan reportar problemas o quejas? | ||

| Gobernanza y Cumplimiento | ||

| ¿Hay un responsable claro (persona o comité) para este sistema de IA? | ||

| ¿Contamos con una documentación detallada y actualizada del diseño, desarrollo y uso del sistema? | ||

| ¿Hemos verificado que el sistema cumple con las leyes de protección de datos aplicables (ej. Ley 1581)? | ||

| ¿Se ha establecido un proceso de monitoreo continuo para evaluar el desempeño y el impacto ético del sistema después de su despliegue? |

¿Qué ejemplos reales existen de dilemas éticos generados por la IA en el entorno empresarial?

La teoría de la ética de la IA adquiere su relevancia más tangible al examinar casos reales en los que su ausencia ha generado dilemas significativos y consecuencias adversas.

La adopción de la IA en el entorno empresarial ha generado una serie de dilemas éticos significativos, principalmente en torno a la equidad, los sesgos algorítmicos y las implicaciones sociales del uso de esta tecnología. Un aspecto crítico es cómo los algoritmos de IA pueden perpetuar y amplificar sesgos y estereotipos de género, con repercusiones negativas, especialmente para las mujeres. La Universidad Externado de Colombia, a través de su publicación Zero, señala que la IA, a pesar de ser percibida como objetiva, a menudo replica los prejuicios de género existentes en la sociedad y en los datos con los que se entrena.

A estos dilemas éticos se suman las preocupaciones sobre el impacto laboral y la gobernanza de la IA. El director de Inteligencia Artificial de IBM Latinoamérica, Alberto Icochea, advirtió durante un evento de la Universidad de los Andes que “escalar agentes de Inteligencia Artificial no es fácil; hay que integrarlos, gobernarlos y, sobre todo, estar dispuestos a darles cierto nivel de autonomía. Y eso implica asumir riesgos —como persona y como organización— que no todos están preparados para gestionar”. Aunque la IA no necesariamente elimina empleos, automatiza tareas específicas y repetitivas, transformando la naturaleza del trabajo y requiriendo nuevas habilidades. Por ello, se enfatiza que quienes deben entender mejor la IA no son los expertos en tecnología, sino los líderes de áreas estratégicas como finanzas, recursos humanos y operaciones, ya que son ellos quienes pueden identificar oportunidades reales y anticipar las implicaciones éticas y operativas.

Para una implementación efectiva, Haydenmar Maria Núñez Castro, profesora de la Universidad de los Andes, destaca la necesidad de contar con datos de calidad, talento humano capacitado para cuestionar los impactos éticos de la IA, y una cultura organizacional receptiva.

En este contexto, la Universidad del Norte destaca que la IA está generando cambios reales al hacer los procesos más rápidos, baratos y mejores, lo que es fundamental para la competitividad de cualquier empresa. Sin embargo, el principal desafío técnico y ético sigue siendo el manejo de los datos: “Proteger los datos, saber consumirlos y curarlos es el desafío más grande que enfrentan las empresas, y muchas en Latinoamérica aún no están preparadas“. A nivel regulatorio, la región va por detrás de Europa y Asia, sin marcos específicos para la IA, lo que agrava estos desafíos

Estos ejemplos demuestran que las fallas éticas no son abstracciones, sino riesgos concretos con impactos financieros, legales y reputacionales.

- Recursos Humanos: El uso de la IA para la contratación y la gestión de personal ha expuesto graves problemas de sesgo. En 2018, un informe reveló que el sistema de contratación de Amazon, entrenado con datos históricos de currículums enviados a la empresa, penalizaba a los currículums que incluían la palabra “mujer” o que provenían de universidades exclusivas para mujeres. Este algoritmo reforzó los sesgos de género existentes, discriminando a candidatas sin intención. Este caso ilustra un claro dilema de justicia y no discriminación, demostrando cómo la IA puede aprender y perpetuar desigualdades arraigadas en los datos, impactando negativamente la búsqueda de talento y la reputación de la empresa. Estos sesgos se atribuyen, en parte, a la falta de mujeres en la creación de algoritmos, ya que a nivel mundial solo el 22 % de los profesionales en IA son mujeres, y la mayoría de los puestos técnicos y de liderazgo son ocupados por hombres. Adicionalmente, la IA perpetúa estereotipos de género a través de asistentes de voz con voces femeninas como Siri o Alexa, reforzando el rol de sumisión y asistencia, y su sexualización a través de tecnologías como los “sex robots”

- Crédito y finanzas: Uno de los casos más notorios de sesgo algorítmico en el sector financiero involucró a la Apple Card. A pesar de que los cónyuges tenían perfiles financieros y crediticios similares, el algoritmo ofrecía límites de crédito significativamente diferentes entre hombres y mujeres, lo que evidenció un sesgo de género implícito. Este dilema ético generó una investigación regulatoria, subrayando que la falta de explicabilidad y justicia puede tener repercusiones legales serias. Otro ejemplo es el caso de Credit Karma, que fue sancionada por la FTC en Estados Unidos por haber engañado a cientos de miles de usuarios al indicarles que estaban “preaprobados” para créditos que en realidad les serían negados, lo cual se basaba en datos mal clasificados. Este caso pone de relieve el dilema de la transparencia y la protección del consumidor, ya que las decisiones opacas basadas en IA causaron un perjuicio financiero real a los usuarios.

- Marketing: El escándalo de Cambridge Analytica es un ejemplo emblemático de cómo el uso de la IA puede violar el principio de privacidad a gran escala. La empresa utilizó datos de perfiles psicológicos de millones de usuarios de Facebook sin su consentimiento explícito para influir en procesos electorales, demostrando los límites éticos del marketing predictivo y la recopilación de datos. Otro dilema ético en el marketing se relaciona con la segmentación de audiencias. El uso de algoritmos para dirigir anuncios basados en la raza, la religión o el género, incluso si es con fines comerciales, plantea serias preguntas sobre la discriminación y la equidad en el acceso a la información y oportunidades.

- Seguridad: El uso de la IA para la vigilancia predictiva o el reconocimiento facial en espacios públicos ha generado un dilema entre la seguridad ciudadana y la protección de la privacidad. Las preocupaciones sobre el uso indebido de datos personales y la dependencia de sesgos discriminatorios en la vigilancia policial son desafíos éticos que la tecnología plantea. En este contexto, el proyecto de ley colombiano, que busca modificar el Código Penal para agravar el delito de falsedad personal a través de IA, es una respuesta directa a una de las amenazas más recientes y preocupantes de la IA: la creación de deepfakes para suplantar identidades con fines ilícitos. Esto demuestra que los dilemas éticos no son problemas abstractos, sino que ya están impulsando la creación de nuevas leyes para proteger a los ciudadanos de los riesgos reales de la IA.

La ética no es un debate filosófico, sino una cuestión de riesgo financiero, legal y reputacional. Un pequeño sesgo en los datos puede convertirse en un gran dilema ético que se traduce en multas millonarias y la pérdida de la confianza del cliente. Las empresas que ignoran estos dilemas operan en un campo minado de consecuencias negativas.

¿Qué obligaciones legales y regulatorias deben cumplir las empresas en materia de ética de IA?

El panorama regulatorio en Colombia está en un estado de transición, moviéndose de un marco legal general a uno específicamente diseñado para la IA. Comprender este ecosistema es crucial para cualquier empresa que busque operar de manera responsable y evitar riesgos legales.

Leyes nacionales colombianas

- Leyes de Protección de Datos (Ley 1581 de 2012 y Ley 1266 de 2008): Estas son el pilar fundamental. Cualquier sistema de IA que procese datos personales debe cumplir con los principios de hábeas data, lo que incluye la recolección, el tratamiento y la circulación de datos con el consentimiento informado del titular. La Superintendencia de Industria y Comercio (SIC) es la entidad encargada de ejercer la vigilancia y el control en esta materia, pudiendo imponer sanciones y ordenar medidas correctivas.

- Iniciativas legislativas en curso: Como se mencionó, el proyecto de ley para regular la IA en Colombia, que se encuentra en trámite, propone un enfoque basado en riesgos, similar a la Ley de IA de la Unión Europea. Este proyecto busca designar al Ministerio de Ciencia, Tecnología e Innovación como la autoridad nacional competente y establecer obligaciones diferenciadas para los sistemas de IA, según su nivel de riesgo. Además, se están discutiendo iniciativas para modificar el Código Penal y establecer agravantes para delitos cometidos con IA, como la suplantación de identidad mediante deepfakes.

Estándares voluntarios y tendencias internacionales

- EU AI Act (Ley de IA de la Unión Europea): Este es el referente regulatorio más influyente a nivel mundial y la base de la propuesta colombiana. La EU AI Act clasifica los sistemas de IA en cuatro categorías de riesgo: prohibidos, de alto riesgo, de riesgo limitado y de bajo riesgo. Los sistemas de alto riesgo (ej. en educación, empleo o servicios esenciales) están sujetos a requisitos rigurosos de transparencia, supervisión humana y documentación.

- Principios de la OCDE y la Unesco: Colombia ha adoptado las recomendaciones éticas de la Unesco y los principios de la OCDE. Estos son considerados “soft law” o guías voluntarias que promueven el desarrollo de la IA centrado en el ser humano, la justicia social, la no discriminación y la sostenibilidad. Aunque no son legalmente vinculantes, su cumplimiento es fundamental para alinearse con las mejores prácticas globales y participar en la Alianza Mundial sobre la IA, de la cual Colombia es miembro.

El panorama regulatorio en Colombia se está moviendo de un marco legal general (protección de datos) a uno específico para la IA. La legislación se está construyendo sobre referentes internacionales, lo que sugiere que las empresas que ya se adhieren a estándares como los de la EU AI Act o la OCDE tendrán una ventaja al momento de la implementación de la ley local.

| Norma/Regulación | Tipo | Descripción Clave | Impacto en la IA |

| Ley 1581 de 2012 | Nacional, Vigente | Establece disposiciones generales para la protección de datos personales y el hábeas data. | Obliga al consentimiento explícito para usar datos de entrenamiento. La SIC puede imponer sanciones por incumplimiento. |

| Proyecto de Ley de IA (ej. PL 043/2025) | Nacional, En discusión | Propone un marco regulatorio basado en riesgos y designa a MinCiencias como autoridad nacional. | Crearía obligaciones diferenciadas según el riesgo del sistema (alto riesgo, limitado, etc.), con supervisión y auditoría obligatoria. |

| Ley de IA de la UE (EU AI Act) | Internacional, Referente | Clasifica los sistemas de IA según su nivel de riesgo y establece requisitos estrictos para los de alto riesgo. | Sirve como modelo para la regulación colombiana. Las empresas con operaciones internacionales ya deben cumplir con estos estándares. |

| Principios de la OCDE y la Unesco | Internacional, Voluntario | Guías de “soft law” que promueven la IA ética, centrada en el ser humano y sostenible. | Establece los pilares de la IA responsable. Su adopción es un indicador de buenas prácticas y liderazgo empresarial. |

¿Cómo implementar políticas efectivas de gobernanza ética para la Inteligencia Artificial?

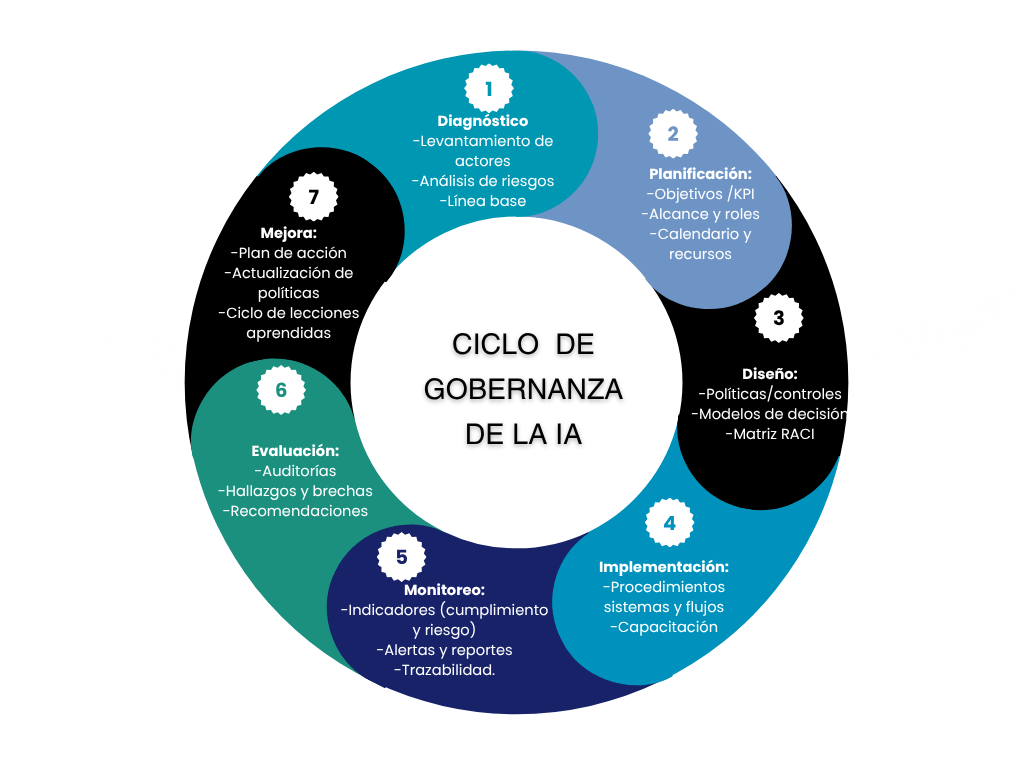

La gobernanza de la IA no es un obstáculo burocrático, sino la estructura que permite a la empresa innovar de forma segura y responsable. La implementación de políticas efectivas de gobernanza ética requiere un enfoque estructurado y la participación de múltiples áreas de la organización. El objetivo es integrar la ética en cada etapa del ciclo de vida del desarrollo de la IA, en lo que se conoce como “ética por diseño”.

Pasos para una gobernanza efectiva

- Creación de un comité de ética de IA: Este es el primer paso. El comité debe ser una instancia multisectorial que incluya a representantes del área legal, tecnología, recursos humanos, marketing y la alta dirección. Su propósito es definir los principios éticos de la empresa, evaluar los riesgos de los nuevos proyectos de IA y asegurar que las políticas se cumplan. El comité debe reunirse con una cadencia preestablecida para revisar y aprobar las iniciativas.

- Definición de políticas claras y una carta ética: Las empresas deben establecer una “Carta Ética de IA” que alinee los principios de la tecnología con los valores fundamentales de la organización. Esta carta debe ser un documento vivo y accesible para todos los empleados, que establezca las reglas del juego para el desarrollo y uso de la IA en la empresa.

- Implementación de protocolos de auditoría: Para garantizar el cumplimiento, es vital establecer procesos de auditoría continuos. Estas auditorías, realizadas tanto internamente como por terceros independientes, deben tener como objetivo identificar sesgos en los datos y algoritmos, asegurar la transparencia de los sistemas y documentar todas las decisiones de diseño y desarrollo. La auditoría no es un evento único, sino un proceso de vigilancia constante que ayuda a mitigar los riesgos regulatorios y reputacionales.

- Establecimiento de canales de denuncia: Se deben crear mecanismos claros para que empleados, clientes y otros grupos de interés puedan reportar preocupaciones o fallas éticas de los sistemas de IA. Estos canales de retroalimentación fomentan un enfoque proactivo y transparente hacia la gestión de riesgos y permiten abordar los problemas antes de que se conviertan en crisis.

Una estrategia clave contemplada en el proyecto de ley colombiano para fomentar la innovación responsable son los sandboxes regulatorios. Estos son espacios controlados que permiten a las empresas probar y perfeccionar sus tecnologías de IA bajo la supervisión de las autoridades competentes. La existencia de estos sandboxes demuestra que el gobierno busca un equilibrio entre la regulación y la promoción de la innovación. Las empresas pueden aprovechar estos espacios para validar proyectos de alto riesgo, mitigando así el riesgo legal y reputacional antes de su lanzamiento al mercado.

¿Qué papel tiene la transparencia y la explicabilidad para garantizar la ética en IA?

La confianza en la IA depende en gran medida de dos principios que a menudo se usan indistintamente, pero que tienen diferencias sutiles y cruciales: la transparencia y la explicabilidad. Ambos son fundamentales para garantizar que los sistemas de IA sean justos, responsables y fiables.

La transparencia se refiere a la capacidad de una organización de revelar la existencia y el propósito de un sistema de IA. Es el “qué” y el “quién” del sistema. Por ejemplo, una empresa demuestra transparencia al incluir una leyenda en su chatbot que dice: “Soy un asistente virtual de IA, ¿en qué puedo ayudarte?”. Esto informa al usuario que no está interactuando con una persona y establece una expectativa clara desde el principio.

La explicabilidad, por otro lado, se refiere al “porqué”. Es la capacidad de un sistema para proporcionar una razón comprensible y concisa de la decisión que ha tomado. Esto es especialmente relevante en sistemas de “caja negra”, que son algoritmos complejos cuyas decisiones son difíciles de interpretar. Para una decisión de alto riesgo, como la negación de un crédito, una explicación transparente y explicable no necesita revelar todo el código del algoritmo, sino los factores principales que influyeron en la decisión (ej. “Tu solicitud fue rechazada debido a un historial de pagos atrasados en los últimos 6 meses”).

La transparencia y la explicabilidad mitigan los riesgos éticos de la IA de varias maneras:

- Detección de sesgos: Un sistema explicable permite a los desarrolladores y auditores rastrear la lógica detrás de una decisión, lo que facilita la identificación y corrección de sesgos ocultos en el algoritmo o en los datos de entrenamiento. Sin explicabilidad, un sesgo puede pasar desapercibido, perpetuando injusticias sin que nadie lo sepa.

- Aumento de la confianza: Cuando los usuarios pueden entender la lógica de una decisión de IA, es más probable que confíen en el sistema, incluso si no están de acuerdo con el resultado. Esta confianza es crucial en sectores sensibles como la banca, la justicia y la salud, donde las decisiones de la IA tienen un impacto directo en la vida de las personas.

Es importante señalar que el principio de transparencia no es absoluto y debe equilibrarse con la necesidad de proteger la propiedad intelectual de la empresa y la privacidad de los datos de los usuarios. La clave es aplicar un nivel de transparencia adecuado al contexto y al riesgo del sistema. Para una decisión de vida o muerte, la explicabilidad debe ser total; para un filtro de spam, puede ser mínima.

¿Cómo formar y sensibilizar a equipos directivos y técnicos en ética de la Inteligencia Artificial?

La ética de la IA no es una responsabilidad exclusiva de los desarrolladores; es una competencia transversal que debe ser cultivada en toda la organización. La formación y la sensibilización son herramientas clave para asegurar que los valores éticos no se queden en un documento, sino que se integren en el ADN de la cultura corporativa.

Estrategias de capacitación para toda la organización

- Para equipos directivos y líderes: La formación debe enfocarse en las implicaciones estratégicas de la IA. Los talleres y discusiones deben abordar el impacto en el valor de marca, los riesgos legales y reputacionales, y cómo la ética se alinea con los objetivos de negocio. El propósito es que los líderes entiendan que la ética es una ventaja competitiva y un componente esencial de la gestión de riesgos.

- Para equipos técnicos y de desarrollo: La formación continua es fundamental. Los programas deben centrarse en habilidades prácticas, como la identificación y mitigación de sesgos en los datos de entrenamiento y en los algoritmos, el desarrollo de sistemas explicables y la implementación de protocolos de documentación.

- Para toda la empresa: La ética de la IA es una responsabilidad compartida. Se pueden organizar campañas de sensibilización, talleres y manuales internos que expliquen los principios éticos de la empresa de manera sencilla y clara. También se deben crear canales de retroalimentación para que los empleados de todas las áreas puedan reportar problemas éticos o sugerir mejoras.

La capacitación también debe abordar la importancia de la diversidad en los equipos de desarrollo. Los equipos inclusivos no solo impulsan la innovación, sino que también tienen una mayor capacidad para identificar y corregir sesgos que podrían pasar desapercibidos en equipos más homogéneos.

Este checklist sirve como guía práctica para las empresas que buscan fomentar una cultura ética en la IA:

| Acción de formación | Estado | Responsable |

| Principios y Políticas | ||

| ¿Se han establecido y comunicado a toda la organización los principios éticos de la IA? | ||

| ¿Existe una guía o manual práctico sobre ética de la IA para todos los empleados? | ||

| Formación por audiencia | ||

| ¿Se han realizado talleres de sensibilización sobre riesgos estratégicos de la IA para la alta dirección? | ||

| ¿Se han proporcionado programas de formación técnica sobre identificación y mitigación de sesgos a los equipos de desarrollo? | ||

| ¿Se ha capacitado a los equipos de marketing y ventas sobre las implicaciones éticas del uso de la IA? | ||

| Procesos y Cultura | ||

| ¿Se realizan “auditorías de equidad” periódicas a los algoritmos en uso? | ||

| ¿Los equipos de desarrollo de IA son diversos e inclusivos? | ||

| ¿Existen canales de denuncia o de feedback anónimo para reportar problemas éticos con la IA? |

La Inteligencia Artificial representa una fuerza transformadora, una singularidad, con el potencial de mejorar la productividad y el bienestar social en Colombia. Sin embargo, su éxito a largo plazo no se medirá solo por la eficiencia o las ganancias, sino por la capacidad de las empresas para adoptar la tecnología de manera ética y responsable.

Para los líderes empresariales en el sector tecnológico, esto significa que la ética de la IA no es un tema opcional, sino una ventaja estratégica. Al ser proactivos y adoptar los principios de transparencia, justicia, privacidad y responsabilidad desde el diseño, las empresas pueden:

- Mitigar riesgos: Evitar sanciones regulatorias, demandas legales y daños a la reputación que pueden surgir de sesgos algorítmicos o el uso indebido de datos.

- Construir confianza: Ganar la lealtad de clientes y socios al demostrar un compromiso genuino con el desarrollo de una tecnología segura, justa y centrada en el ser humano.

- Promover la innovación: Fomentar un ecosistema de innovación que sea sostenible y que contribuya a cerrar las brechas digitales y sociales en el país, como sugieren las posturas de organizaciones críticas.

El llamado a la acción para la dirección corporativa es claro: es el momento de liderar con el ejemplo. Al integrar la ética en la gobernanza, la formación de equipos y el diseño de cada proyecto de IA, se podrá asegurar que la tecnología sirva a las personas y no al revés.