En los últimos dos años, la adopción de la Inteligencia Artificial (IA) ha experimentado un auge sin precedentes, transformando la forma en que las organizaciones operan y toman decisiones. Sin embargo, esta rápida integración ha traído consigo importantes desafíos en términos de ciberseguridad y cumplimiento normativo. Un reciente informe de Tenable Research revela que más de un tercio de los equipos de seguridad corporativa han encontrado aplicaciones de IA en sus entornos que no han sido aprovisionadas a través de procesos formales.

Hermes Romero, Director de Tenable para Centro y Sudamérica, subraya la importancia de minimizar los riesgos de la IA mientras se aprovechan sus beneficios. “La evolución de la IA se está dando a una velocidad sin precedentes, dejando a las organizaciones expuestas a riesgos de ciberseguridad”, afirma.

Esta situación plantea serias interrogantes sobre la seguridad de los datos y la gestión de riesgos en un mundo cada vez más digitalizado. En la medida en que la importancia de la IA crece e impacta en el corazón de los negocios, con aplicaciones de IA que están transformando los negocios, las organizaciones necesitan abordar de manera proactiva nuevas problemáticas vinculadas con esta innovación, con referentes cercanos como IA en Colombia: innovación y casos de éxito recientes, incluyendo capacidades como detección y corrección de vulnerabilidades, contención de fugas de datos y prevención de su uso no autorizado.

De hecho, durante un período de 75 días entre finales de junio y principios de septiembre, Tenable detectó más de 9 millones de instancias de aplicaciones de IA en más de 1 millón de hosts. El riesgo para la ciberseguridad del uso sin restricciones de la IA se ve agravado por el creciente volumen de vulnerabilidades de IA.

Índice de temas

¿Cuáles son los riesgos estratégicos más relevantes al adoptar inteligencia artificial en una empresa?

La adopción de la Inteligencia Artificial (IA) representa una oportunidad transformadora para la eficiencia operativa, la innovación y el crecimiento. Sin embargo, su integración en el tejido corporativo introduce una nueva capa de riesgos que van más allá de las preocupaciones tecnológicas tradicionales, afectando las áreas estratégicas, operativas, regulatorias y reputacionales de la organización.

Un informe de IBM, ‘IA en acción 2024‘, identificó los cinco mayores retos para la adopción de la IA para el año 2025, señalando que la principal preocupación es la precisión o el sesgo de los datos, citada por el 45 % de los encuestados. Le siguen de cerca la falta de datos propios para personalizar modelos (42 %), la escasez de experiencia en IA generativa (42 %) y las preocupaciones sobre la privacidad y confidencialidad de la información (40 %).

Estos riesgos no deben ser vistos como barreras para la innovación, sino como una extensión natural de la superficie de ataque de la empresa. Un análisis de McKinsey revela que la adopción global de la IA ha aumentado significativamente a un 72 %, y la adopción de la IA generativa se ha duplicado en menos de un año. Sin embargo, el mismo estudio muestra una aparente contradicción: las empresas con alto rendimiento en IA son más propensas a haber experimentado consecuencias negativas de la tecnología, como la inexactitud y los problemas de ciberseguridad.

Esto sugiere que un enfoque ambicioso no exime del riesgo, sino que exige una gestión más sofisticada y proactiva. La clave no es evitar el riesgo, sino reconocerlo como un subproducto del crecimiento y construir marcos de gobernanza que escalen al mismo ritmo que la adopción tecnológica.

La implementación de la IA presenta riesgos multidimensionales que van más allá de lo técnico, afectando áreas clave de una organización. Estos incluyen riesgos regulatorios, debido a la rápida evolución de la tecnología que supera a los marcos legales, creando vacíos normativos y dificultando la demostración de cumplimiento por la “caja negra” de los modelos. También existen riesgos reputacionales, asociados al uso de algoritmos sesgados que pueden dañar la imagen de la empresa y la confianza del público. Desde una perspectiva interna, los riesgos operativos se manifiestan a través de la baja calidad de los datos y el deterioro del rendimiento de los modelos con el tiempo (model drift), lo que puede causar fallos en los procesos de negocio.

Por otro lado, los riesgos de ciberseguridad aumentan la superficie de ataque de la empresa, ya que la adopción de IA, en especial en entornos híbridos y con modelos de código abierto, puede crear vulnerabilidades explotadas por ciberdelincuentes para lanzar ataques más sofisticados.

Riesgos estratégicos de la IA vs. Impacto empresarial

| Tipo de Riesgo | Impacto en la continuidad del negocio | Impacto en el Compliance | Impacto en la confianza del cliente | Ejemplo/Consecuencia |

| Regulatorio | Multas, interrupción de servicios, prohibición de uso de la tecnología. | Incumplimiento de normativas como GDPR o Leyes de Privacidad de Datos. | Daño reputacional por falta de transparencia y rendición de cuentas. | Software de cumplimiento regulatorio que no detecta transacciones problemáticas. |

| Reputacional | Fugas de clientes, rechazo de socios, pérdida de valor de marca. | Exposición a demandas colectivas por discriminación. | Percepción desfavorable, viralización de escándalos en redes sociales. | Algoritmo de seguros que discrimina a grupos socioeconómicos. |

| Operativo | Interrupción de la cadena de suministro, errores en la producción, decisiones comerciales incorrectas. | Fallos en la trazabilidad de los datos, dificultad para auditar los resultados. | Pérdida de credibilidad si los productos o servicios basados en IA son poco fiables. | Modelo de cadena de suministro que falla al no incluir todos los datos de transacción. |

| Ciberseguridad | Robo de modelos, filtraciones de datos sensibles, ataques de denegación de servicio. | Violaciones de las regulaciones de protección de datos, falta de controles de acceso. | Pérdida de credibilidad por filtraciones de datos, ataques de phishing sofisticados. | Ataques adversariales que engañan a los sistemas de seguridad de la red. |

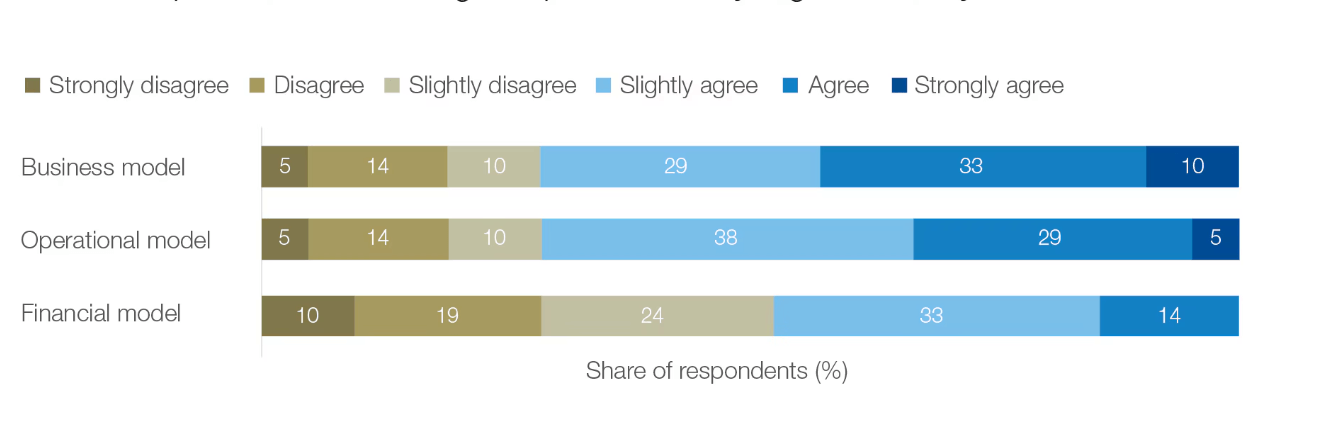

Adicionalmente, el Foro Económico Mundial compartió que la falta de claridad sobre el funcionamiento de la IA también dificulta la anticipación de riesgos futuros, añade el informe, pero los CRO afirman que las áreas de negocio con mayor riesgo a causa de la IA son las operaciones, los modelos de negocio y las estrategias.

Todos los encuestados coincidieron en que el desarrollo de la IA estaba superando su capacidad para gestionar sus posibles riesgos éticos y sociales, y el 43 % afirmó que el desarrollo de nuevas tecnologías de IA debería pausarse o ralentizarse hasta que se comprendiera mejor su impacto potencial.

¿Qué ataques y amenazas específicas puede sufrir un sistema de Inteligencia Artificial empresarial?

En un mundo marcado por ciberataques cada vez más frecuentes y sofisticados, la IA añade una capa adicional de complejidad a un entorno ya intrincado. Si bien el debate se ha centrado en las preocupaciones y desafíos de seguridad que plantea la IA, también ofrece formas innovadoras para defenderse contra actores hostiles , como chatbots AI para mejorar la experiencia del cliente o en escenarios de atención segura mediante LLMs que impulsan negocios en tareas de detección y respuesta. Se estima que el mercado de la IA en ciberseguridad crecerá de aproximadamente 24 mil millones de dólares en 2023 a cerca de 134 mil millones de dólares en 2030, evidenciando la creciente importancia de esta tecnología.

A medida que la IA se convierte en una parte integral de los negocios y acelera la transición hacia la IA y la industria 5.0, las organizaciones deben abordar de manera proactiva las problemáticas emergentes que esta tecnología conlleva. La detección y corrección de vulnerabilidades, la contención de fugas de datos y la prevención del uso no autorizado son capacidades críticas que las empresas deben implementar, especialmente en iniciativas de GenAI para automatización empresarial. No se puede desconocer que el poder de la IA generativa es un arma de doble filo, con casos de uso como GANs en inteligencia artificial generativa, ya que constituye tanto una ventaja como un riesgo evidente en ciberseguridad. No se puede desconocer que el poder de la IA generativa es un arma de doble filo, donde fenómenos como las alucinaciones en IA y sus riesgos para la empresa exigen controles adicionales.

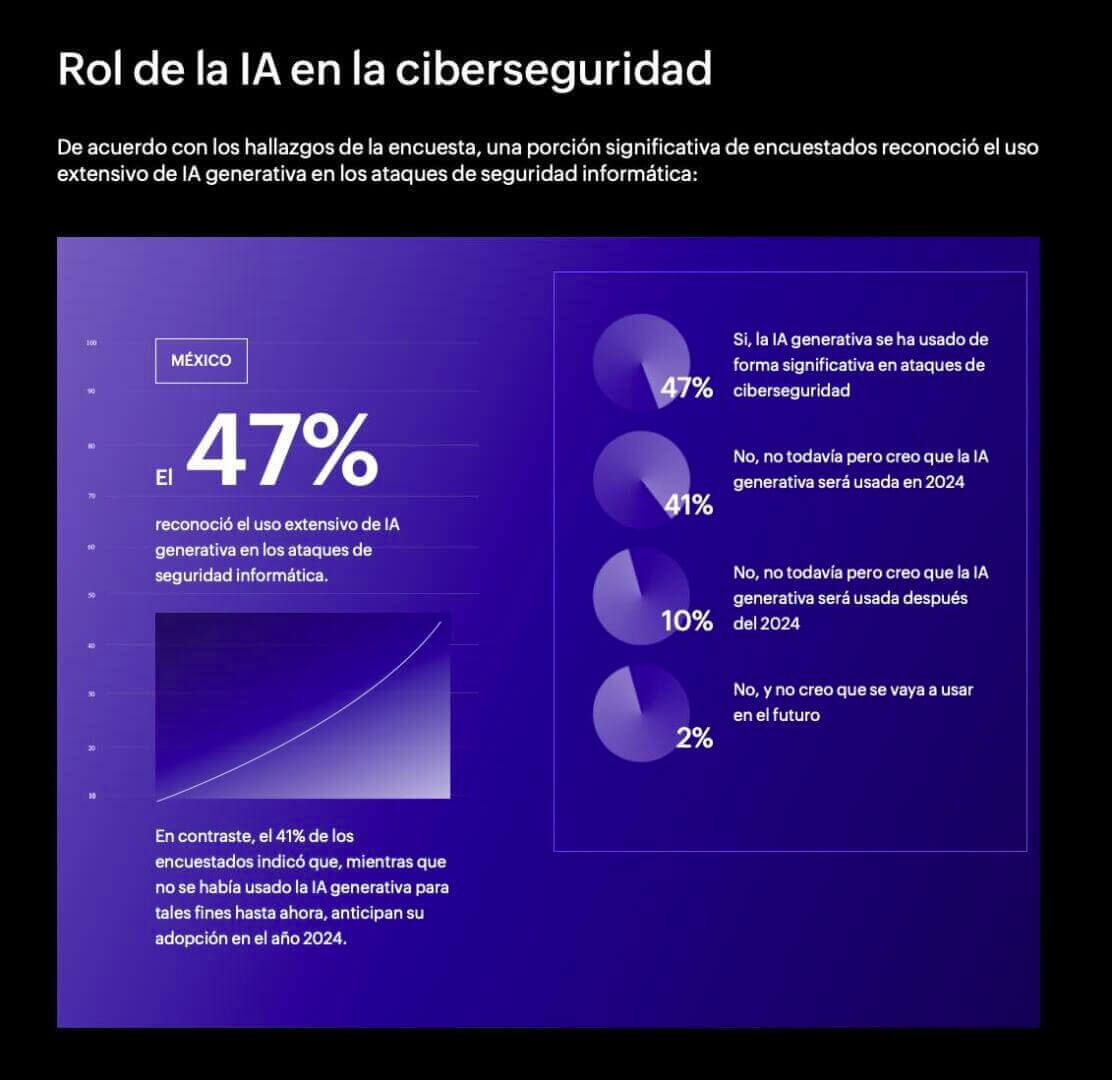

De acuerdo con el estudio sobre el ‘Estado de la ciberseguridad en América Latina‘ de Manage Engine, una porción significativa de encuestados reconoció el uso extensivo de IA generativa en los ataques de seguridad informática:

Ante este panorama, las empresas de ciberseguridad trabajan para desarrollar soluciones acorde a los retos que la IA trae, con herramientas que proporcionan capacidades avanzadas de detección con NLP, Machine Learning y Deep Learning para optimizar procesos, que permiten a las organizaciones identificar rápidamente soluciones, vulnerabilidades y debilidades de IA en sus sistemas. Así como con funciones que incluyen monitoreo pasivo de red y escaneo distribuido. “Buscamos que las organizaciones puedan abordar y minimizar los riesgos asociados con el uso de IA y, al mismo tiempo, aprovechen sin límites los beneficios que la tecnología puede aportarles al negocio”, agregó el director de Tenable.

La implementación de la inteligencia artificial (IA) presenta riesgos multidimensionales que van más allá de lo técnico, afectando áreas clave de una organización. Estos incluyen riesgos regulatorios, debido a la rápida evolución de la tecnología que supera a los marcos legales, creando vacíos normativos y dificultando la demostración de cumplimiento por la “caja negra” de los modelos. También existen riesgos reputacionales, asociados al uso de algoritmos sesgados que pueden dañar la imagen de la empresa y la confianza del público. Desde una perspectiva interna, los riesgos operativos se manifiestan a través de la baja calidad de los datos y el deterioro del rendimiento de los modelos con el tiempo (model drift), lo que puede causar fallos en los procesos de negocio.

Las organizaciones deben actuar con diligencia, adoptando tecnologías para mitigar estos desafíos y asegurar un futuro donde la innovación y la seguridad coexistan de manera armónica, bajo principios de ética de la IA para decisiones responsables y XAI. La proactividad en la gestión de riesgos será clave para navegar en esta nueva era digital, apoyándose en técnicas como RAG: recuperación aumentada de información.

Checklist de amenazas más críticas

Este listado proporciona una referencia rápida para que las organizaciones evalúen su nivel de exposición ante los riesgos emergentes de la IA:

- Amenaza de envenenamiento de Datos: ¿Se han implementado técnicas de validación y saneamiento para detectar y eliminar datos anómalos antes de que se incorporen a los conjuntos de entrenamiento?

- Amenaza adversarial: ¿Se ha probado la resiliencia de los modelos de IA (especialmente en visión por computadora o sistemas autónomos) frente a pequeñas manipulaciones de los datos de entrada?

- Amenaza de Deepfakes: ¿Existen políticas claras y mecanismos de verificación de identidad para transacciones y comunicaciones internas que puedan ser vulnerables a la suplantación de identidad?

- Amenaza de fuga de datos: ¿Se prohíbe el uso de plataformas de IA externas no aprobadas por la empresa para el procesamiento de datos sensibles o confidenciales?

- Amenaza de ataques a los LLMs: ¿Se están monitoreando y protegiendo los grandes modelos de lenguaje (LLMs) contra ataques de prompt injection o de filtración de información?

¿Cómo debe abordar un CIO el modelado de amenazas (AI Threat Modeling) en proyectos de IA?

El modelado de amenazas (threat modeling) es un enfoque estructurado y proactivo para identificar, priorizar y mitigar vulnerabilidades antes de que los sistemas sean desplegados. Para los sistemas de IA, esta práctica se vuelve crítica, ya que los ataques pueden manifestarse en el mundo físico y causar riesgos catastróficos. Un CIO debe liderar el threat modeling no solo desde la perspectiva de la seguridad de la información, sino como un pilar de la gestión del riesgo operativo y la continuidad del negocio. El objetivo es remediar las posibles vulnerabilidades antes de que puedan ser explotadas por actores maliciosos.

El modelado de amenazas para sistemas de Inteligencia Artificial es un proceso cíclico de cuatro pasos que permite a los equipos de tecnología identificar y mitigar riesgos de manera proactiva.

La primera fase, ¿En qué estamos trabajando?, se centra en la descomposición del sistema de IA, lo que implica mapear su arquitectura, los flujos de datos y sus activos críticos, incluyendo las interacciones con terceros y proveedores de datos. Este entendimiento holístico es crucial para establecer el alcance de la evaluación.

Una vez que el sistema está documentado, la segunda etapa, ¿Qué podría salir mal?, se enfoca en la identificación de amenazas. A diferencia de las taxonomías tradicionales, aquí se consideran riesgos específicos de la IA, como el robo del modelo, ataques de envenenamiento de datos, o la posibilidad de que el modelo filtre datos de entrenamiento confidenciales. Este análisis ayuda a visualizar los vectores de ataque únicos a los que se enfrenta un sistema de IA.

Los últimos dos pasos se centran en la acción y la validación. En la tercera fase, “¿Qué vamos a hacer al respecto?”, se definen e implementan medidas de mitigación concretas, que pueden ir desde la aplicación de controles de acceso robustos hasta el uso de técnicas avanzadas como el entrenamiento adversarial. La etapa final, “¿Hicimos un trabajo lo suficientemente bueno?”, asegura que el proceso sea continuo a través de la validación constante, realizando auditorías y pruebas de seguridad periódicas para verificar que las mitigaciones sean efectivas y que el sistema permanezca seguro a medida que evolucionan las amenazas.

¿Qué errores estratégicos cometen las empresas al gestionar los riesgos de IA y cómo evitarlos?

Aunque existe un gran entusiasmo por la IA, un alto porcentaje de proyectos no logran el éxito esperado, no por fallas técnicas, sino por una gestión de riesgos estratégica deficiente. Un error común es la falta de una estrategia clara, que resulta en inversiones fragmentadas y proyectos que no se alinean con los objetivos del negocio. Además, la mala calidad de los datos y la subestimación del esfuerzo de preparación de los mismos socava la precisión y fiabilidad de los modelos.

Otros fallos críticos incluyen la proliferación de la “IA en la sombra” (Shadow AI), un uso no autorizado que genera riesgos de seguridad y de cumplimiento, y la ausencia de auditoría, que puede llevar a confiar ciegamente en resultados erróneos del modelo sin la supervisión humana necesaria. Finalmente, la falta de una visión a largo plazo, al no tratar la IA como un proceso continuo y no actualizar los modelos, causa que estos se vuelvan obsoletos y pierdan su eficacia y valor con el tiempo.

Errores estratégicos vs. Recomendaciones correctivas

| Error Frecuente | Consecuencia Estratégica | Recomendación Correctiva |

| Falta de estrategia y visión | Inversiones fragmentadas, proyectos que no generan retorno de inversión. | Definir el problema de negocio antes de seleccionar la tecnología y empezar con proyectos piloto medibles. |

| Mala calidad de los datos | Modelos ineficientes, sesgados y poco fiables. | Implementar políticas de gobernanza de datos y realizar auditorías de datos regulares para asegurar su calidad y representatividad. |

| Subestimación de “Shadow AI” | Fugas de datos, vulnerabilidad a ataques, incumplimiento normativo. | Establecer políticas de uso, capacitar a los empleados sobre los riesgos y crear entornos controlados (sandboxes) para la experimentación segura. |

| Ausencia de auditoría | Filtración de errores, decisiones críticas incorrectas, pérdida de confianza. | Implementar mecanismos de supervisión humana, validación de resultados y comités de ética para revisar los modelos regularmente. |

| Ignorar la mejora continua | Modelos que se vuelven obsoletos, baja adopción y uso. | Establecer rutinas de revisión, reentrenamiento y un ciclo de vida de la IA que contemple la evolución constante del modelo. |

¿Qué marcos de gobernanza y regulaciones ayudan a controlar los riesgos de IA en Latinoamérica?

La Ley de Inteligencia Artificial de la Unión Europea (EU AI Act) representa el primer marco legal integral a nivel mundial para la gobernanza de la IA. Su alcance extraterritorial es particularmente relevante para las empresas en Latinoamérica, ya que se aplica a cualquier sistema de IA que afecte a individuos dentro de la UE, sin importar dónde fue desarrollado o usado. Esto significa que las organizaciones latinoamericanas que exportan productos o servicios con componentes de IA a Europa deberán cumplir con sus estrictos requisitos de transparencia, trazabilidad y supervisión humana. Esta dinámica está creando una convergencia global, impulsando a otras jurisdicciones a adoptar estándares comparables para mantener la interoperabilidad y la legitimidad en el comercio internacional.

Frente a la influencia europea y la necesidad de una gobernanza local, Latinoamérica está desarrollando sus propias iniciativas, a menudo con un enfoque en la soberanía tecnológica y la resolución de desafíos regionales.

- Índice Latinoamericano de Inteligencia Artificial (ILIA): Impulsado por la CEPAL y el Centro Nacional de Inteligencia Artificial (CENIA) de Chile, este índice evalúa el estado de avance de la IA en 19 países de la región. Una de sus tres dimensiones es la “Gobernanza”, que mide la madurez de las políticas públicas y los marcos regulatorios que promueven un desarrollo ético y sostenible de la IA a nivel local.

- Conpes 4144 en Colombia: El gobierno colombiano aprobó esta política pública en 2025 para fomentar el desarrollo de la IA en el país. La política se estructura en seis ejes estratégicos, incluyendo el fortalecimiento de la gobernanza y la aplicación de principios éticos, así como la mitigación de los riesgos y efectos no deseados de la IA. El objetivo es posicionar a Colombia como un referente regional en el desarrollo de IA, con un enfoque en la prosperidad económica, el bienestar social y la sostenibilidad ambiental.

- Alianza Digital UE-LAC: La Unión Europea y los países de Latinoamérica y el Caribe están colaborando para guiar la gobernanza global de la IA con un enfoque “centrado en el ser humano” que protege los derechos fundamentales. Esta alianza busca la complementariedad y la coordinación entre las agendas de ambos bloques, promoviendo la inversión y el desarrollo de soluciones adaptadas a los desafíos específicos de la región, como el proyecto Latam-GPT

¿Cómo se pueden reducir los riesgos de IA al integrar sistemas heredados y recursos limitados?

La mayoría de las organizaciones en Latinoamérica no tienen el privilegio de construir su infraestructura desde cero. Deben integrar la IA en sistemas heredados (legacy) y gestionar ecosistemas híbridos que combinan infraestructura local con la nube. Esto genera una capa adicional de complejidad y brechas de gobernanza que pueden ser explotadas por atacantes. Sin embargo, la gestión de estos riesgos no requiere una transformación completa, sino estrategias inteligentes y de bajo presupuesto.

Aquí, algunas estrategias Inteligentes de mitigación con bajo presupuesto :

- Capacitación y Up-skilling del Talento: La inversión más valiosa puede ser en el talento humano. Enseñar a los equipos existentes a supervisar y validar sistemas de IA, a entender los riesgos de la “IA en la sombra” y a seguir las mejores prácticas de seguridad es más rentable que una reestructuración completa de personal. Los líderes técnicos deben convertirse en “evangelizadores” de la IA responsable, modelando las nuevas formas de trabajo para fomentar una cultura de cumplimiento sin frenar la innovación.

- Automatización selectiva y proyectos piloto: En lugar de lanzar grandes proyectos que consumen muchos recursos, la estrategia debe enfocarse en proyectos de “victorias rápidas” que generen un valor medible y justifiquen futuras inversiones. Un ejemplo de esto es el enfoque de “juego de campo” de PwC, que se centra en pequeñas victorias que generan valor y financian la siguiente fase. Al concentrarse en automatizar tareas sencillas, se liberan recursos y se construye confianza en la tecnología de forma incremental.

- Capas de protección y validación en el perímetro: No es necesario reescribir sistemas heredados. Se pueden implementar capas de protección y validación de datos en los puntos de entrada y salida de la IA para prevenir ataques como el envenenamiento de datos. Estas capas, que incluyen controles de acceso y autenticación sólidos, actúan como un escudo, protegiendo tanto los datos sensibles como los modelos.