La Inteligencia Artificial (IA) es una realidad que está redefiniendo cada sector productivo en el mundo. A medida que su adopción se acelera, también lo hace la necesidad de un marco legal que regule su uso, minimice sus riesgos y garantice un desarrollo ético y responsable. Para el ecosistema empresarial en particular, esta ola regulatoria presenta un desafío dual: por un lado, la incertidumbre de un panorama legal en construcción y, por otro, la oportunidad estratégica de liderar en un mercado global cada vez más exigente.

En el panorama legal actual, las empresas enfrentan obligaciones y retos significativos con la llegada de las leyes de IA. Como señaló Audrey Azoulay, Directora General de la Unesco, esta organización “apoyará a sus 193 Estados Miembros en su aplicación y les pedirá que informen periódicamente sobre sus progresos y prácticas”, lo que subraya la necesidad de que las empresas se preparen para un monitoreo constante a nivel gubernamental.

Este escrutinio exige una gobernanza interna sólida, un tema que Luciano Floridi, de la Universidad de Yale, aborda al afirmar que “la IA no es neutral: está construida sobre decisiones humanas que deben ser explicadas, justificadas y, sobre todo, controladas por humanos”. Esto implica que las empresas deben garantizar una supervisión humana efectiva y transparente en los procesos de IA para mitigar riesgos.

Y de otro lado, Kristalina Georgieva, directora gerente del Fondo Monetario Internacional (FMI), es una de las voces destacadas. En 2024, durante el Foro de Davos señaló que la IA afectará a casi el 40 % de los empleos a nivel mundial, pero que su impacto será complejo, ya que, en muchos casos, la tecnología complementará el trabajo humano en lugar de reemplazarlo por completo: “Estamos a las puertas de una revolución digital que podría revitalizar la productividad, estimular el crecimiento mundial y elevar los ingresos en todo el mundo, pero que también podría reemplazar empleos y profundizar la desigualdad“.

El cumplimiento legal y ético no es solo una obligación para las empresas, sino una estrategia para el éxito en la era de la IA.

Índice de temas

¿Qué leyes y normativas regulan actualmente el uso de la Inteligencia Artificial en empresas?

El panorama regulatorio de la IA se asemeja a un mosaico en construcción, donde cada pieza, desde reglamentos vinculantes hasta recomendaciones éticas, intenta encajar para formar una imagen coherente. Este proceso global está fuertemente influenciado por la Unión Europea, cuyo marco legal está estableciendo un estándar que, por su rigor y alcance, se proyecta como un modelo de referencia para el resto del mundo, un fenómeno conocido como el ‘Efecto Bruselas’. Para las empresas colombianas, comprender este panorama es crucial, ya que el cumplimiento con estos estándares internacionales se está convirtiendo en un requisito tácito para competir y atraer inversión a nivel global.

El enfoque de la Unión Europea: el reglamento de IA y el GDPR

El marco europeo se articula sobre dos pilares fundamentales: la Ley de IA de la UE (EU AI Act) y el Reglamento General de Protección de Datos (GDPR). La EU AI Act, la primera regulación exhaustiva sobre IA de un regulador importante, clasifica los sistemas de IA según su nivel de riesgo.

- Riesgo inaceptable: Se prohíben los sistemas de IA que manipulen el comportamiento o evalúen el riesgo de un individuo basándose únicamente en perfiles de personalidad. Un ejemplo clásico son los sistemas de puntuación social gubernamentales, similares a los utilizados en China.

- Alto riesgo: Aplica a sistemas que tienen un impacto negativo en la seguridad o los derechos fundamentales de las personas. Aquí se incluyen herramientas de selección de personal, sistemas de diagnóstico médico o software de evaluación de crédito. Los proveedores de estos sistemas están sujetos a rigurosos requisitos de gobernanza de datos, documentación exhaustiva, supervisión humana obligatoria y ciberseguridad.

- Riesgo limitado: Se aplica a sistemas como los chatbots o herramientas de IA generativa. En estos casos, la obligación principal es la transparencia: se debe informar a los usuarios que están interactuando con una IA, a menos que sea obvio.

- Riesgo mínimo o nulo: La mayoría de las aplicaciones de IA, como los videojuegos o los filtros de spam, entran en esta categoría. No están explícitamente reguladas, pero se les anima a seguir un código de buenas prácticas voluntario.

Paralelamente, el GDPR no es una ley de IA, pero es su espina dorsal regulatoria. Establece las normas estrictas para el tratamiento de datos personales, que son el motor de cualquier sistema de IA. Exige el consentimiento expreso del titular para el uso de sus datos y hace que el principio de “privacidad desde el diseño” sea una obligación fundamental, lo que significa que la protección de datos debe integrarse desde el inicio del desarrollo del sistema de IA.

La guía ética de la Unesco

La Recomendación sobre la Ética de la Inteligencia Artificial de la Unesco, aprobada en 2021, opera como un instrumento de soft law. A diferencia de los reglamentos vinculantes, no impone sanciones, sino que establece principios y valores universales para guiar el desarrollo de la IA de manera ética y centrada en los derechos humanos. Estos principios, como la supervisión humana, la rendición de cuentas, la transparencia, la equidad y la protección de datos, sirven como una brújula moral para las empresas que buscan construir confianza y credibilidad.

Los proyectos de Ley en Colombia: Un mosaico en construcción

El panorama en Colombia es dinámico y se encuentra en una fase de múltiples proyectos de ley en lugar de un marco regulatorio unificado. El más reciente es el proyecto de Ley liderado por Minciencias, que le apuesta al uso ético de la IA. De momento no se ha logrado un consenso en cuanto a la regulación de la IA en Colombia. Si bien esto genera incertidumbre, demuestra que la conversación regulatoria ya está en marcha. El hecho de que Colombia esté evaluando su preparación para la implementación de la IA ética y responsable con la metodología de la Unesco subraya el compromiso del país con el desarrollo de IA a nivel global.

Este enfoque fragmentario es criticado por algunas organizaciones como Derechos Digitales, que advierten que la proliferación de proyectos de ley no siempre se traduce en una mayor protección, especialmente si se introducen excepciones basadas en “seguridad nacional” que podrían debilitar las salvaguardas de los derechos fundamentales.

| Regulación | Tipo | Clasificación de Riesgos | Principios Clave | Estado Actual |

| EU AI Act | Vinculante (Reglamento) | Inaceptable, Alto, Limitado, Mínimo | Transparencia, Supervisión Humana, Calidad de Datos, Ciberseguridad | En vigor |

| GDPR | Vinculante (Reglamento) | No aplica (se enfoca en datos personales) | Protección de Datos, Privacidad desde el Diseño, Consentimiento explícito | En vigor |

| Recomendación UNESCO | No vinculante (Soft Law) | No aplica (enfoque ético) | Derechos Humanos, Rendición de Cuentas, Transparencia, Sostenibilidad | En vigor |

| Proyectos de Ley Colombia | En discusión (PL 154-2024, PL 059-2023) | Similar a EU AI Act (Inaceptable, Alto, Limitado, Nulo) | Respeto, Privacidad, Supervisión Humana, Ciberseguridad | En discusión |

¿Cómo afectan estas leyes a la adopción y desarrollo de proyectos de IA en el entorno empresarial?

La regulación de la IA no es un tema que deba ser analizado solo por el equipo legal; su impacto es transversal a toda la organización, afectando desde la estrategia de innovación hasta la estructura de costos.

La creencia de que las restricciones regulatorias son un freno para la innovación es común, pero una perspectiva más profunda revela que el cumplimiento normativo es, de hecho, un catalizador. Una regulación clara y predecible reduce la incertidumbre legal, atrayendo inversión y fomentando la confianza del consumidor y los clientes, lo que, a largo plazo, acelera la adopción de la tecnología. El cumplimiento se transforma así en un diferenciador competitivo y un activo de marca.

La implementación de la IA requiere un nuevo modelo operativo. Las empresas deben adaptar sus políticas y procesos internos para integrar la gobernanza de la IA desde el diseño. Esto implica más que una simple revisión de la política de datos; se necesita una función de compliance –conjunto de procesos, medidas y políticas que una organización implementa para asegurar que el uso, desarrollo y despliegue de sus sistemas de IA cumplan con todas las normativas legales y éticas aplicables – especializada en IA que supervise los modelos, audite los algoritmos y gestione los riesgos asociados.

Un aspecto a menudo subestimado son los costos de este cumplimiento. El gasto en IA se suele enfocar en la adquisición de hardware, recursos en la nube o talento técnico. Sin embargo, los costos de compliance pueden ser considerablemente más altos. De hecho, un estudio de Harvard encontró que para las startups, los costos de cumplimiento pueden llegar a ser hasta 2,3 veces mayores que los de investigación y desarrollo (I+D), creando una “trampa de cumplimiento” que puede limitar su capacidad para competir con empresas más grandes. Esto subraya la necesidad de presupuestar la preparación legal y ética desde las fases más tempranas del proyecto, y no como un gasto imprevisto de última hora.

El uso de la IA, si no se gestiona adecuadamente, expone a las empresas a una serie de riesgos legales que van más allá de una simple multa.

- Sesgo y Discriminación: Los sistemas de IA aprenden de los datos con los que son entrenados. Si estos datos reflejan prejuicios históricos, el sistema replicará y amplificará esos sesgos. Esto puede llevar a decisiones discriminatorias en áreas críticas como la selección de personal, el otorgamiento de créditos o el pricing dinámico, abriendo la puerta a demandas legales y a un grave daño reputacional.5 La calidad de los datos no es solo un reto técnico; es una obligación legal.

- Opacidad y falta de explicabilidad: Para los sistemas de IA de alto riesgo, la ley exige que sus decisiones sean transparentes y explicables. Si un algoritmo de “caja negra” rechaza un candidato a un empleo o una solicitud de préstamo, la empresa debe ser capaz de justificar la decisión. Si no se puede, se enfrenta a un riesgo legal significativo por falta de rendición de cuentas.

- Alucinaciones y desinformación: Los modelos de IA generativa pueden producir contenido verosímil pero completamente falso, lo que se conoce como alucinaciones. En contextos críticos, como en la redacción de informes legales, médicos o financieros, un simple “copiar-pegar” sin contraste humano puede derivar en decisiones equivocadas con graves consecuencias legales. La responsabilidad por estas alucinaciones recae sobre la persona o la entidad que utiliza el sistema de forma irresponsable.

Pero, ¿cuál podría ser el impacto regulatorio en los diferentes sectores productivos? Depende de diferentes aristas, sin embargo, se considera un impacto alto en áreas como la salud, debido al manejo de datos médicos sensibles y las decisiones de diagnóstico que pueden afectar la vida humana; en finanzas, por su rol en la evaluación de crédito y la gestión de riesgo que impactan directamente la economía de las personas; y en recursos humanos, donde la IA influye en la selección de personal y las decisiones que afectan los derechos laborales.

El impacto medio se observa en sectores como la logística, con la optimización de rutas y la gestión de inventario, y en el marketing, con la personalización de campañas y el uso de chatbots. Finalmente, el impacto es bajo en la manufactura, donde la automatización de procesos industriales tiene un menor impacto directo en los derechos humanos, y en el retail, con la recomendación de productos y el análisis de tendencias de consumo.

¿Qué obligaciones y responsabilidades tienen los directivos frente a la regulación de la Inteligencia Artificial?

La IA es una tecnología transversal que impacta en múltiples departamentos, desde el desarrollo hasta el marketing y el área legal.Por ello, la gobernanza de la IA es, en esencia, una tarea de la alta dirección, no solo del CTO o el equipo de datos. Un estudio de Deloitte revela que el 71 % de las organizaciones que usan IA carecen de un marco de cumplimiento consistente, lo que subraya la necesidad de un liderazgo proactivo. La responsabilidad de los directivos es la piedra angular para evitar el caos regulatorio y mitigar riesgos.

Las normativas, tanto en Europa como en Colombia, enfatizan la necesidad de una “supervisión y decisión humanas” en los sistemas de IA. Esto no significa frenar la automatización, sino asegurar que una persona capacitada sea capaz de intervenir, comprender y, si es necesario, anular las decisiones tomadas por la IA en escenarios de alto riesgo. Los directivos deben:

- Inventariar y clasificar la IA: El primer paso es identificar todos los sistemas de IA en uso y clasificarlos según su nivel de riesgo, para enfocar los esfuerzos de cumplimiento donde realmente importa.

- Autorizar su uso: Es fundamental establecer políticas internas que definan qué herramientas de IA puede utilizar el personal, cómo y hasta qué punto, para evitar usos irresponsables o no autorizados.

- Asegurar la trazabilidad: Los directivos tienen la obligación de garantizar que cada proceso de desarrollo, revisión humana y justificación técnica esté documentado. Esta “responsabilidad demostrable” es un concepto central que permite la auditabilidad del sistema y genera confianza.

Más allá del cumplimiento, las directivas deben asumir un papel activo en la definición de la estrategia de IA de la organización, integrando la ética en la visión de la empresa. Esto se logra mediante la creación de un Comité de Ética de IA, un grupo diverso con experiencia en tecnología, derecho, ética y otras disciplinas relevantes, que supervise el diseño e implementación de la IA. Este comité es responsable de definir políticas de uso, estándares de calidad de datos y protocolos de comunicación para mantener la transparencia.

La responsabilidad no es solo reactiva (ante un fallo), sino proactiva (desde el diseño). Exigir garantías contractuales a los proveedores externos y asegurar que los sistemas se construyan con seguridad desde el inicio son acciones clave para mitigar riesgos antes de que se materialicen.

Checklist de Gobernanza IA para la Alta Dirección

- Nombrar a un responsable de la IA, como un Director de Datos (CDO) o de IA (CDAO), que lidere la estrategia.

- Crear un Comité de Ética de IA o un grupo de trabajo interfuncional (legal, técnico, marketing) para supervisar las iniciativas.

- Realizar un inventario de todos los sistemas de IA en uso en la organización.

- Clasificar los sistemas por nivel de riesgo (inaceptable, alto, limitado, nulo) para priorizar las acciones de cumplimiento.

- Definir y documentar políticas internas de uso de datos, privacidad y seguridad.

- Exigir garantías contractuales a los proveedores de soluciones de IA, incluyendo cláusulas de auditoría y responsabilidad compartida.

- Garantizar la supervisión humana en las decisiones críticas tomadas por sistemas de alto riesgo.

- Implementar mecanismos de auditoría continua para rastrear el rendimiento del modelo, los sesgos y los outputs.

¿Cuáles son los riesgos y sanciones por incumplir la legislación sobre Inteligencia Artificial?

El incumplimiento de la legislación sobre IA acarrea una triada de consecuencias que pueden poner en jaque la viabilidad de cualquier empresa: sanciones económicas, riesgos legales y, quizás el más devastador, el daño reputacional.

Las multas por incumplimiento de normativas de datos y IA son un claro incentivo económico. El GDPR de la UE, que sirve como un referente de lo que podría venir para la región, establece multas que pueden alcanzar hasta los 20 millones de euros o el 4 % de la facturación global anual, aplicando la cifra que sea mayor. Este modelo, basado en el volumen de negocio, impacta tanto a gigantes tecnológicos como a pequeñas y medianas empresas.

En Colombia, la Superintendencia de Industria y Comercio (SIC) tiene la facultad de imponer sanciones por incumplimiento de la Ley 1581 de 2012 de protección de datos personales, lo que sugiere que podría ser la autoridad designada para la futura regulación de la IA.

Un ejemplo reciente es la sanción impuesta en 2025 a Risk International por infringir el régimen de protección de datos personales, la SIC determinó que la empresa desconoció la legislación sobre protección de datos personales, al crear y gestionar un sistema de información con datos personales sensibles, sin contar con la autorización previa, expresa e informada de los titulares de la información y confirmó la sanción por $190.547.400. Otro caso notorio es el de la la sanción de 2025 a Mercado Libre por la violación al régimen de Datos Personales, en especial, al condicionar el acceso a la cuenta de una persona al suministro de su información biométrica, a través de reconocimiento facial. Solo por recordar los más recientes.

Además de las multas, las empresas pueden enfrentar demandas civiles por discriminación, violación de la privacidad, o daños derivados del mal funcionamiento de un sistema de IA. La falta de transparencia o la incapacidad para justificar una decisión algorítmica puede ser utilizada como evidencia en un litigio, aumentando la responsabilidad legal de la compañía.

Riesgos reputacionales y la amenaza del AI Washing

La pérdida de confianza del mercado puede ser un castigo más severo que cualquier multa. La reputación, ese activo intangible construido con años de esfuerzo, puede desmoronarse en cuestión de horas. En un mundo hiperconectado, la falta de transparencia o el uso irresponsable de la IA no tardan en ser expuestos por clientes, inversores o la prensa. El concepto de “AI Washing” —mentir sobre el uso de la IA o exagerar su capacidad para parecer más innovador de lo que realmente se es— representa un riesgo existencial.

Un ejemplo es el caso de la startup Delphia, que fue sancionada por la Comisión de Bolsa y Valores de EE. UU. (SEC) por afirmar que utilizaba IA para su fondo de inversión cuando en realidad no lo hacía. La sanción no solo fue económica, sino que destruyó por completo su credibilidad y la convirtió en un caso de advertencia para todo el ecosistema tecnológico.

Riesgos y sanciones por incumplimiento de la Legislación IA

| Tipo de Incumplimiento | Riesgos Asociados | Escenario de Negocio | Sanción Potencial |

| Sesgo en el algoritmo | Legal, Reputacional, Financiero | Herramienta de selección de personal que favorece a un grupo demográfico específico. | Demandas por discriminación, pérdida de talento, multas. |

| Falta de transparencia | Legal, Reputacional | Un sistema de scoring crediticio rechaza un préstamo sin poder explicar el motivo. | Sanciones por falta de rendición de cuentas, pérdida de clientes. |

| Alucinaciones | Legal, Financiero, Reputacional | El departamento financiero usa un modelo de IA generativa para un reporte y este inventa datos o cifras. | Responsabilidad civil por información errónea, daño a la marca. |

| AI Washing | Reputacional, Financiero, Legal | Una startup afirma en sus comunicados que utiliza IA para optimizar procesos cuando solo usa software básico. | Pérdida de confianza de inversores, colapso de la empresa, sanciones de reguladores (ej. SEC). |

| Violación de privacidad | Legal, Financiero | Un modelo de IA usa datos personales sin el consentimiento explícito de los titulares. | Multas (ej. multas de la SIC), pérdida de datos sensibles, demandas. |

¿Cómo deben las empresas prepararse para futuras regulaciones de IA?

La preparación para la regulación de la IA no debe ser vista como un proyecto de una sola vez, sino como un proceso continuo y dinámico que se adapta al ritmo de la tecnología.Un enfoque proactivo, que comienza hoy, es la única forma de mitigar los riesgos y asegurar que la empresa esté lista para operar en el futuro marco legal colombiano e internacional. De momento, no existe una ley que regule la IA en Colombia, por lo que hay que estar al tanto de las actualizaciones de la normatividad y participar de las mesas de trabajo que se crean en esta materia.

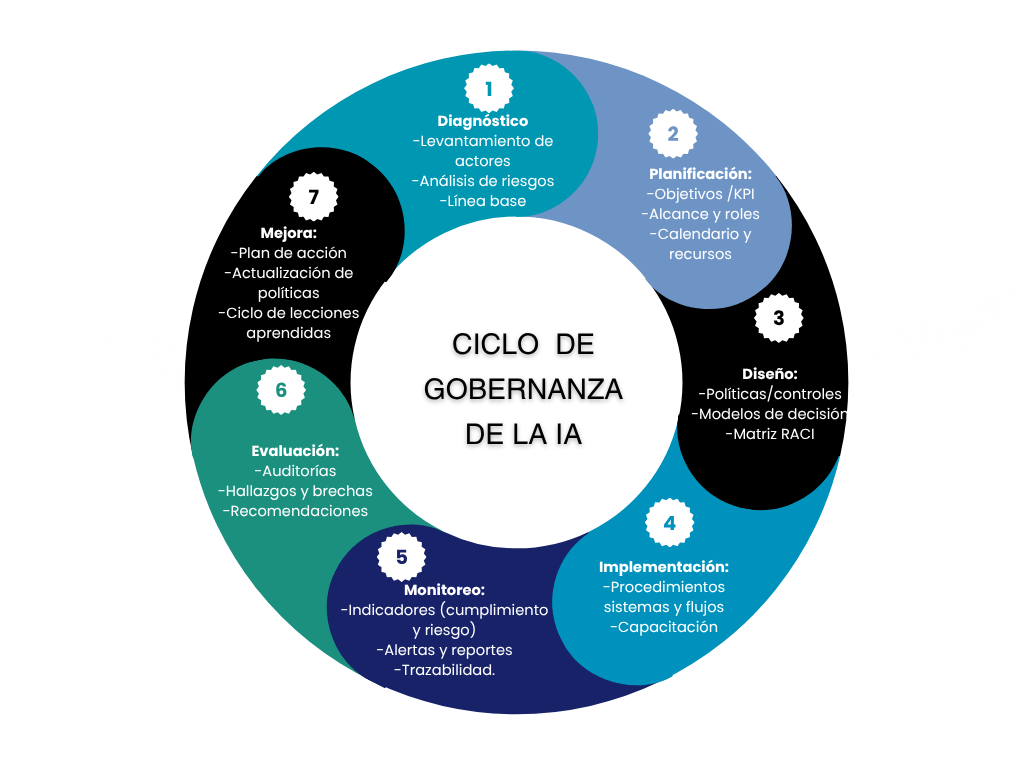

Para preparase de cara a la regulación de la Inteligencia Artificial (IA), las empresas deben seguir un enfoque gradual que involucre a todos los niveles de la organización. El proceso se inicia con una fase de diagnóstico para identificar y clasificar todas las herramientas de IA en uso según su nivel de riesgo, creando así un inventario claro. Paralelamente, es crucial establecer un marco de gobernanza sólido y formar un comité de ética para definir políticas internas, roles y responsabilidades.

Una vez establecidos los cimientos, la siguiente fase se centra en la adopción e implementación de medidas. Esto incluye la adaptación de políticas internas sobre datos y ciberseguridad, así como la definición de requisitos de cumplimiento con proveedores. A largo plazo, se deben implementar procesos de monitoreo continuo, como auditorías de sesgo y explicabilidad de los modelos. La formación constante del personal es fundamental para asegurar que todos los miembros de la empresa entiendan la ética y las responsabilidades asociadas al uso de la IA, lo que reduce riesgos y fomenta una cultura de cumplimiento.

¿Qué desafíos presenta la armonización de leyes de IA entre diferentes países o regiones?

El panorama regulatorio en el que operan las empresas multinacionales es un desafío complejo. A diferencia de la UE, que busca un mercado único con reglas armonizadas, América Latina se caracteriza por la baja densidad normativa y los débiles lazos de integración en este campo. Esto significa que, aunque la influencia de la EU AI Act es innegable, cada país de la región avanza con sus propias iniciativas, creando un mosaico de regulaciones fragmentarias que complican la expansión y la operación a escala.

La falta de un marco unificado en la región obliga a las empresas a navegar por un conjunto de reglas dispares. Un sistema de IA que cumpla con los requisitos en Colombia puede no serlo en Brasil, que ya tiene una ley de protección de datos (LGPD) influenciada por el GDPR, o en Chile, que se ha posicionado como un líder regional al explorar la regulación de los “neuroderechos”.

Este fenómeno refleja una diferencia de fondo en la filosofía regulatoria. Mientras que Europa se enfoca en la gobernanza de mercado y los derechos fundamentales, países en Latinoamérica podrían inclinarse hacia una regulación que refleje preocupaciones sociales y culturales específicas, como la protección de la privacidad mental. Esta no es una simple cuestión de incumplimiento; es un desafío de adaptación estratégica y localización legal. Para las empresas, esto se traduce en mayores costos de operación, la necesidad de equipos legales locales en cada jurisdicción y la dificultad para escalar soluciones de manera uniforme.

¿Qué buenas prácticas ayudan a garantizar el cumplimiento legal y ético de la inteligencia artificial en la empresa?

El cumplimiento legal de la IA y su desarrollo ético son dos caras de la misma moneda. Las leyes imponen el “qué” —evitar el sesgo, ser transparente—, pero la ética proporciona el “porqué” y el “cómo” —por qué es importante la equidad, cómo se audita—. Adoptar buenas prácticas no es solo un escudo legal, sino un diferenciador que genera confianza, atrae talento y posiciona a la empresa como un líder responsable en el mercado. El éxito de esta estrategia no depende de un solo departamento, sino de un esfuerzo holístico que permee toda la cultura corporativa.

El desarrollo de una IA confiable se basa en una serie de principios fundamentales y acciones tangibles que los directivos y los equipos pueden implementar .

Checklist de Buenas Prácticas para una IA Confiable

- Integración estratégica: Integrar los principios de la IA ética en la visión y los valores de la empresa.

- Gobernanza: Establecer un comité de ética de IA para la toma de decisiones y la supervisión.

- Documentación: Documentar el origen, la calidad y la seguridad de los datos utilizados para entrenar los modelos.

- Mitigación de sesgos: Realizar pruebas continuas para detectar sesgos en los datos y los algoritmos.

- Transparencia: Informar a los usuarios cuándo están interactuando con un sistema de IA.

- Explicabilidad: Mantener registros de auditoría y asegurar que las decisiones de los sistemas sean comprensibles para los interesados.

- Seguridad: Implementar barreras de seguridad para contenidos dañinos y un plan de respuesta a incidentes.

- Formación: Capacitar a toda la organización sobre el uso responsable y ético de la IA

- Diversidad: Promover la diversidad en los equipos de desarrollo para evitar la replicación de sesgos sociales.

El camino hacia la regulación de la IA en Colombia es inevitable y complejo. Sin embargo, para los líderes de empresas tecnológicas, el verdadero reto no es esperar a que se apruebe una ley, sino anticipar sus principios y convertir la responsabilidad ética y legal en un motor de crecimiento. Aquellas empresas que adopten una postura proactiva, inviertan en la gobernanza de la IA y construyan la confianza de sus clientes serán las que lideren la próxima fase de la transformación digital en la región.