Desde los años 70, cuando las empresas comenzaron a manejar volúmenes cada vez mayores de datos, surgió la necesidad de procesarlos de forma ordenada y eficiente. Fue así como nació el proceso ETL (Extract, Transform, Load), una herramienta clave para integrar datos de distintas fuentes y prepararlos para el análisis.

Hoy, en plena era del big data y la inteligencia artificial, ETL sigue siendo fundamental. Aunque han surgido enfoques más modernos como ELT, el objetivo permanece: transformar los datos en conocimiento significativo que impulse valor en diversos contextos.

Índice de temas

¿Qué es un proceso ETL y por qué sigue siendo crucial en la integración de datos empresariales?

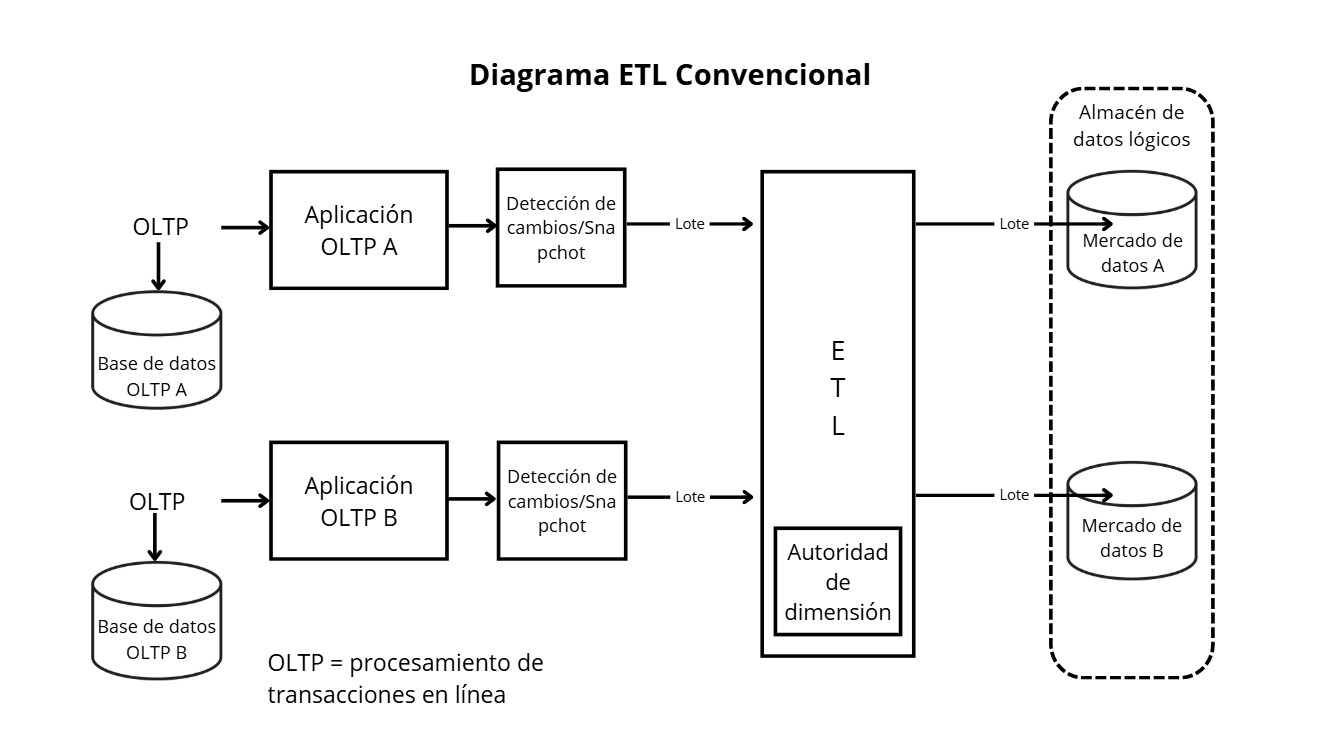

El proceso ETL (Extract – Transform – Load) permite reunir datos que provienen de diferentes fuentes —como aplicaciones, bases de datos o archivos— y prepararlos para su uso, sin importar si esos datos están almacenados en servidores propios de la empresa (on-premise), en la nube o en una combinación de ambos entornos (híbrido).

Tal como describe Gartner en su clasificación de data integration tools, estas herramientas permiten unir datos de sistemas diversos, ejecutando tareas de acceso, transformación, enriquecimiento y entrega, y están diseñadas para funcionar en entornos SaaS, nubes públicas o privadas, o configuraciones híbridas.

El proceso se desarrolla en tres etapas principales:

- Extract (Extracción): Se recolectan datos de distintas fuentes como bases de datos, aplicaciones empresariales, archivos.

- Transform (Transformación): Los datos extraídos se limpian, normalizan y adaptan para asegurar consistencia y calidad.

- Load (Carga): Los datos transformados se envían a un sistema central —como puede ser un data warehouse híbrido o multicloud— listo para análisis, inteligencia empresarial o procesos avanzados como IA.

Gracias a esta estructura, ETL permite que los datos lleguen limpios, organizados y listos para ser utilizados en distintos entornos empresariales.

¿Cuáles son los beneficios reales de implementar ETL en la toma de decisiones empresariales?

Implementar un proceso ETL adecuado aporta eficiencia operativa, consistencia de datos y una visión clara del negocio. Al automatizar flujos de datos, se acelera el acceso a información limpia y estandarizada, lo que reduce el time-to-insight —es decir, el tiempo que tarda una empresa en obtener información útil a partir de sus datos— y minimiza errores manuales, provocando mejoras concretas en KPIs (indicadores clave de desempeño).

Desde la perspectiva financiera, este impacto es directo en ROI y costos operativos: estudios de McKinsey muestran que las compañías con estrategias de datos maduras reducen en promedio un 25 % sus gastos operativos, mientras que Gartner estima que la baja calidad de datos cuesta 12,9 millones USD anuales por empresa. Adoptar ETL no solo evita pérdidas, sino que también acelera el retorno de inversión (ROI) en proyectos de digitalización y analítica avanzada.

Ejemplos recientes lo demuestran: según la Revista Internacional de Investigación y Desarrollo Novedosos (IJNRD) en entornos financieros, una optimización de pipelines ETL redujo la tasa de errores en un 56%, mientras que los tiempos de extracción y transformación disminuyeron entre un 40% y un 46%.

Un estudio publicado en arXiv.org analizó el uso de ETL con GPUs en el sector de movilidad.

El enfoque permitió procesar datos de vehículos conectados en solo 25 minutos, cuando antes se necesitaban 48 horas.

El resultado: una mejora de rendimiento 70 veces superior.

Un análisis de McKinsey resalta que una estrategia digital sólida —en la que ETL es fundamental— permite que las empresas “aumenten ingresos y reduzcan costos más rápido que otras”.

Para dimensionar este impacto, la siguiente tabla compara los beneficios de un proceso ETL frente a la gestión manual de datos o el uso de herramientas no integradas:

| Aspecto | Procesos ETL | Procesos manuales / herramientas no integradas |

| Velocidad de procesamiento | Altamente automatizado: transforma y carga datos en minutos u horas según volumen. | Lento: requiere horas o días por intervención humana y consolidación manual. |

| Precisión de datos | Alta: aplica validaciones y limpieza automática, minimizando errores humanos. | Baja: propenso a errores por digitación, duplicados o datos incompletos. |

| Escalabilidad | Escalable: puede manejar volúmenes crecientes sin aumento proporcional de recursos humanos. | Limitada: requiere más personal y tiempo al aumentar el volumen de datos. |

| Costo operativo a largo plazo | Menor: inversión inicial compensada por reducción de horas de trabajo y errores. | Mayor: alto gasto en horas hombre y en corrección de errores. |

| Calidad y consistencia de la información | Alta: datos unificados, estandarizados y listos para análisis en tiempo real. | Inconsistente: múltiples formatos y fuentes, difícil de consolidar. |

| Disponibilidad para toma de decisiones | Rápida: reducción significativa del time-to-insight y mejora de KPIs estratégicos. | Lenta: información fragmentada y no siempre actualizada. |

| Seguridad y trazabilidad | Integración con controles de acceso y auditoría centralizada. | Riesgo alto: difícil rastrear cambios y accesos en entornos dispersos. |

De acuerdo con la Universidad de Carolina del Sur (USC, por sus siglas en inglés), los procesos ETL son esenciales para integrar y analizar datos en el sector sanitario, pero enfrentan retos complejos.

El estudio advierte que “son cruciales para integrar y analizar estos datos para apoyar la toma de decisiones y mejorar la atención al paciente. Sin embargo, enfrentan desafíos importantes, como diversidad de datos, problemas de calidad, seguridad y cumplimiento, además de escalabilidad”.

La investigación propone como soluciones la paralelización de procesos, el uso de contenedores y la adopción de herramientas de analítica avanzada.

¿Cuándo conviene usar una arquitectura ETL tradicional y cuándo optar por ELT u otros enfoques modernos?

Actualmente, el proceso ETL convive con enfoques más recientes como ELT y arquitecturas de streaming, que responden a necesidades distintas en la integración de datos.

Mientras ETL procesa y transforma la información antes de cargarla, ELT aprovecha la potencia de las plataformas modernas para transformar después de la carga, y el streaming permite trabajar con flujos continuos en tiempo real.

Algunos criterios clave para decidir entre ETL, ELT o streaming se resumen en la siguiente tabla:

| Enfoque | Cuándo es adecuado | Fortalezas principales | Consideraciones clave |

| ETL tradicional | Cuando se trabaja con datos estructurados y hay fuerte énfasis en la calidad, el cumplimiento normativo o la estandarización previa. | Asegura limpieza y validación antes de cargar, ideal para entornos regulados como salud o finanzas. | Puede ser más lento y requiere infraestructura dedicada. |

| ELT (Extract, Load, Transform) | En entornos cloud con data lakes o almacenes escalables, cuando se maneja gran volumen, formatos variados o se requiere rapidez. | Permite carga rápida (reduce latencia analítica) y aprovecha el poder de cómputo del data warehouse. | Consume más almacenamiento y requiere capacidad de procesamiento en destino. |

| Streaming / arquitecturas modernas (tipo Lambda) | Cuando se necesita procesamiento en tiempo real o baja latencia, como monitoreo operativo o análisis continuo. | Combina procesamiento por lotes con capa de velocidad (streaming) para equilibrar precisión y frescura de datos. | Mayor complejidad operacional y de diseño. |

El ETL, el ELT y los enfoques de streaming están diseñados para satisfacer distintas necesidades empresariales. La clave está en entender el contexto de datos, requisitos de latencia, volumen y marco regulatorio de la empresa, para aplicar la estrategia adecuada o incluso combinarlas según los distintos flujos y usos de datos.

Según la Revista de la Sociedad Europea de Práctica de Aplicaciones de Tecnologías Emergentes (ESPJETA, por sus siglas en inglés), la integración en tiempo real puede “mejorar significativamente la eficiencia operativa” en sectores como finanzas, comercio electrónico, salud y manufactura.

El informe señala que las organizaciones que aplican sincronización de datos mientras estos se generan, obtienen ventajas inmediatas en detección de fraudes, personalización de ofertas y monitoreo de procesos críticos. Además, recomienda el uso de herramientas como Apache Kafka o Flink, siempre bajo criterios de validación, escalabilidad y seguridad.

Por otra parte, la Asociación Internacional de Certificación en Análisis de Negocios (IABAC, por sus siglas en inglés) difundió un artículo guía para orientar esta elección y para entender cómo estos enfoques pueden coexistir estratégicamente.

La asociación comparte que, sea para ETL o ELT, existen varias tendencias que influirán en la forma en que las empresas las conciben.

- La nube como estándar empresarial: Cada vez más organizaciones confían en plataformas cloud para manejar grandes volúmenes de información con menor costo.

- Acceso a datos más allá del área técnica: Hoy los datos no son exclusivos de ingenieros: áreas como marketing, producto, análisis de negocio o ciencia de datos también requieren consultarlos y transformarlos.

- Mayor presión regulatoria sobre la privacidad: legislaciones como RGPD o CCPA demandan que ciertos datos se anonimicen o modifiquen antes de su almacenamiento.

- Demanda creciente de información en tiempo real: Las compañías necesitan respuestas inmediatas para escenarios como IoT, monitoreo de eventos o analítica en vivo. En estos casos, ETL puede ofrecer mejores resultados al procesar datos con rapidez y consistencia.

¿Qué errores comunes deben evitarse al implementar un proceso ETL?

Al implementar ETL, conviene estar atento a errores frecuentes que pueden comprometer la calidad y eficiencia del flujo de datos. Estos suelen incluir:

- Transformaciones mal diseñadas o sin pruebas adecuadas: Las transformaciones equivocadas dentro de un flujo ETL son difíciles de detectar y pueden introducir distorsiones en los datos finales. Un estudio de investigación encontró que un gran número de problemas en pipelines de datos surgen por tipos de datos incorrectos (33 %) y errores en limpieza o transformación (35 %).

- Falta de validación de datos en cada fase: No contar con validaciones sólidas en cada fase del proceso ETL —desde la extracción hasta la carga— puede derivar en datos incompletos, inconsistentes o directamente erróneos en los sistemas de destino. Es esencial implementar controles sistemáticos de formatos, consistencia y lógica previa a la carga.

- Sobrecarga del sistema y problemas de rendimiento: ETL que no está optimizado con controles como reintentos inteligentes o monitoreo puede colapsar frente a fallos comunes como timeouts, errores de red o datos inconsistentes.

- Ausencia de alertas, documentación y políticas de recuperación: saltarse pruebas, omitir mecanismos de retrial y tener poca trazabilidad complica detectar y responder a errores.

Fallos en transformaciones, sobrecarga de sistemas o falta de pruebas pueden parecer detalles operativos, pero su impacto puede ser enorme si afectan la calidad de los datos.

Según Gartner, la baja calidad de los datos le cuesta a las organizaciones en promedio 12,9 millones de dólares al año, lo cual subraya la urgencia de prestar atención tanto al proceso como al recurso más crítico: los datos mismos.

¿Qué herramientas ETL son más efectivas para una organización en crecimiento?

Al seleccionar herramientas ETL, las empresas en crecimiento deben considerar escalabilidad, soporte para entornos cloud, facilidad de integración y coste, equilibrando opciones open source y comerciales.

La siguiente tabla compara algunas de las plataformas más representativas —tanto open source como comerciales— que destacan en evaluaciones recientes de Gartner y la Apache Foundation:

| Herramienta | Tipo | Descripción | Escalabilidad | Soporte Cloud | Facilidad de integración | Costo/Modelo |

| AWS Glue | Comercial | Servicio serverless de AWS para integrar y transformar datos con escalabilidad automática, ideal para empresas que ya trabajan en el ecosistema AWS. | Alta, automática | Nativo AWS | Muy alta dentro de AWS | Pago por uso |

| Airbyte | Open Source | Plataforma moderna de integración con conectores preconstruidos y flexibles. Destaca por su facilidad de uso y bajo costo. | Alta, modular | Multi-cloud | Elevada (gran ecosistema de conectores) | Gratuito / Bajo costo |

| Informatica PowerCenter / IDMC | Comercial | Suite empresarial con capacidades avanzadas de gobernanza, calidad de datos y soporte para entornos híbridos y multinube, recomendada para grandes empresas con procesos críticos. | Alta empresarial | Híbrido / Multicloud | Muy alta (funcionalidades amplias) | Licencia corporativa |

| Apache NiFi | Open Source | Proyecto de la Apache Foundation orientado a flujos de datos en tiempo real, con enrutamiento, seguridad y monitorización integrados. Muy útil en IoT y telecomunicaciones. | Alta, clusterable | Multi-cloud / On-prem | Alta (procesadores integrados) | Gratuito |

En síntesis, la elección de una herramienta ETL debe considerar múltiples factores, pero lo esencial es adoptar la que mejor se alinee con la estrategia de datos y los recursos internos de cada empresa.

¿Cómo se integra un proceso ETL con plataformas cloud y entornos de big data?

Integrar ETL con entornos modernos implica conectar flujos de datos desde múltiples orígenes hacia arquitecturas escalables como lagos de datos (data lakes), lagos-almacén (lakehouses) o clusters de procesamiento distribuido tipo Apache Spark. Esta integración habilita análisis avanzados, facilita el acceso en tiempo real y optimiza recursos en la nube.

Un ejemplo de ello se observa en las arquitecturas lakehouse, donde una fase inicial de ETL carga los datos en almacenamiento económico (como Amazon S3 o Azure Data Lake Storage).

Desde allí, se transforman y usan directamente en analytics avanzadas o BI sin replicación innecesaria. Este enfoque combina la flexibilidad del lago de datos con la confiabilidad de un data warehouse tradicional.

La forma más dramática de afectar el rendimiento en un gran data warehouse es proporcionar un conjunto adecuado de registros agregados que coexistan con los registros base primarios. Los agregados pueden tener un efecto muy significativo en el rendimiento, en algunos casos acelerando las consultas en un factor de cien o incluso mil, Ralph Kimball, pionero en Diseño de Data Warehousing

Otro caso ilustrativo es el de Intel. La empresa migró sus pipelines ETL a la nube utilizando Databricks, una plataforma basada en Spark.

El cambio permitió una reducción del 65 % en los tiempos de ejecución, una disminución del 58 % en fallos de trabajo y una caída del 50 % en incidentes reportados por usuarios.

Finalmente, la investigación académica y aplicada en diseño técnico de integración cloud propone patrones arquitectónicos que combinan ETL incremental y de recarga total, apoyados en frameworks basados en metadatos. Estos permiten adaptarse de manera flexible a nuevos orígenes y gestionar cambios de esquema con bajo esfuerzo.

Los siguientes son los componentes esenciales de la integración de ETL en entornos cloud y big data:

¿Qué perfiles profesionales y recursos necesita una empresa para mantener un ETL eficiente?

Para que un proceso ETL funcione de manera eficiente y pueda escalar, no basta con la herramienta: se necesitan roles especializados que aseguren el diseño, operación y evolución de los pipelines de datos.

Algunos roles fundamentales son:

| Perfil | Competencias clave |

| Data Engineer | Diseñar pipelines ETL/ELT, performance tuning, tecnologías cloud (Spark, SQL, Kafka) |

| Data Steward / Custodian | Gobernanza, estándares, calidad de datos, metadata management |

| Data Analyst / BI Dev | Herramientas BI, interpretación de datos, visualización y storytelling con datos |

| DevOps / DataOps Engineer | Automatización, monitoreo, orquestación y pruebas de pipelines ET |

En cuanto a la estrategia de talento, las empresas con mayor madurez digital suelen optar por equipos in-house, ya que esto les da control sobre gobernanza y capacidad de iterar con rapidez. En cambio, las compañías en etapas iniciales o con proyectos de menor escala pueden beneficiarse del outsourcing, siempre que mantengan en la empresa los roles críticos de gobernanza y arquitectura.

En cualquier caso, hay un conjunto mínimo de capacidades tecnológicas necesarias para garantizar la eficiencia: plataformas de orquestación (como Apache Airflow o Prefect), herramientas cloud nativas para ETL/ELT (p. ej. AWS Glue, Databricks) y sistemas de observabilidad de datos que aseguren la calidad y confiabilidad de los pipelines.

Preguntas frecuentes sobre ETL

¿Cómo puede un CIO calcular el retorno de inversión (ROI) de un proyecto ETL?

El ROI se mide comparando la reducción de costos operativos y de errores frente a la inversión en infraestructura y talento. Estudios de consultoras señalan ahorros de hasta 25 % en gastos operativos tras la adopción de ETL.

¿Qué criterios debe evaluar un CISO al implementar ETL en sectores regulados?

Debe priorizar el cumplimiento normativo (ej. RGPD, HIPAA), anonimización de datos sensibles y trazabilidad de accesos. ETL debe integrarse con políticas de gobernanza y auditoría de seguridad.

¿Cuál es la diferencia en costos a largo plazo entre ETL on-premise y en la nube?

On-premise implica altos gastos iniciales en hardware y mantenimiento. En la nube, el modelo de pago por uso reduce el CAPEX y escala de manera flexible, aunque puede aumentar el OPEX si no se optimiza el consumo.

¿Cómo afecta ETL a la estrategia de datos en fusiones o adquisiciones empresariales?

ETL permite unificar fuentes dispares de datos rápidamente, garantizando calidad y consistencia. Esto acelera la integración de sistemas y facilita decisiones estratégicas durante la transición.

¿Qué indicadores clave (KPIs) permiten medir la eficiencia de un pipeline ETL?

Algunos KPIs comunes son: tiempo promedio de ejecución, tasa de errores en transformaciones, costo por terabyte procesado y reducción del time-to-insight en reportes críticos.