En la economía digital actual, las empresas generan cantidades masivas de datos que necesitan analizarse de forma ágil para obtener valor real. Apache Spark es un motor de procesamiento de datos distribuidos, diseñado para analizar grandes volúmenes de información a una velocidad muy superior a tecnologías previas como Hadoop MapReduce.

Su versatilidad y su ecosistema abierto han hecho que Spark se convierta en uno de los pilares tecnológicos del Big Data moderno. Presente en compañías líderes de sectores como banca, retail o telecomunicaciones, Spark es hoy una de las soluciones más adoptadas a nivel global para análisis avanzado, inteligencia Artificial y toma de decisiones basadas en datos.

Índice de temas

¿Qué es Apache Spark y por qué es clave en entornos de datos modernos?

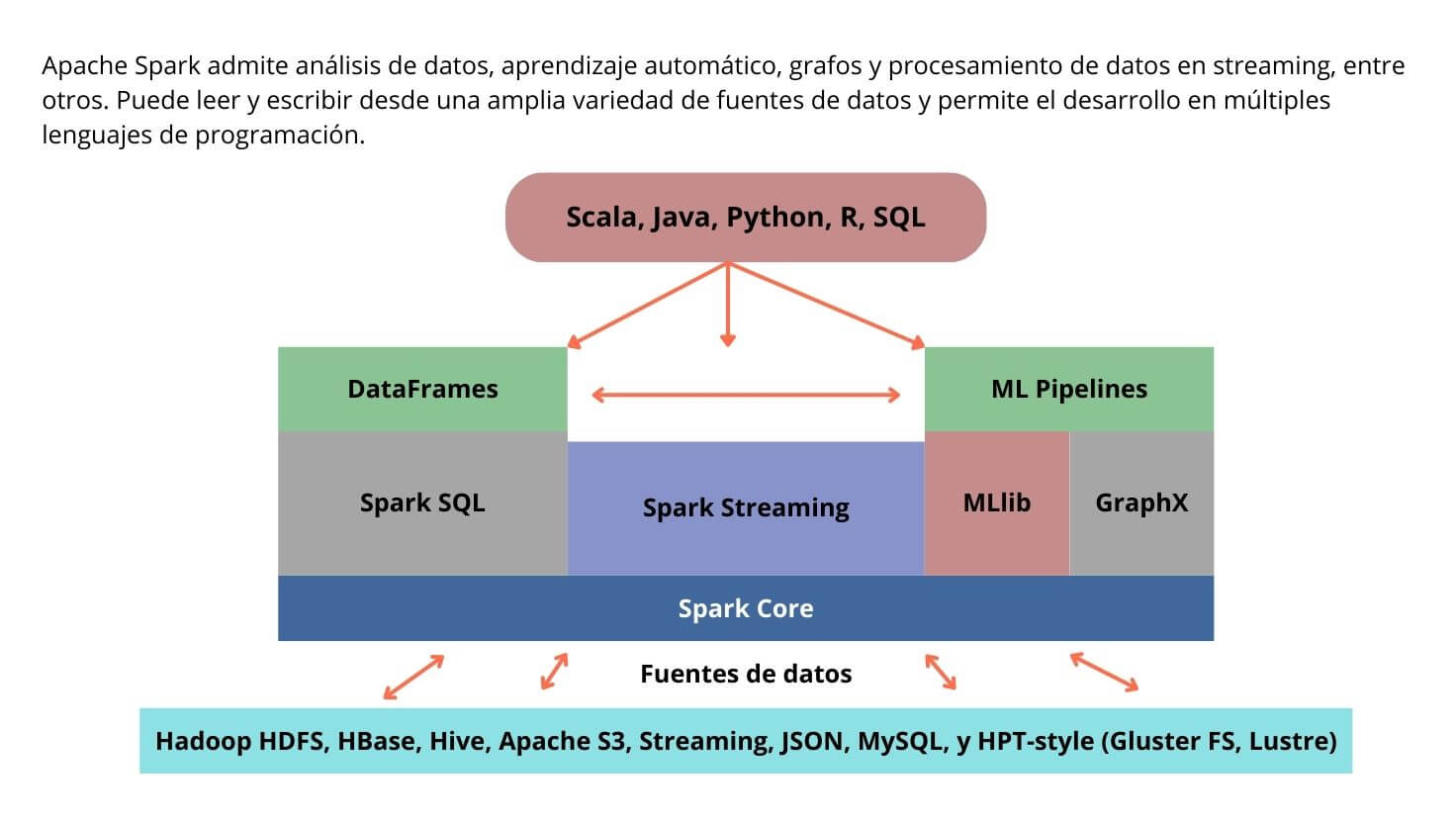

Apache Spark es un framework de software libre (open source), desarrollado inicialmente en la Universidad de California, Berkeley. No es un programa ‘cerrado‘ como Excel, sino una plataforma de cómputo que corre en clusters de computadores–conjunto de varios computadores (servidores) conectados entre sí– y que se integra con múltiples lenguajes (Python, Java, Scala, R, SQL).

A diferencia de tecnologías previas como Hadoop MapReduce, que procesaban datos en disco y con múltiples pasos intermedios, Spark introduce un modelo de procesamiento en memoria que reduce drásticamente la latencia y acelera los cálculos de manera significativa. Esto lo convierte en un motor de análisis unificado y de alto rendimiento, capaz de ejecutar cargas de trabajo muy diversas.

En pruebas de rendimiento y de acuerdo a un estudio publicado por la Revista de Tecnología de la Información Teórica y Aplicada (JATIT, por sus siglas en inglés), Spark demostró ser 2 veces más rápido en cargas tipo word count (prueba estándar que mide la velocidad al contar palabras en grandes volúmenes de texto) y hasta 14 veces más veloz en tareas como TeraSort (benchmark que evalúa la capacidad de ordenar un terabyte de datos o más), todo gracias a que mantiene los datos en memoria durante el procesamiento.

En entornos interactivos, su ejecución puede ser, según una investigación publicada por ACADEMIA, 10 a 100 veces más rápida que la de MapReduce, lo que lo convierte en una opción especialmente atractiva para procesamiento en tiempo real e iterativo.

Además de su motor central, Spark incorpora librerías de más alto nivel que amplían sus capacidades, lo que le da una ventaja clave frente a otras plataformas. Entre ellas destacan:

- Spark SQL, para consultas SQL y procesamiento de datos estructurados.

- MLlib, la librería de machine learning que facilita modelos predictivos y análisis avanzados.

- GraphX, para análisis de grafos y redes complejas.

- Structured Streaming, para el procesamiento de flujos de datos en tiempo real con cálculos incrementales.

¿Qué beneficios empresariales tangibles ofrece Spark frente a otras plataformas de análisis de datos?

Más allá de sus capacidades puramente técnicas, la adopción de Apache Spark se traduce en beneficios empresariales concretos y medibles.

La velocidad de su procesamiento en memoria recorta drásticamente los tiempos de análisis. Esto permite a las empresas acceder a información crítica casi al instante y reaccionar con agilidad frente a dinámicas cambiantes del mercado. Ejemplos como la detección de fraudes en tiempo real o la personalización de ofertas para clientes se benefician directamente de esta capacidad de respuesta inmediata.

Otro aspecto clave es su integración nativa con MLlib, la librería de machine learning de Spark. Gracias a ella, las empresas pueden diseñar, entrenar e implementar modelos predictivos sobre grandes volúmenes de datos sin tener que trasladar información a otras plataformas, simplificando procesos y reduciendo riesgos de pérdida de eficiencia.

Su arquitectura distribuida permite ejecutar cargas de trabajo en infraestructuras más accesibles o en entornos de nube, optimizando costos frente a sistemas más antiguos que requerían hardware especializado para manejar volúmenes equivalentes de datos.

Reportes como el de IDC han señalado que las organizaciones que adoptan Spark pueden experimentar un ahorro de hasta el 57 % en su costo total de propiedad, logrando un retorno de inversión (ROI) del 342 % en periodos muy cortos.

Estos beneficios entonces se reflejan en KPIs medibles como menor ‘time-to-insight’ (tiempo en obtener resultados útiles) y mayor retorno sobre la inversión (ROI) en infraestructura analítica:

| Beneficio | KPI Impactado | Impacto con Spark |

| Reducción de tiempos de procesamiento | Time-to-insight | Hasta 10–100x más rápido que MapReduce |

| Ahorro en infraestructura | Costos operativos de TI | Menos servidores necesarios gracias a ejecución en memoria |

| Integración con Machine Learning | Innovación en productos | Implementación de ML y análisis predictivo en pipelines de negocio |

| Procesamiento en tiempo real | Eficiencia operativa | Detección de fraude y respuestas inmediatas en retail/finanzas |

| Escalabilidad | Productividad | Capacidad de pasar de una laptop a clusters con petabytes de datos |

La adopción de servicios en la nube se expande con rapidez y se ha consolidado como un habilitador directo de la analítica a gran escala. Según la OECD, un número creciente de empresas ya incorpora soluciones cloud en sus procesos, lo que confirma su penetración en el tejido empresarial global. En este escenario, Apache Spark se integra de manera natural en arquitecturas multinube y orientadas a los datos, facilitando que las organizaciones aceleren la toma de decisiones estratégicas y ganen flexibilidad frente a los cambios del mercado.

¿En qué escenarios estratégicos conviene usar Spark y cuándo optar por otras soluciones?

Apache Spark se convierte en la opción más adecuada en entornos donde la velocidad y la versatilidad son fundamentales. Gracias a su modelo de procesamiento en memoria y a librerías como Structured Streaming, Spark permite ejecutar flujos de datos en tiempo real con tolerancia a fallos, aplicación de esquemas y mecanismos de checkpointing que garantizan la integridad de los datos, evitando duplicados o pérdidas.

En arquitecturas híbridas (on-premise + cloud), Spark ofrece:

- Integración natural con Kafka y Kubernetes.

- Escalabilidad dinámica, alta disponibilidad y baja latencia.

- Soporte para cargas críticas en tiempo real en múltiples entornos.

Sin embargo, Spark no siempre es la elección más eficiente. En entornos donde la prioridad está en contar con plataformas completamente gestionadas en la nube, con elasticidad automática y separación clara entre almacenamiento y cómputo, soluciones como Snowflake o Databricks pueden resultar más convenientes.

Finalmente, para cargas de trabajo puramente históricas o batch, donde la latencia no es un factor crítico, el ecosistema Hadoop MapReduce todavía puede ofrecer una solución viable y de menor coste. Aunque Spark lo supera en velocidad y flexibilidad, Hadoop sigue siendo útil cuando se requiere simplemente procesar grandes volúmenes de datos de manera secuencial sobre hardware básico.

La decisión final radica en un análisis riguroso de la latencia aceptable, el volumen y la velocidad de los datos, la complejidad de los análisis y las capacidades de integración con otras herramientas del ecosistema de datos.

| Caso de uso estratégico | Herramienta recomendada | ¿Por qué aquí? |

| Procesamiento en tiempo real / streaming | Apache Spark | Structured Streaming: baja latencia, tolerancia a fallos, gestión de esquemas y checkpointing integrado. |

| Entornos híbridos (on-premise + cloud) | Apache Spark + Kafka + Kubernetes | Orquestación distribuida, escalabilidad dinámica, alta disponibilidad y compatibilidad multi-cloud. |

| Workflows integrados batch + ML + SQL + grafos | Apache Spark | Motor unificado con librerías nativas (MLlib, Spark SQL, GraphX) optimizado para cargas mixtas en memoria. |

| BI basada en SQL, análisis estructurado fácil | Snowflake | Separación de cómputo y almacenamiento, elasticidad automática y optimización para consultas SQL en BI. |

| Carga batch histórica y almacenamiento económico | Hadoop MapReduce (o Data Lakes) | Procesamiento secuencial en disco, adecuado para ETL masivo con costo optimizado en hardware estándar. |

¿Cómo se integra Spark en un ecosistema tecnológico empresarial actual?

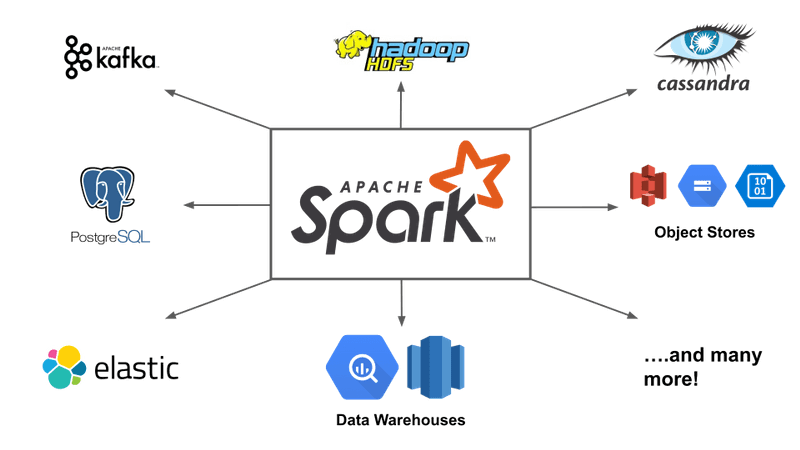

Más allá de su rendimiento, Spark destaca por su capacidad de integración dentro de arquitecturas empresariales complejas. Lejos de funcionar como un sistema aislado, actúa como un motor de cómputo distribuido capaz de orquestar datos provenientes de múltiples fuentes y formatos.

En entornos corporativos, Spark se conecta de forma nativa con sistemas de mensajería como Kafka, que alimentan flujos continuos de datos, y con motores de metadatos como Hive, que permiten gestionar de manera eficiente datos estructurados en grandes lagos de información.

En cuanto al despliegue, Spark se integra con Kubernetes para garantizar elasticidad, balanceo de carga y portabilidad en escenarios multicloud. Esto refuerza su posición como tecnología flexible, capaz de sostener arquitecturas distribuidas que necesitan moverse entre infraestructura local y servicios en la nube.

Para organizaciones que operan Spark sobre microservicios, service mesh y multinube, la guía del Instituto Nacional de Estándares y Tecnología (NIST, por sus siglas en inglés) ofrece un enfoque actualizado para proteger datos en aplicaciones cloud-native.

El NIST IR 8505 detalla estrategias de clasificación y protección de datos en tránsito y en entornos multicloud con WASM(WebAssembly) y mallas de servicio, útiles para reforzar políticas de gobernanza y cumplimiento en pipelines de datos.

Finalmente, su ecosistema modular —que incluye Spark SQL, MLlib, GraphX y Structured Streaming— permite que un mismo motor unifique cargas de análisis heterogéneas.

Como señaló Reynold Xin, co-fundador de Databricks y arquitecto principal de Spark: “Structured Streaming es el mejor intento hasta ahora de unificar streaming, consultas interactivas y batch, simplificando sustancialmente las aplicaciones continuas”.

Esta visión refuerza a Spark como pieza central del ecosistema empresarial, reduciendo la necesidad de desplegar múltiples tecnologías fragmentadas para distintos tipos de análisis.

¿Qué recursos humanos y tecnológicos requiere la implementación de Spark?

La adopción de Spark requiere tanto:

- Infraestructura adecuada (clusters, Kubernetes, sistemas de ingestión y monitoreo).

- Talento humano especializado (data engineers, ML engineers, arquitectos de datos, DevOps).

| Perfil técnico esencial | Habilidades / Conocimientos clave | ¿Por qué es importante en Spark? |

| Data Engineer | Programación en Python, Scala o JavaSQL avanzadoExperiencia en Spark, Kafka y orquestadores (Airflow, dbt)Optimización de jobs distribuidos | Diseña y mantiene pipelines de datos en Spark; garantiza rendimiento, escalabilidad y calidad en la ingestión y transformación de datos. |

| Arquitecto de Datos (Data Architect) | Modelado de datos (estructurados, semiestructurados, no estructurados)Conocimiento de lagos y warehousesGobierno y calidad del datoIntegración con Spark y Hive | Define la arquitectura global que permite a Spark integrarse con múltiples sistemas; asegura consistencia y disponibilidad de datos a escala. |

| ML Engineer / Data Scientist | Algoritmos de ML y estadísticaUso de MLlib en SparkFeature engineering en grandes volúmenes de datosValidación y despliegue de modelos | Aprovecha Spark MLlib para entrenar y escalar modelos predictivos en grandes datasets sin necesidad de mover datos a otras plataformas. |

| DevOps / SRE especializado en Big Data | Kubernetes y contenedoresAutomatización CI/CDMonitoreo y logging de clusters SparkSeguridad y gestión de recursos en cloud | Asegura la disponibilidad y resiliencia de Spark en producción; gestiona escalado automático, balanceo de carga y despliegues multicloud. |

Los desafíos de talento humano no son menores. Un estudio de McKinsey reveló que “la razón más citada es la brecha de habilidades, señalada por el 46 % de los encuestados, seguida por limitaciones de recursos, mencionadas por un 38 % como factor clave”.

A nivel tecnológico, se requiere una infraestructura flexible—ya sea propia o en la nube—que soporte Kubernetes y permita escalar, así como sistemas robustos de ingestión y almacenamiento (p. ej., Kafka, Hive o almacenes en la nube), orquestación de flujos (Airflow/dbt), y entornos de desarrollo similares a producción para optimizar Spark Jobs correctamente.

Finalmente, el ecosistema se completa con herramientas de monitoreo como Spark UI, Ganglia o Prometheus, cuya función es ofrecer visibilidad en tiempo real sobre el rendimiento de los clústeres, detectar cuellos de botella y garantizar la estabilidad de los procesos.

En resumen, los recursos humanos y técnicos deben estar alineados para formar una capacidad integral, capaz de diseñar, implementar y operar pipelines de datos complejos con Spark.

¿Qué errores se deben evitar al adoptar Spark en proyectos empresariales?

Uno de los errores más frecuentes al implementar Apache Spark a escala empresarial es una partición inadecuada de los datos, lo que puede derivar en cuellos de botella severos. Cuando los datos no se distribuyen equitativamente entre los nodos, aparece el data skew, que ralentiza toda la tarea de procesamiento.

Errores técnicos frecuentes al configurar Spark:

- Impacto directo en estabilidad y rendimiento.

- Memoria mal asignada (demasiada o insuficiente).

- Fallos como OutOfMemory, tiempos muertos y bajo uso de CPU.

Por otro lado, un análisis sobre frameworks de procesamiento masivo destaca que la presión de memoria y la gestión ineficiente del garbage collection reducen drásticamente el rendimiento del servidor y el throughput general.

También es habitual ignorar el shuffle costoso y no monitorear adecuadamente las transformaciones anchas. Operaciones como joins o agrupaciones pesadas generan movimiento masivo de datos entre nodos, lo que impacta el rendimiento y puede saturar la red. No prestar atención a estas dinámicas operativas puede causar demoras significativas y fallas de estabilidad.

Razón por la cual el monitoreo continuo se convierte en una práctica esencial: Apoyarse exclusivamente en las métricas internas de Spark puede generar puntos ciegos. El monitoreo continuo transforma la gestión de Spark de un enfoque reactivo a uno proactivo, asegurando rendimiento, eficiencia y resiliencia en entornos empresariales.

¿Cómo se compara Spark frente a plataformas cloud como Databricks, Snowflake o AWS EMR?

Apache Spark en modalidad open source ofrece:

- Máximo control y personalización (YARN/Kubernetes, más de 200 parámetros de ajuste).

- Librerías nativas para SQL, machine learning, grafos y streaming.

- Requiere más operación interna y equipos especializados.

Las plataformas gestionadas como Databricks, Snowflake o AWS EMR:

- Reducen la carga operativa y aceleran la adopción.

- Funcionan bajo esquemas de pago por uso, con menos flexibilidad en portabilidad y ajustes técnicos.

De acuerdo con estudios de política digital (OECD) y consultoría (McKinsey, IDC):

- La nube aporta elasticidad y rapidez en la entrega de valor.

- El verdadero retorno depende de la gobernanza de datos y el talento humano, no solo de la infraestructura.

Para facilitar la comparación, la siguiente tabla resume de forma ejecutiva las principales ventajas y limitaciones de Spark frente a plataformas cloud gestionadas:

| Criterio | Spark Open Source | Databricks | Snowflake | AWS EMR |

| Costo inicial | Bajo (infra propia) | Medio-Alto | Alto | Medio |

| Facilidad de uso | Requiere expertos | Muy alta | Alta | Media |

| Personalización | Muy alta | Alta | Limitada | Alta |

| Control de datos | Total | Alto | Medio | Medio-Alto |

En última instancia, la elección entre Spark y las plataformas cloud dependerá de una serie de factores estratégicos y operativos, entre los que destacan:

- Nivel de control requerido → Si la prioridad es personalización extrema y portabilidad multi-cloud/on-prem, Spark OSS en Kubernetes/YARN es la opción más flexible.

- Velocidad de adopción y simplicidad operativa → Si se busca minimizar fricción en despliegue y operación, una plataforma gestionada como Databricks o Snowflake reduce la complejidad inicial.

- Perfil de cargas de trabajo → Para cargas SQL/BI de gran escala y compartición de datos, Snowflake es más eficiente; para pipelines complejos Spark + ML/streaming, Databricks o Spark OSS son más adecuados.

- Estrategia de nube corporativa → Si el stack ya está en AWS, EMR integra mejor con servicios nativos; si se maneja un entorno multi-nube, Spark OSS o Databricks ofrecen más neutralidad.

- Gobernanza y compliance → Empresas que requieren gobernanza estricta y auditoría centralizada encontrarán más soporte en Snowflake/Databricks; quienes buscan formatos abiertos y control local preferirán Spark OSS.

- Costo total de propiedad (TCO) → Evaluar no solo tarifas cloud, sino también el costo de talento humano: plataformas gestionadas reducen la carga operativa, mientras Spark OSS exige un equipo más especializado.

Preguntas frecuentes

¿Cómo influye la Ley 1581 de 2012 en proyectos empresariales que usan Apache Spark en Colombia?

La ley exige que todo tratamiento de datos personales cuente con autorización del titular, medidas de seguridad y mecanismos de consulta y corrección. En Spark esto implica aplicar anonimización, auditoría y trazabilidad de datos procesados.

¿Qué diferencia hay entre la regulación de Colombia y el GDPR europeo para proyectos de Big Data?

El GDPR es más estricto en sanciones y transferencias internacionales, pero la Ley 1581 comparte principios como consentimiento, finalidad y responsabilidad. Las empresas en Colombia deben aplicar estándares equivalentes si trabajan con datos de la UE.

¿Qué sanciones puede imponer la SIC en Colombia por incumplir normas de protección de datos en entornos de Spark?

La SIC puede imponer multas de hasta 2.000 salarios mínimos legales mensuales vigentes, además de la suspensión de actividades de tratamiento de datos.

¿Cómo afecta la Ley 1581 a empresas multinacionales que operan Spark en varios países de Latinoamérica?

Las multinacionales deben cumplir simultáneamente con la Ley 1581 y las normativas locales de cada país (LGPD en Brasil, LFPDPPP en México, etc.), lo que obliga a diseñar arquitecturas de Spark con cumplimiento multinormativo.

¿Qué buenas prácticas pueden aplicar las empresas en Colombia para garantizar compliance en Spark?

Implementar privacy by design, establecer roles claros de oficial de protección de datos, cifrado en reposo y en tránsito, y auditorías periódicas de seguridad en pipelines de Spark.