En la vanguardia de la innovación las empresas enfrentan un panorama tecnológico en constante evolución, donde la Inteligencia Artificial (IA) se ha convertido en un motor de crecimiento y eficiencia. Sin embargo, este impulso transformador trae consigo una serie de desafíos intrínsecos que van más allá de la mera implementación técnica.

La auditoría de IA no es una carga regulatoria, sino como un pilar estratégico fundamental para gestionar riesgos, fomentar la transparencia y construir la confianza necesaria para prosperar. Es el mecanismo proactivo que asegura que la IA se use de manera responsable, ética y alineada con los objetivos corporativos y sociales.

Fiona C. Williams, socia de la firma EY y líder global en auditoría de tecnología, ha compartido algunas posturas al respecto, como por ejemplo que: “Estamos en un punto de inflexión donde la inteligencia artificial no solo es una herramienta para la auditoría, sino que se está convirtiendo en parte del ecosistema que debemos auditar. La auditoría de la IA en sí misma —su gobernanza, su ética y su seguridad— es el próximo gran desafío”.

Ya en materia de auditoría, por ejemplo, de gestión de calidad ISO 9001, al automatizar tareas repetitivas como la revisión de documentos y la recopilación de datos, lo que permite a los auditores ser más eficientes y precisos. Además, la IA utiliza análisis predictivo para anticipar riesgos y análisis de datos mejorado para descubrir ideas que los humanos podrían pasar por alto. El Procesamiento del Lenguaje Natural (PLN) facilita la revisión de documentos y las herramientas de auditoría virtual permiten un monitoreo flexible y continuo. Aunque la IA mejora la toma de decisiones y la objetividad, no reemplaza la necesidad de los auditores humanos, cuyo pensamiento crítico y juicio contextual siguen siendo esenciales para conducir auditorías significativas.

Índice de temas

¿Qué es una auditoría de Inteligencia Artificial y por qué es crucial para las empresas?

La auditoría de la Inteligencia Artificial es un proceso exhaustivo diseñado para revisar, evaluar y certificar que los sistemas de IA son transparentes, equitativos en sus decisiones, seguros y que cumplen con las regulaciones vigentes. Su alcance trasciende la verificación de estados financieros para abordar la gobernanza integral de los modelos de IA, evaluando tanto su diseño como su operatividad en la estructura de control interno de una compañía.

Para la alta dirección, la auditoría de IA es una herramienta crítica en la gestión de riesgos. Los algoritmos, por su opacidad o naturaleza de ‘caja negra’, pueden generar sesgos que comprometen la objetividad de las decisiones, un riesgo que un auditor debe ser capaz de detectar y corregir. En un entorno donde la Inteligencia Artificial es un objetivo prioritario para los ciberataques, la auditoría es vital para evaluar la seguridad de los sistemas e identificar posibles vulnerabilidades que pudieran ser explotadas.

La falta de transparencia en los sistemas de IA puede socavar la confianza en sus resultados, afectando la credibilidad tanto de los auditores como de la organización en general. La auditoría, en este sentido, se convierte en un mecanismo para promover una transparencia basada en valores que asegura que los algoritmos reflejen los principios éticos en su diseño y eviten la distorsión de los datos. El estudio global de Auditoría Interna de PwC reveló que casi el 50 % de las funciones de auditoría interna no abordan amenazas macroeconómicas clave, y solo el 6 % tienen un plan para hacerlo.

Esta brecha subraya la necesidad de que la auditoría interna evolucione y se posicione como la “última línea de defensa” contra los riesgos estratégicos, incluyendo los de la IA, lo cual es deseado por el 68 % de los líderes empresariales que buscan una participación temprana y proactiva de esta área en la evaluación de riesgos.

Un proceso de auditoría de IA eficaz sigue un ciclo de vida estructurado que asegura una revisión completa y sistemática. Este proceso no es un evento único, sino una serie de etapas interconectadas que culminan en la mejora continua de los sistemas. El diagrama de flujo de una auditoría, si bien adaptable a cada organización, típicamente incluye las siguientes fases clave, desde la selección del equipo hasta el seguimiento de las acciones correctivas.

Por ejemplo, el Instituto de Auditores Internos de España, aborda la auditoría interna de la Inteligencia Artificial (IA) aplicada a procesos de negocio. Explica la penetración de la IA en las empresas, detallando sus modelos y tipologías, incluida la IA Generativa. Además, establece un marco de control interno y los riesgos asociados con el despliegue de tecnología basada en IA, sugiriendo un programa de trabajo para la auditoría de estas estructuras de control. También propone mejores prácticas y recomendaciones para la gobernanza, evaluación de riesgos, actividades de control, información, comunicación y supervisión de los sistemas de IA, incluyendo aspectos como la calidad de los datos, la medición del desempeño, entre otros.

El proceso de auditoría de un sistema de IA se puede visualizar en las siguientes etapas:

- Planificación y alcance: La auditoría inicia con la selección del equipo auditor y la elaboración de un plan que define el alcance y los objetivos del trabajo. En esta fase, el auditor debe considerar la probabilidad de errores, fraude e incumplimientos.

- Ejecución y recopilación de evidencia: Se realiza el trabajo de campo. El equipo de auditoría revisa la documentación, evalúa las evidencias, y analiza el diseño y la operatividad de los controles internos. Esto incluye la revisión de datos, algoritmos y la arquitectura del sistema para comprender su funcionamiento y sus posibles vulnerabilidades.

- Evaluación de la evidencia: Los hallazgos se evalúan a la luz de los criterios de auditoría. Se analizan los sesgos, el rendimiento y el cumplimiento regulatorio.

- Reporte preliminar y reunión de cierre: Se elabora un informe preliminar con los hallazgos. Se realiza una reunión de cierre para comunicar estos resultados al equipo auditado, solicitando sus observaciones.

- Elaboración del informe final: Con base en el informe preliminar y las observaciones recibidas, se redacta el informe final de auditoría. Este documento debe ser claro, preciso y basarse en evidencia verificable.

- Seguimiento de las acciones: El proceso culmina con el seguimiento de las acciones identificadas para asegurar que las correcciones necesarias se implementen de manera efectiva.

La adopción de la IA en el panorama empresarial colombiano es un fenómeno en pleno auge, lo que hace que la necesidad de gobernanza y auditoría sea más apremiante que nunca. Según el QS World Future Skills Index 2025, el país experimentó un notable aumento del 669 % en el número de empresas que implementan IA entre 2018 y 2024, superando el crecimiento de países como Brasil, que registró un 487 % en el mismo periodo. Este dato coloca a Colombia en una posición de liderazgo en la Transformación Digital de la región.

La auditoría como un acto de innovación estratégica

La auditoría de IA va más allá del simple cumplimiento regulatorio o la mitigación de riesgos. Su verdadero valor reside en su capacidad para transformar una potencial amenaza en una ventaja competitiva. Al auditar la IA, una organización no solo protege sus activos y su reputación, sino que demuestra un compromiso con la ética y la transparencia que genera confianza en las partes interesadas, incluyendo inversionistas, clientes y reguladores.

La opacidad inherente a muchos sistemas de IA es un problema que puede generar litigios legales y sanciones regulatorias, dañando gravemente la reputación de una empresa. La auditoría aborda directamente este problema al exigir transparencia y trazabilidad en los procesos algorítmicos. De esta manera, se construye un vínculo sólido con la audiencia y se mitigan las posibles crisis reputacionales antes de que ocurran.

La auditoría de IA también es una oportunidad para que el departamento de auditoría interna se reinvente y se posicione como un socio estratégico de la alta dirección. Al auditar la IA, un área que encierra los mayores desafíos y oportunidades para la organización, el departamento de auditoría demuestra su relevancia y se convierte en un actor clave en la estrategia de la compañía. El juicio profesional del auditor, que no puede ser completamente reemplazado por la tecnología, sigue siendo esencial para interpretar el comportamiento de la IA y asegurar que refleje los valores fundamentales de la empresa.

¿Cuáles son los requisitos regulatorios clave que afectan a los proyectos de IA empresariales?

El rápido avance de la IA ha superado la capacidad de respuesta de los marcos regulatorios tradicionales, creando un laberinto de normativas que los directivos deben comprender para evitar sanciones y vulneraciones éticas. A nivel global y local, se están implementando leyes y políticas que buscan gobernar el desarrollo y uso de esta tecnología de manera responsable.

El Reglamento General de Protección de Datos (GDPR) de la Unión Europea ha sentado un precedente global en la protección de datos personales. Cualquier sistema de IA que procese datos personales debe cumplir con sus rigurosos requisitos de privacidad y consentimiento. El uso indebido o la falta de consentimiento en el tratamiento de datos puede acarrear multas de hasta 20 millones de euros o el 4 % del volumen de negocios total anual mundial.

Por su parte, la Ley de IA de la UE (EU AI Act) se ha convertido en la primera regulación integral del mundo sobre inteligencia artificial, estableciendo un sistema de clasificación basado en riesgos. Esta ley asigna obligaciones a proveedores y usuarios de IA en función del nivel de riesgo que el sistema representa para los derechos y la seguridad de las personas.

- Riesgo inaceptable: Los sistemas de IA en esta categoría están prohibidos. Esto incluye la manipulación conductual, el “social scoring” gubernamental, la categorización biométrica de personas y los sistemas de identificación biométrica remota en tiempo real en espacios públicos, con algunas excepciones limitadas para las fuerzas del orden con aprobación judicial. La prohibición de estos sistemas comenzó a aplicarse el 2 de febrero de 2025.

- Alto riesgo: Sistemas que podrían afectar negativamente la seguridad o los derechos fundamentales. Estos se dividen en dos categorías principales: los utilizados en productos sujetos a la legislación de seguridad de productos de la UE (como automóviles o dispositivos médicos) y los utilizados en áreas críticas como el empleo, la educación, la aplicación de la ley y la migración. Todos los sistemas de alto riesgo deben evaluarse antes de ser comercializados y a lo largo de su ciclo de vida.

- Requisitos de transparencia: Los modelos de IA generativa, como ChatGPT, que no se clasifican como de alto riesgo, deben cumplir con requisitos de transparencia. Esto implica revelar que el contenido fue generado por IA y publicar resúmenes de los datos con derechos de autor utilizados para su entrenamiento. Las multas por infracciones pueden alcanzar hasta 35 millones de euros o el 7 % del volumen de negocios total anual mundial.

El marco regulatorio de la IA en Colombia

En Colombia, el Consejo Nacional de Política Económica y Social (Conpes) ha formulado la Política Nacional de Inteligencia Artificial mediante el documento Conpes 4144 de 2025. Esta política, con una inversión aproximada de 479.273 millones de pesos, tiene como objetivo principal generar las capacidades necesarias para el “aprovechamiento ético y sostenible de sistemas de IA” en el país.

El Conpes 4144 se estructura en seis ejes estratégicos fundamentales:

- Ética y gobernanza: Fortalecer los mecanismos de gobernanza y aplicar principios éticos para asegurar un desarrollo responsable.

- Infraestructura y datos: Fortalecer la infraestructura tecnológica y la disponibilidad de datos representativos.

- Investigación, Desarrollo e Innovación (I+D+i): Impulsar la investigación para traducir los avances en conocimiento y beneficios sociales.

- Desarrollo de capacidades y Talento Digital: Formar talento digital y promover la apropiación social del conocimiento en IA.

- Mitigación de Riesgos: Definir medidas para la identificación y prevención de riesgos y efectos no deseados, como la exclusión digital.

- Uso y Adopción de la IA: Impulsar el uso de la IA en entidades públicas, el sector empresarial y los territorios.

Esta hoja de ruta estratégica se alinea con las recomendaciones de la OCDE, de la cual Colombia es miembro , y busca asegurar que la implementación de la IA en el país sea “equitativa y justa”. En 2024, el Ministerio de Ciencia, Tecnología e Innovación (MinCiencias) creó el Consejo Asesor Nacional de Expertos en Inteligencia Artificial (CANIA) para recibir asesoramiento especializado en el desarrollo y regulación de esta tecnología. (Conozca aquí más información de Leyes de IA y las obligaciones clave para empresas).

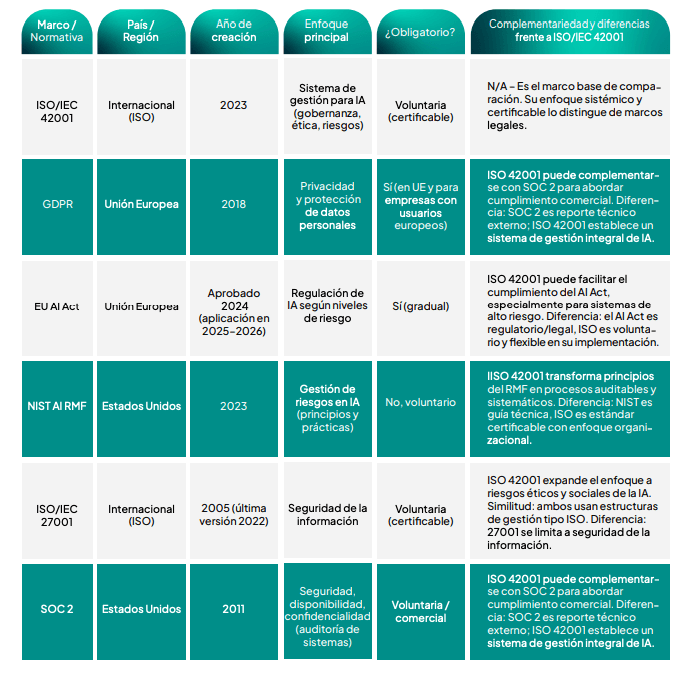

Por otro lado, Colombia ha avanzado en la adopción de la IA con una Política Nacional desde 2019, pero esta carece de mecanismos verificables para asegurar un uso ético y transparente en organizaciones públicas y privadas. Para llenar este vacío, ha surgido la norma ISO/IEC 42001, el primer estándar internacional certificable para sistemas de gestión de IA. Esta norma permite a las organizaciones alinear sus sistemas de IA con principios globales de responsabilidad, gobernanza y mitigación de riesgos.

La implementación de la norma ISO/IEC 42001 es una herramienta estratégica para reconstruir la confianza pública. Aborda desafíos como la baja confianza ciudadana en el manejo de datos sensibles y decisiones automatizadas, exigiendo:

- Evaluaciones éticas y de impacto de los algoritmos.

- Control de sesgos desde el diseño de los sistemas.

- Transparencia operativa y trazabilidad.

- Políticas sólidas de protección de datos y ciberseguridad.

Según William Vizcaíno, director general de NYCE en Colombia, “Colombia ya avanzó en la formulación de políticas públicas para la IA. El paso siguiente es asegurar que esos avances se traduzcan en confianza, sostenibilidad e impacto real. La ISO/IEC 42001 es el estándar que ofrece ese puente entre el compromiso y la acción verificable”. Además, la adopción de esta norma mejora la competitividad internacional y prepara a las empresas para regulaciones futuras como la Ley de IA de la Unión Europea.

El análisis del panorama regulatorio demuestra que la regulación de la IA no es un fenómeno aislado por país, sino una convergencia global liderada por marcos de referencia como la Ley de IA de la UE. La UE, al ser un mercado de gran tamaño, ha establecido un estándar que otras jurisdicciones están emulando. El hecho de que Brasil haya aprobado una ley similar en 2021 y que el Conpes 4144 de Colombia se enfoque en ejes estratégicos como la ética, la gobernanza y la mitigación de riesgos demuestra una alineación estratégica.

Para las empresas esto significa que la adopción de un marco de gobernanza robusto y la realización de auditorías de IA no es solo una obligación legal para operar en el país, sino una condición necesaria para acceder y competir en mercados internacionales. Las empresas que demuestren de manera proactiva su cumplimiento con los principios de transparencia, equidad y seguridad estarán mejor posicionadas para ganar la confianza de inversionistas y clientes globales, convirtiendo el cumplimiento en una poderosa ventaja competitiva. El reto es no percibir estas regulaciones como barreras, sino como una guía para el desarrollo responsable que, a su vez, facilita la expansión a nivel global.

| Regulación | Enfoque Principal | Requisitos Clave | Sanciones y Consecuencias |

| Ley de IA de la UE | Riesgo y Seguridad | – Clasificación de sistemas (inaceptable, alto, transparencia) – Prohibición de sistemas de riesgo inaceptable – Evaluación de conformidad para sistemas de alto riesgo – Requisitos de transparencia para IA generativa | Muy Graves: Hasta 35 millones de euros o 7% del volumen de negocios anual mundial. Leves: Hasta 7,5 millones de euros o 1% del volumen de negocios anual mundial. |

| GDPR | Privacidad y Protección de Datos | – Consentimiento para el tratamiento de datos personales – Derecho de los interesados (acceso, rectificación, supresión) – Evaluación de impacto sobre la protección de datos (DPIA) | Graves: Hasta 20 millones de euros o 4% del volumen de negocios anual mundial. |

| Conpes 4144 (Colombia) | Gobernanza y Ética | – Fortalecer mecanismos de gobernanza – Definir medidas de mitigación de riesgos – Promover la adopción ética en sectores público y privado – Fomentar la investigación y el talento digital | No especifica sanciones económicas directas, pero su incumplimiento expone a la empresa a riesgos legales, reputacionales y a la inobservancia de otros marcos regulatorios que sí las imponen. |

¿Cómo se lleva a cabo una auditoría efectiva de sistemas de IA en el entorno empresarial?

Una auditoría de IA no se improvisa. Requiere una metodología rigurosa que asegure la fiabilidad de los hallazgos y la utilidad de las recomendaciones. A continuación, se detallan las fases esenciales y un checklist práctico para guiar el proceso.

La fase de planificación es la brújula de la auditoría. El primer paso es definir con precisión el propósito y los objetivos del trabajo. El auditor debe considerar la “probabilidad de errores, fraude, incumplimientos y otras exposiciones significativas” al establecer los objetivos. Se debe identificar el sistema de IA a auditar, su propósito, sus componentes y, crucialmente, su nivel de riesgo. Una auditoría de un sistema de IA de alto riesgo, como uno utilizado en la selección de personal, requiere un alcance mucho.

Luego viene la fase de revisión de datos y modelo, aquí se centra en el corazón del sistema de IA. En primer lugar, se deben auditar los datos. Es esencial verificar la trazabilidad de las fuentes de datos y la documentación que justifique las características de los datos utilizados para entrenar el modelo. Un punto crítico es asegurar que se hayan definido procedimientos para identificar y eliminar sesgos en los datos de entrenamiento, ya que, si se utiliza ‘basura’, el modelo producirá ‘basura’.

En segundo lugar, se revisan los modelos y algoritmos. La auditoría debe examinar la arquitectura del sistema, la técnica de aprendizaje automático elegida y el algoritmo utilizado. Es fundamental que esta información esté documentada para fines de explicabilidad y auditoría.

En la fase de pruebas de desempeño y equidad la auditoría se vuelve práctica y evaluativa. Se realizan “pruebas de detalle y analíticas” para validar que la información financiera y operacional refleje la realidad del negocio. El auditor puede utilizar IA generativa para diseñar pruebas sustantivas o detectar “transacciones atípicas” o “movimientos inusuales” en un conjunto de datos.

Las pruebas deben ir más allá del rendimiento para incluir una evaluación de la equidad del modelo. Un enfoque híbrido que combine el juicio humano con la eficiencia de los sistemas automatizados es ideal para identificar y mitigar sesgos en los resultados. Los auditores deben ser capaces de “detectar y corregir estos sesgos para garantizar que las decisiones automatizadas sean justas y objetivas”.

Finalmente, la fase de documentación y reporte es la base de la credibilidad de la auditoría. El equipo auditor debe documentar información que sea suficiente, fiable, relevante y útil para respaldar sus conclusiones y hallazgos. El informe de auditoría es el producto final del proceso, y debe ser un documento claro y conciso que incluya los objetivos, la metodología, las ocurrencias verificadas, las observaciones, las conclusiones y las recomendaciones. Es crucial que el informe sea “representativo” y muestre la situación real de la empresa para dejar claro qué está fallando en los procesos o en el marco normativo. El director ejecutivo de auditoría es el responsable final de revisar y aprobar la comunicación de los resultados antes de su difusión a las partes interesadas.

Checklist esencial para una Auditoría de IA

La siguiente lista de verificación es una herramienta práctica para guiar a los directivos y sus equipos a lo largo de una auditoría de IA, asegurando que se cubran los aspectos más críticos del proceso.

Sección 1: Gobernanza y Cumplimiento

- [ ] ¿Existe un marco de gobernanza (e.g., GRC) formal para los sistemas de IA?

- [ ] ¿Se han definido claramente los roles y responsabilidades para la supervisión del ciclo de vida de la IA?

- [ ] ¿El sistema de IA ha sido clasificado según su nivel de riesgo de acuerdo con los marcos regulatorios aplicables (ej. Ley de IA de la UE)?

- [ ] ¿Se han documentado los criterios de selección para los auditores y se ha verificado su independencia?

Sección 2: Datos

- [ ] ¿Están documentadas las fuentes de datos utilizadas para el entrenamiento y la operación del modelo?

- [ ] ¿Se ha realizado un análisis para identificar y mitigar posibles sesgos en los datos de entrenamiento?

- [ ] ¿Se han implementado medidas técnicas y organizacionales para proteger los datos personales procesados por el sistema de IA?

Sección 3: Modelos y Algoritmos

- [ ] ¿Está documentada y justificada la elección de la técnica de aprendizaje automático y el algoritmo?

- [ ] ¿Se han realizado pruebas de desempeño, robustez y equidad para validar el comportamiento del modelo?

- [ ] ¿Existe un mecanismo de supervisión humana para las decisiones críticas tomadas por la IA?

- [ ] ¿Se han verificado las “salidas” del modelo para asegurar que los resultados no amplifiquen sesgos preexistentes?

Sección 4: Seguridad y Monitoreo

- [ ] ¿Se ha realizado un análisis de riesgos para identificar vulnerabilidades de ciberseguridad?

- [ ] ¿Existen mecanismos de monitoreo continuo para detectar anomalías y desviaciones del modelo en tiempo real?

- [ ] ¿Se han implementado medidas de resiliencia para que el sistema de IA pueda resistir ataques?

- [ ] ¿Hay un registro de auditoría que documente las decisiones de la IA y la razón de las mismas?

¿Qué errores comunes pueden invalidar una auditoría de IA o exponer a la empresa a sanciones?

A pesar de la creciente adopción de la IA, muchas empresas cometen errores fundamentales que pueden invalidar una auditoría y exponer a la organización a severas consecuencias legales y financieras. Los directivos deben ser conscientes de estos fallos para implementar controles efectivos.

Uno de los errores más comunes es la falta de trazabilidad en el ciclo de vida de la IA. No documentar las decisiones y criterios utilizados durante la auditoría dificulta la reproducibilidad del proceso y la explicación de los resultados. La ausencia de un registro de auditoría hace “imposible justificar ante un regulador” por qué se tomó una decisión basada en una recomendación algorítmica. Esta opacidad técnica, también conocida como el problema de la “caja negra,” compromete la confianza y la legalidad de las decisiones automatizadas.

La documentación incompleta es otro fallo grave. El uso extensivo de la IA requiere procesar grandes volúmenes de datos, muchos de los cuales pueden ser personales o sensibles. El uso indebido o la falta de consentimiento en el tratamiento de estos datos, si no están debidamente documentados, puede derivar en “sanciones legales, demandas y pérdida de confianza”.

Los sesgos son un riesgo inherente y a menudo invisible en los sistemas de IA, con el potencial de generar resultados injustos y discriminatorios. Según el NIST, existen tres fuentes principales de sesgo :

- Sesgo en los datos de entrenamiento: Ocurre cuando los conjuntos de datos no son representativos de la población a la que se aplicará el modelo. Por ejemplo, un algoritmo de reconocimiento facial entrenado con una sobrerrepresentación de personas blancas puede generar errores al intentar reconocer a personas de color.

- Sesgo algorítmico: Es causado por errores de programación o por desarrolladores que, de manera consciente o inconsciente, ponderan injustamente ciertos factores. Esto puede llevar a que un modelo de IA discrimine involuntariamente a personas de un determinado género o etnia.

- Sesgo cognitivo: Se refiere a los sesgos humanos que se incorporan en el sistema de IA a través de la selección de datos o la ponderación. El NIST destaca que esta fuente de sesgo es más común de lo que se cree.

Además de los sesgos técnicos, los auditores también deben ser conscientes de sus propios sesgos cognitivos, que pueden sabotear su objetividad. Estos incluyen el sesgo de confirmación (la tendencia a buscar información que confirme creencias previas) y el sesgo de autoridad (la tendencia a confiar más en las acciones de figuras de poder, como un CEO, sin cuestionarlas). Estos sesgos del auditor pueden llevar a que se pasen por alto señales de alerta o se ignoren irregularidades, comprometiendo la calidad de la auditoría misma.

Los errores de gobernanza, técnicos y humanos pueden tener consecuencias directas y cuantificables para la empresa.

| Fallo Común | Consecuencia de Negocio Directa | Ejemplo de Consecuencia Cuantificable |

| Falta de Trazabilidad y Explicabilidad | Pérdida de confianza de clientes y reguladores; Imposibilidad de justificar decisiones; Daño reputacional. | Litigios legales y sanciones regulatorias. Un banco fue multado con 30 millones de dólares en 2023 por un modelo de IA que discriminó a solicitantes de minorías. |

| Documentación Incompleta | Incumplimiento regulatorio; Dificultad para realizar auditorías de seguimiento; Riesgo de sanciones legales. | Multas por incumplimiento de GDPR (hasta 4% del volumen de negocios) o de la Ley de IA de la UE (hasta 7% del volumen de negocios). |

| Sesgos no Gestionados | Resultados injustos y discriminatorios; Pérdida de clientes de grupos demográficos; Daño a la marca. | Un algoritmo de trading impulsado por IA perdió 440 millones de dólares en minutos porque no era supervisado adecuadamente. |

| Ausencia de Controles de Supervisión | Brechas de seguridad; Manipulación del modelo; Decisiones erróneas y no justificadas. | Aumento del 74% en los ciberataques contra la IA en 2023. |

El mayor riesgo que enfrentan las organizaciones no es el mal uso intencional de la IA, sino la inacción y la falta de supervisión. La negligencia o una auditoría superficial que no considera la actualización y adaptación continua del modelo pueden dejar a la empresa expuesta a desviaciones generadas por actualizaciones o cambios en el entorno. Un algoritmo no da “señales de advertencia cuando se desvía del rumbo“. La falta de supervisión continua puede llevar a pérdidas financieras masivas y a la pérdida de la confianza de los clientes.

Las consecuencias financieras de estos errores son reales y severas. Las multas millonarias impuestas por reguladores demuestran que la falta de gestión de riesgos no es un problema técnico, sino un riesgo de negocio crítico. Por lo tanto, la auditoría de IA se presenta como un mecanismo de gestión proactiva, indispensable para garantizar que el sistema funcione a favor de la empresa y no en su contra. La inacción en este campo es, de hecho, el riesgo más grande de todos.

¿Cómo seleccionar auditores y equipos especializados en cumplimiento de IA?

La selección de un equipo de auditoría competente y especializado en IA es un factor determinante para el éxito de una auditoría. El perfil del auditor de IA ha evolucionado, requiriendo un conjunto de habilidades que va más allá del conocimiento técnico tradicional.

El auditor de IA ideal es un observador hábil, un comunicador empático y preciso, un analista riguroso y un facilitador del cambio. No solo debe dominar las metodologías de auditoría, sino también comprender la tecnología de la IA y el contexto de negocio en el que opera la organización. Los criterios de selección clave para estos profesionales incluyen:

- Experiencia: Es esencial que el auditor tenga experiencia demostrada en auditorías de sistemas de gestión y procesos de negocio.

- Independencia: Un auditor debe actuar con total objetividad y sin sesgos que puedan influir en los resultados del trabajo.

- Conocimiento Sectorial: Debe estar familiarizado con la industria, sus riesgos específicos y las regulaciones aplicables para realizar una auditoría relevante y efectiva.

- Madurez Emocional: El auditor debe ser capaz de mantener la calma en situaciones desafiantes y comunicarse con tacto, construyendo puentes en lugar de muros.

Un equipo de auditoría robusto combina una variedad de habilidades para garantizar una cobertura integral.

| Competencia | Habilidades y Conocimientos Clave |

| Competencia Técnica | – Conocimiento de machine learning y técnicas de IA. – Habilidad para analizar grandes volúmenes de datos. – Comprensión de seguridad de la información y ciberataques. – Capacidad para revisar y comprender el comportamiento del algoritmo y la forma en que genera y verifica los datos. |

| Competencia Profesional | – Liderazgo, gestión de proyectos y comunicación profesional. – Pensamiento sistémico y análisis de datos. – Capacidad de resolución de conflictos. – Habilidad para documentar hallazgos de forma clara y concisa. |

| Competencia Ética | – Imparcialidad, objetividad y discreción. – Respeto por las personas y procesos. – Capacidad de ejercer un juicio profesional sin dejarse influenciar por figuras de autoridad o familiaridad. |

Las certificaciones profesionales son un medio para validar y demostrar la experticia de un auditor. En el campo de la IA, su importancia es creciente.

- Certified Internal Auditor (CIA): Considerada el estándar de oro global para la auditoría interna, la certificación CIA del Instituto de Auditores Internos (IIA) valida los conocimientos y habilidades necesarios para llevar a cabo responsabilidades de auditoría en cualquier parte del mundo.

- Certified Information Systems Auditor (CISA): Una de las credenciales más reconocidas en el sector de la auditoría de sistemas de información.

- Advanced AI Audit (AAIA): La certificación más reciente y especializada en el campo, ofrecida por ISACA. Es la “primera certificación avanzada de auditoría de IA del mundo” y está diseñada para profesionales con certificaciones previas como CISA, CIA o CPA. La certificación AAIA dota a los auditores de las habilidades necesarias para liderar en el campo de la auditoría de IA, abarcando tres dominios clave: gobernanza y riesgo de IA, operaciones de IA, y herramientas y técnicas de auditoría de IA.

El auditor de IA del futuro es un profesional híbrido, que no solo posee conocimientos técnicos profundos, sino que también tiene la madurez personal y la sensibilidad humana para ejercer un juicio profesional sólido. La capacidad de un auditor para detectar y mitigar sesgos cognitivos, como el sesgo de confirmación o el sesgo de autoridad , es una habilidad humana que las herramientas automatizadas no pueden replicar por sí solas. La auditoría de IA no debe reemplazar el juicio profesional del auditor, sino complementarlo para acelerar el trabajo sin sacrificar la rigurosidad.

¿Qué herramientas y metodologías pueden facilitar la auditoría y el cumplimiento en IA?

La auditoría de IA, en su forma más avanzada, no es un evento puntual sino un proceso vivo y continuo que se apoya en marcos de gobernanza y herramientas tecnológicas. Los directivos deben entender cómo estas metodologías y herramientas se combinan para crear un ecosistema de cumplimiento robusto y proactivo.

Para gestionar los riesgos de la IA de manera sistemática, las organizaciones deben adoptar un enfoque de Gobernanza, Riesgo y Cumplimiento (GRC). Este modelo integral alinea la ética, la gestión de riesgos y el cumplimiento regulatorio en un solo marco, lo que ayuda a reducir el desperdicio, aumentar la eficiencia y compartir la información de manera más eficaz.

Los marcos de gobernanza, como el NIST AI Risk Management Framework (AI RMF), se centran en la construcción de sistemas de IA confiables a través de funciones como la gobernanza, el mapeo, la medición y la gestión de riesgos. Un ejemplo práctico de esto es la clasificación de riesgos de IA con un enfoque de “semáforo” (zona roja para riesgos críticos, amarilla para moderados y verde para bajos), lo que permite a los directivos visualizar y priorizar las amenazas de manera clara.

La norma internacional ISO/IEC 42001:2023 es otro pilar fundamental. Esta norma ayuda a las organizaciones a implementar políticas, roles y procesos para gestionar el riesgo de la IA de manera que se ajuste a los estándares globales, lo cual es especialmente útil para empresas que operan en múltiples jurisdicciones.

El estudio, titulado ‘Perspectivas sobre el estado de la Inteligencia Artificial en Latinoamérica: Oportunidades, Riesgos y el Papel de la ISO/IEC 42001‘, es un análisis exhaustivo que evalúa el panorama de la IA en la región Se enfoca en la adopción tecnológica, los riesgos emergentes y las oportunidades para una implementación ética y sostenible. El análisis fue realizado por un equipo multidisciplinario que revisó literatura académica, marcos normativos internacionales e informes técnicos, con el objetivo de proveer una perspectiva integral del ecosistema de IA en Latinoamérica. A diferencia de otros estudios, este se centra en el manejo responsable, la regulación y la certificación de la IA para un impacto estratégico.

La norma ISO/IEC 42001:2023 se presenta como una herramienta clave para la gestión de estos riesgos, permitiendo a las organizaciones demostrar que sus sistemas de IA son responsables, confiables y auditables. La certificación bajo esta norma, que es voluntaria, puede ser una ventaja estratégica para acceder a mercados globales, generar confianza con clientes y reguladores, y atraer talento. La implementación de esta norma ayuda a las empresas a alinear la IA con sus objetivos de negocio, asegurar la transparencia y gestionar el riesgo de forma sistemática.

Por otro lado, el mercado de software de auditoría ha evolucionado para ofrecer herramientas especializadas en la gestión de auditorías de IA. Plataformas como AuditBoard, Workiva, y TeamMate+ permiten centralizar los programas de auditoría, automatizar la planificación, ejecutar pruebas de control y generar informes. Estas soluciones ayudan a optimizar los flujos de trabajo y a reducir el esfuerzo manual, mejorando la precisión y la eficiencia.

actuar como un marco integrador, creando sinergias entre lo técnico, lo legal y lo organizacional. Su estructura permite adoptar los principios de marcos como NIST, cumplir con obligaciones del AI Act o GDPR, y articularse con normas de ciberseguridad como ISO 27001, Fuente: Perspectivas sobre el estado

de la Inteligencia Artificial en Latinoamérica: Oportunidades, Riesgos y el Papel de la ISO/IEC

42001de NYCE.

La verdadera transformación, sin embargo, se encuentra en la automatización inteligente, que combina la Automatización Robótica de Procesos (RPA) con tecnologías de IA como el aprendizaje automático y el procesamiento de lenguaje natural. Esta sinergia permite automatizar tareas repetitivas y, lo que es más importante, transformar las auditorías programadas en un “monitoreo continuo”. La automatización inteligente impulsa un “ciclo de retroalimentación y aprendizaje continuos destinados a perfeccionar y, en última instancia, transformar las operaciones”. Los paneles en tiempo real pueden detectar anomalías y alertar a los equipos de auditoría, permitiéndoles centrarse en la resolución de problemas estratégicos en lugar de en la revisión manual de datos.

Checklist de herramientas y metodologías

| Criterio | Preguntas de Evaluación |

| Frameworks de Gobernanza | – ¿Se ha adoptado un marco formal (ej. NIST, ISO 42001, GRC) para la gestión del riesgo de IA? – ¿Se utiliza una matriz de riesgos para clasificar y priorizar las amenazas de la IA? |

| Herramientas de Auditoría | – ¿Qué software de gestión de auditorías se utiliza para la planificación, ejecución y reporte? – ¿El software permite la colaboración entre equipos y la centralización de la documentación? |

| Automatización | – ¿Se están utilizando tecnologías como RPA o IA para el monitoreo continuo de los modelos y datos? – ¿El sistema permite detectar patrones anómalos en tiempo real y activar flujos de remediación automáticos? |

| Métricas y KPI | – ¿Se han definido métricas para medir el rendimiento, la equidad y la explicabilidad del modelo? – ¿Se utilizan paneles de control para visualizar en tiempo real los indicadores de riesgo de la IA? |

¿Cómo comunicar resultados y planes de acción derivados de la auditoría de IA a los directivos?

El último paso de una auditoría de IA es la comunicación de sus resultados. Un informe técnico, lleno de jerga y datos crudos, no será efectivo para la alta dirección. El informe debe ser un documento estratégico que “traduzca la complejidad a la simplicidad” para que los directivos “puedan tomar decisiones más rápidas y mejores”.

La clave para una comunicación efectiva es la capacidad de sintetizar hallazgos complejos en términos de riesgo de negocio, cuantificando su impacto financiero y reputacional. Las comunicaciones deben incluir “las conclusiones aplicables así como también las recomendaciones aplicables y/o los planes de acción”. Los resultados deben ser presentados con representatividad y la visibilidad en tiempo real que ofrecen las plataformas de GRC.

Es fundamental no solo enumerar los problemas, sino también reconocer el desempeño satisfactorio para fomentar una relación constructiva. El reporte debe ser un catalizador que empodere a la alta dirección a tomar el control de la IA y a convertir los hallazgos en una oportunidad de mejora.

El reporte de auditoría no es el punto final, sino el inicio de la acción directiva. El reporte es la herramienta que vende la necesidad de la gobernanza de la IA a aquellos que toman las decisiones finales. Los auditores internos tienen la responsabilidad de contribuir a la estrategia de la Función de Auditoría Interna a través de una comunicación efectiva. Esto significa que el reporte debe ir más allá de los datos brutos y ofrecer perspectivas, previsiones y valor.

Al cuantificar los riesgos en términos financieros y de reputación y al proponer soluciones priorizadas, el auditor capacita a la alta dirección para tomar el control de una tecnología que, de lo contrario, podría percibirse como una “caja negra” incomprensible. La calidad de la comunicación define si un hallazgo se convierte en una sanción o en una oportunidad estratégica de mejora.