La fase de fascinación automática por la Inteligencia Artificial (IA) toca su fin e inicia una etapa de rigor operativo y de exigencia empresarial. En 2026, las organizaciones ya no se preguntan qué puede hacer la tecnología sino cuánto cuesta, quién es responsable de sus fallos y cómo se auditan sus decisiones automatizadas.

Llega la rendición de cuentas, en la cual las organizaciones ya no se conforman con pilotos y promesas, sino que empiezan a exigir métricas claras de retorno, gobierno robusto de datos y garantías de confiabilidad técnica y ética.

Este cambio de paradigma, denominado el ‘Reality Check’ de la IA, marca una transición donde el éxito ya no se mide por la adopción, sino por la evidencia de resultados, la trazabilidad y el gobierno de los datos.

Índice de temas

¿Qué es el ‘Reality Check’ de la IA y por qué ocurre en 2026?

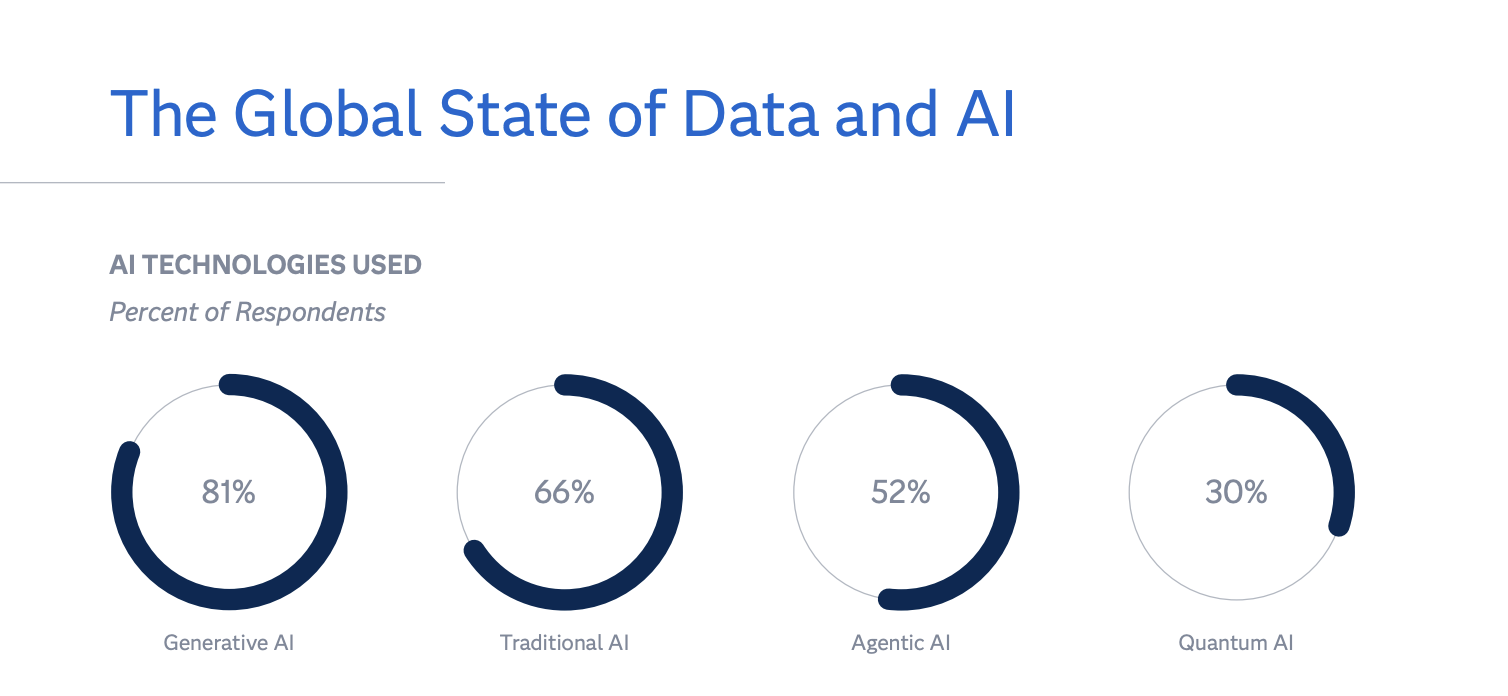

De acuerdo con el estudio global de SAS e IDC: ‘Data and AI Impact Report: The Trust Imperative’, basado en una encuesta realizada a 2.375 responsables de negocio y TI en Norteamérica, Latinoamérica, Europa, Medio Oriente, África y Asia-Pacífico, 65 % de las organizaciones ya usa alguna forma de IA y 32 % planea adoptarla en los próximos 12 meses. Sin embargo, solo alrededor de una tercera parte de las empresas que han invertido en IA ha podido demostrar de manera consistente un retorno sobre la inversión, lo que anticipa una depuración de proyectos que no entregan resultados medibles.

En este contexto, SAS —empresa con 50 años de trabajo en analítica y datos— interpreta 2026 como el año del ‘AI Reality Check’, en el que el entusiasmo convive con dudas legítimas sobre costos, trazabilidad y responsabilidad ante fallos. El mercado, resume la compañía, está cambiando el tipo de preguntas: “¿cuánto cuesta operar IA a escala?, ¿qué impacto medible deja?, ¿quién responde cuando falla?, ¿cómo se audita una decisión automatizada?”.

¿Por qué existe un “dilema de confianza” en las empresas?

El estudio nos presenta el “dilema de confianza”, el cual dice que mientras el 78 % de las organizaciones afirma confiar plenamente en la IA, solo el 40 % ha invertido en controles que la hagan confiable, con evidencia demostrable. Esta desalineación genera riesgos operativos y regulatorios, especialmente cuando la IA se aplica a decisiones sensibles sin una supervisión clara.

Esta brecha tiene efectos prácticos: proyectos que no escalan, retornos que no se materializan y una exposición mayor a riesgos operativos, regulatorios y reputacionales, especialmente cuando se automatizan decisiones sensibles sin auditoría ni responsables claros. El propio estudio advierte que en organizaciones con baja “trustworthiness” (confiabilidad demostrable), la IA generativa es usada y confiada hasta tres veces más que el Machine Learning tradicional, pese a que este último suele ser más explicable, lo que aumenta el riesgo de dependencia excesiva de modelos opacos.

¿En qué sectores se está viendo un retorno de inversión real?

El reporte relaciona madurez en IA responsable con mejor retorno económico: a mayor calidad de gobierno, explicabilidad y gestión de riesgo, mayor ROI. Según el índice de retorno reportado (valor generado por cada dólar invertido), los mejores resultados se asocian con objetivos estratégicos como mejorar la experiencia de cliente (1,83), ampliar participación de mercado (1,74) y fortalecer la resiliencia del negocio (1,71), mientras que la reducción de costos muestra el ROI más bajo (1,54).

En sectores como el financiero, Iván Herrera, gerente del territorio financiero en SAS para Colombia y Ecuador, describe tres áreas donde ese retorno ya es evidente: aprobación de créditos en tiempos casi inmediatos, con impacto directo en colocación; modelos de cobranza que convierten un atraso en oportunidad de refinanciación y fidelización; y sistemas antifraude en tiempo real, donde una detección eficaz en cuestión de horas evita pérdidas significativas para entidades y personas usuarias. “En esos casos se ha demostrado que la IA sí tiene retorno, porque acorta procesos, mejora la efectividad de campañas y protege millones de pesos en transacciones”, explicó Herrera.

Por otro lado, Jalena Correa, consultora analítica sénior para SAS Latinoamérica, subraya el potencial en el sector gobierno, donde el uso de datos sintéticos podría facilitar la colaboración entre entidades sin comprometer información real. “El sector público ya está en una etapa de transición y su intención de inversión (24,5 %) supera incluso la percepción de confianza actual (15,3 %), lo que representa una oportunidad para modernizar servicios ciudadanos”, afirmó Correa.

¿Cómo transformará la IA agéntica la eficiencia operativa?

El estudio prevé que 2026 acelere la conversación sobre IA agéntica, con sistemas capaces no solo de recomendar, sino de ejecutar tareas y coordinar flujos de trabajo en equipos híbridos humano–máquina. Esto promete ganancias de eficiencia, pero eleva el estándar de control: cuando un sistema actúa sobre procesos reales, la gobernanza deja de ser un anexo y se convierte en requisito operativo (límites claros, supervisión humana, trazabilidad y pruebas de seguridad).

Sin embargo, esta capacidad de ejecución eleva los requisitos de control. Según el estudio de SAS, los principales frenos para escalar estos sistemas incluyen entornos de datos no optimizados (49 %), un gobierno de datos insuficiente (44 %) y escasez de personal especializado (41%). A esto se suma la presión por costos de infraestructura, energía y centros de datos, que obliga a priorizar por criticidad, eficiencia de cómputo y arquitecturas híbridas que devuelvan a las organizaciones mayor control sobre sus datos y modelos, en especial en sectores regulados.

Jalena Correa también explica que este ciclo de vida del agente requiere un aprendizaje continuo: “El sistema debe percibir, entender, decidir, actuar y aprender de cada decisión tomada para ser efectivo en un entorno empresarial”.

¿Qué impacto tendrá la computación cuántica y las arquitecturas híbridas?

Hacia el futuro cercano, la conversación comienza a integrar la Inteligencia Artificial Cuántica (Quantum AI). Aunque su uso comercial es incipiente (30 %), su valor radica en procesar volúmenes masivos de datos que hoy resultan costosos o lentos para los algoritmos tradicionales.

A la par, gana fuerza un enfoque pragmático en infraestructura: las arquitecturas híbridas. Muchas empresas están regresando a modelos donde combinan nubes públicas con nubes privadas para recuperar el control sobre procesos críticos y sensibles. Se estima que para 2028 el 40 % de las organizaciones adopte este esquema híbrido para optimizar costos y garantizar la soberanía de sus datos.

¿Cuáles son las recomendaciones de SAS para una IA sostenible?

Con base en sus predicciones y en el reporte global, SAS plantea cinco líneas de acción para 2026:

- Escalar menos pilotos y más casos de uso con indicadores de negocio claros.

- Incorporar el gobierno de datos y modelos “por diseño”.

- Preparar arquitecturas e integraciones para IA agéntica.

- Fortalecer habilidades y cultura para operar y supervisar sistemas.

- Alinear la confianza declarada con la evidencia que aportan controles, pruebas y métricas de desempeño y riesgo.

Para América Latina, la compañía sostiene que el reto no es simplemente adoptar IA, sino adoptarla bien: con datos en orden, modelos gobernados, operación sostenible y retorno demostrable.